SCRAPY命令详解(可能是如今最全最简单的scrapy命令解释)

明天上班,又要爬网站,现在每天做的工作有50%的时间爬网站,40%的时间清理数据,10%写报告。若想自学数据分析,侧重点很重要,我当初把大部分经历放在了python的pandas numpymatplotlib上面,其他时间一部分放在sql身上,一部分放在了业务上,今天sh顺便总结了一下scrapy 所用的命令,敢说除了官方文档我这可能是最全最容易入门的命令详解了。

1.创建一个新的项目

scrapy startproject +一个项目的名称

我们可以进入创建的项目执行相关的命令 cd +demo1

2.生成爬虫

scrapy genspider +文件名+网址

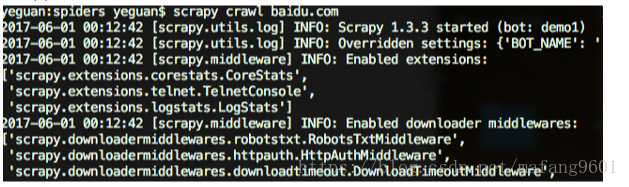

3.运行(crawl)

scrapy crawl +爬虫名称

4.check检查错误

scrapy check

5.list返回项目所有spider名称

scrapy list

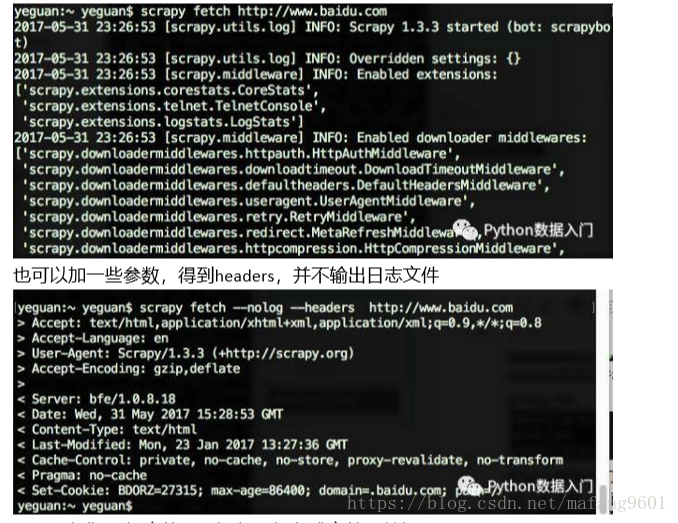

6.fetch 帮助我们下载网页,将网页源代码返回(前面是一些日志,后面是源代码)

7.view请求Url,把它的网页源代码保存成文件,并打开网页

在做网页测试的时候很有用,可以测试ajax内容,我们知道淘宝的页面很复杂,很多网页内容都是用ajax保存的。

很多内容没有加载,采取其他方式爬ajax内容

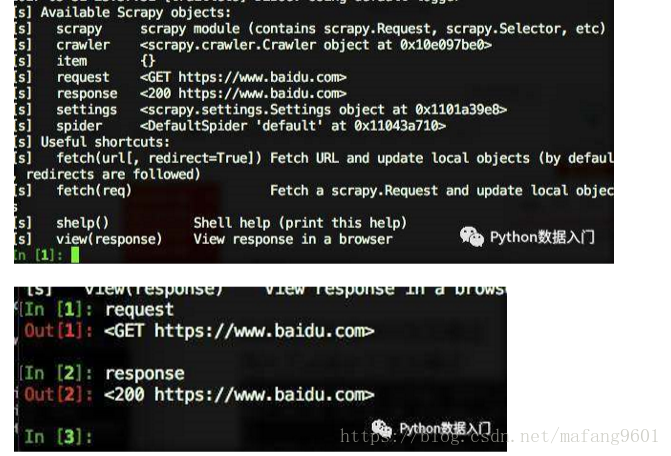

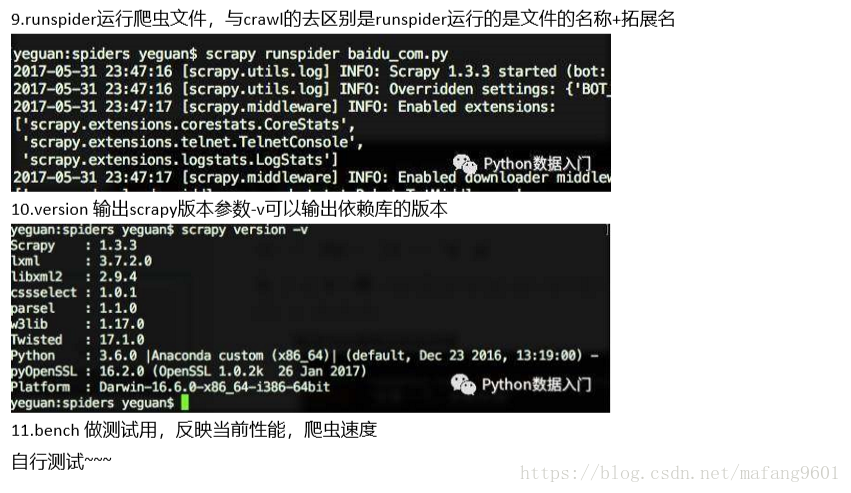

8.shell方法,命令行交互模式

传入了url进入了交互模式

甚至可以调用CSS选择器