ACKNOWLEDGEMENTS: The authors thank Nicholas Carlini (UC Berkeley) and Dimitris Tsipras (MIT) for feedback to improve the survey quality. We also acknowledge X. Huang (Uni. Liverpool), K. R. Reddy (IISC), E. Valle (UNICAMP), Y. Yoo (CLAIR) and others for providing pointers to make the survey more comprehensive. This research was supported by ARC grant DP160101458.

摘要:深度学习时现在飞速发展的人工智能的核心技术。在计算机视觉领域,它已成为从自动驾驶以及监控安防应用邻域的主力军。尽管神经网络已经被证明在解决复杂问题的领域(通常超越人类的能力范围)取得了成功,但是最近的研究表明,神经网络很容易受到对输入进行微小扰动的对抗性攻击,导致模型预测出不正确的结果。以图片为例,一个难以察觉到的微小扰动就足以欺骗深度学习模型,对抗性攻击给深度学习成功投入到实际应用带来了一系列的威胁。近来,这一事实也使得这一方向取得了大量的发展。本文首先对机器视觉邻域的深度学习对抗性攻击展开课整合性的调查。我们回顾设计对抗性攻击的工作,分析此类攻击的存在性并提出针对它们的防御措施。为了强调对抗性攻击可能出现在实际生活条件中,我们分别审查评估真实场景中对抗性攻击的功效。最后,借鉴已审阅的论文,我们为这个方向上的研究提供了一个更加广阔的视野。

索引条目:深度学习,对抗性扰动,黑盒攻击,白盒攻击,对抗性学习,扰动检测。

1 简介

深度学习技术为机器学习以及人工智能社区的那些经历了许多尝试的难题带来了突破性的进展。因此,它正在以前所未有的规模被用来解决艰难的科学问题,例如,大脑回路的重构;分析DNA的突变;研究潜在的药物分子的构效以及分析粒子加速器的数据。深度学习已经变成了语音识别以及自然语言理解领域解决许多挑战性任务的最佳选择。

在计算机视觉领域,在Krizhevsky 等人于2012年公布卷积神经网络(CNN)在一个大规模的富有挑战性的数据集上表现出了极佳的性能之后,深度学习成为了关注的焦点。目前深度学习普及的一个重要功劳也可以归功于这项开创性的工作。只从2012年以来计算机视觉社区已经为深度学习的做出了大量有价值的贡献。这也使得了它为医药科学以及移动应用等领域遇到的问题提供了解决的 方案。最近人工智能领域汇总基于零样本学习的AlphaGo Zero取得了突破性的发展,这也要归功于深度残差网络(ResNet),其一开始是为图片识别任务而提出的。

随着深度神经网络模型的持续改善,高效的深度学习软件库的开发以及在硬件上训练神经网络模型变得更加的容易,深度学习已经快速地投入到安防领域的应用当中。例如:自动驾驶、安防监控、恶意软件检测、无人机以及机器人,以及声控识别技术。随着真实世界中深度学习的发展,例如面部识别的ATM机,已经安全脸部识别的移动手机,都预示着深度学习所取得的革命性成果,特别是这些源自于机器视觉的问题在我们的日常生活中扮演了一个重要的角色。

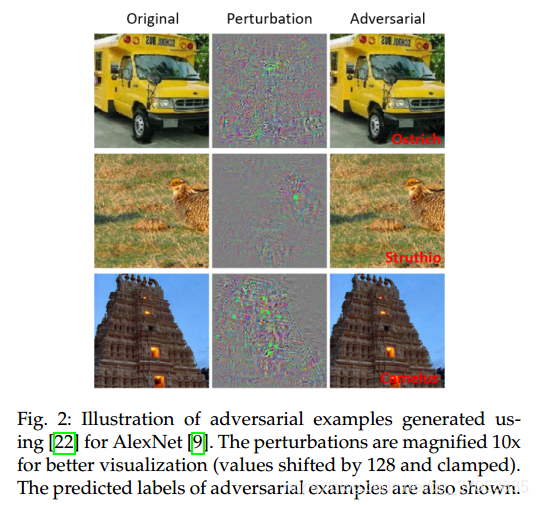

Szegedy等人认为,深度学习能够以惊人的精度执行各种计算机视觉任务。他们在图像分类上发现了一个神经网络的有趣的弱点。他们表示尽管神经网络取得了很高的分类准确率,但他们很容易受到图像上微小的扰动(人类视觉系统很难察觉到)所带来的对抗性攻击。这样的攻击可以完全改变神经网络分类器在该图片上的预测结果。更加糟糕的是,攻击模型可以使得神经网络在错误的预测上报告出更高的置信度,而且相同的图片扰动可以欺骗多网络分类器。这些研究发现的成果使得研究人员更加地关注深度学习的对抗性攻击以及一般的深度学习防御机制。

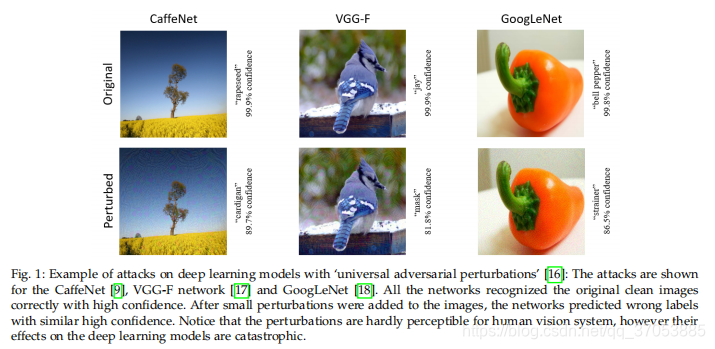

由于Szegedy等人的发现,关于计算机视觉中深度学习的对抗性攻击的研究,已经得出了几个有趣的结果。例如,除了图片的对抗性扰动之外,Moosavi-Dezfooli等人表明,在任意一张图片上都存在着广泛的可以欺骗神经网络分类器的扰动。(如图1所示).与此类似地, Athalye 等人表明3D打印出来的物体可以欺骗深度神经网络分类器(见图4.3.)本文结合计算机视觉中深度学习研究的意义及其在现实生活中的潜在应用,与此同时,提出了第一个关于计算机视觉中深度学习的对抗性攻击的综合性调查。本文旨在为除了计算机视觉社区之外提供更广泛的读者群,因此它只涉及到深度学习和图像处理的基本知识。 但它也为感兴趣的读者提供了重要贡献的技术细节的相关讨论。

在第二部分中我们主要描述了机器视觉的中涉及到的对抗性攻击的相关术语。在第三部分中,我们回顾了图像分类任务中的对抗性攻击以及除此之外的一些内容。然后用一个单独的部分专门介绍处理现实世界中对抗性攻击的方法,这些方法将会在第四部分中重点介绍。在第五部分中我们也会重点分析现实中存在的对抗性攻击。而在第六部分中我们将会介绍针对对抗性攻击所采取的防御措施。在第7部分中,我们基于所评论的文献提供了更广泛的研究方向。 最后在第八部分中我们将得出结论。

2.定义相关术语

·在这一部分中,我们将会阐述一些在机器视觉学术界常用的一些术语。以下的文章中也有对于相关术语的相同定义。

·对抗性示例/图像是有意扰乱的干净图像的修改版本,它通过向图片中加入噪声来欺骗深度学习技术,尤其是深度神经网络。

·对抗性扰动指的是将噪声添加到清晰的图片当中以生成对抗性样例

· 对抗性学习指的是利用对抗性图片包括清晰的原图来训练机器学习模型

· 对手更常见的是指创建对抗性示例的人。 但是,在某些情况下,示例本身也称为对手

·黑盒攻击指的是在测试期间向目标模型喂入不利用任何模型的先验知识所生成的对抗性示例。在一些例子中,人们也假定对手具有有限的模型相关知识(比如模型的训练过程以及结构)。但需要明确的是,模型中的参数是未知的。在另外的一些实例中,使用目标模型的相关先验信息则被称为半黑盒攻击。在本文中我们使用前一种约定方式。

·检测器是一种用于检测图像是否是一个对抗性的机制。

·欺骗率指的是图片扰动对模型正确预测的结果所带来的改变的比率。

· one-shot/one-step的方法指的是通过一步的计算来生成对抗性的扰动。例如与只计算模型损失梯度一次相反的是利用迭代的方法多次执行相同的计算以获得单个扰动。但最后的计算开销通常比较大。

·对于人类感知,准不可察觉的扰动会非常轻微地损害图像,这对于人眼很难辨别出来

· 整流器用于修改对抗性示例以将目标模型的预测结果恢复为对原先的未经扰动的示例的预测。

·目标攻击用于欺骗一个模型,使其错误地预测攻击性图片的标签,与非目标性攻击不同的是,非目标性攻击不考虑图片与预测标签之间的相关性,其目的只是能使模型错误地预测图片的标签即可。

威胁模型指的是通过一种方法考虑潜在攻击的类型,例如 黑箱袭击。

迁移性指的是攻击性样例对于除了被用来生成样例的模型之外的其他模型仍然起作用。

普遍性的扰动指定的是可以以很高的概率通过任何的图片欺骗所给的模型。值得注意的是,普遍性是指扰动的特性是“图像不可知”而不是指具有良好的可迁移性。

白盒攻击指的假设目标模型的某些特性是已知的,包括模型的参数值,结构,训练方法及其训练数据。

3.对抗性攻击

在该部分中我们回顾了计算机视觉的相关文献,介绍了深度学习中的对抗性攻击方法。回顾的文献中主要解决在实验室配置的条件下来欺骗神经网络模型的问题,其主要利用了典型的计算机视觉任务开发的方法,例如识别。以及相关的高效的基准数据库,如MNIST数据集。这些技术集中在研究研究攻击神经网络,而实际条件中的攻击研究我们将会在第四部分中展开研究,。然而,值得注意的是,该部分的阐述将是现实情况下攻击的基础,其中的很多方法对实际应用中的深度学习技术都会产生重大的影响。我们对不同部分内容的分解是根据原始贡献中的攻击评估条件来进行划分的。

该部分的回顾主要按照逻辑的顺序进行展开,在讨论的流程中几乎不存在任何不赞成的观点。为了向读者提供核心概念的技术性理解,我们也讨论了许多流行方法以及新兴方向的技术细节。其他的方法我们将做简短的讨论。我们参考了原论文中这些技术的相关细节。该部分被分为两个部分,在3.1中我们回顾了在最为寻常的机器视觉任务中进行对抗性攻击的方法。例如分类/识别问题,除了这些任务之外的一些攻击方法我们将会在3.2中进行讨论。

3.1分类的对抗性攻击

3.1.1 盒受限 L-BFGS

Szegady等人首次证明了图片的微小扰动的存在,例如扰动的图片可以使深度学习的模型错误的分类。

表示原图片的一个向量,下标c指的是图片是clean的,为了计算附加的通过轻微的扭曲来欺骗神经网络的扰动

Szegedy等人提议解决以下问题:

其中l指的是图片的标签C(.)指的是深度神经网络分类器。作者提出了非平凡的解决(1)的方案使得l与原始的标签Ic不一致。在该例子中,(1)是一个困难的问题,因此采用了盒受限 L-BFGS的方法来寻找近似解。这个方法是通过寻找最小化大于0的c,使得ρ在下面的问题中满足条件