作者:jliang

1.重点归纳

1)线性回归

(1)是确定两种或以上变量间相互依赖的定量关系的一种统计分析方法。

(2)模型:y=wx+b

(3)误差函数:![]()

(4)常见求解方法

- 最小二乘法

- 梯度下降法

- 其它算法:牛顿法或拟牛顿法

(5)最小二乘与梯度下降法关系

- 最小二乘法看作优化方法的话,那么梯度下降法是求解方法的一种。

- 梯度下降法是一种解决问题的数据方法,最小二乘法则是一个最优化问题。

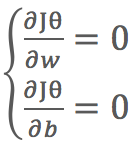

- 最小二乘法求解

通过求偏导 ,求得w和b的解。

,求得w和b的解。

2)逻辑斯蒂回归能够用于分类,不过本质上还是线性回归。它仅在线性回归的基础上,在特征到结果的映射中加入一层sigmoid函数(非线性)映射,即先把特征线性求和,然后再使用sigmoid函数来预测类别。

3)逻辑斯蒂回归本身只能求解线性可分的数据,但是通过特征变换的方式把低维空间转换到高维空间,而低维空间不可分的数据到高维空间中线性可分的几率会高一些。

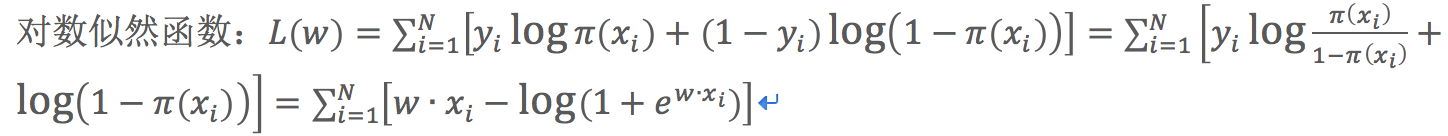

4)逻辑斯蒂回归的损失函数时log损失,目标函数:对数似然函数![]() 的最大值。

的最大值。

损失函数的另一种表达形式:

5)最大熵原理:在满足约束条件的模型集合中选取熵最大的模型。

2.逻辑斯蒂回归模型

1)逻辑斯蒂回归分布

(1)分布函数:![]()

- μ:位置参数

- γ:形状参数

- Sigmoid曲线以点(μ,12)为中心对称

(2)密度函数:![]()

2)二项逻辑斯蒂回归模型(二分类)

(1)模型

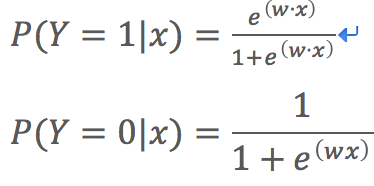

其中![]()

(2)一件事发生的对数几率:![]()

对于逻辑斯蒂回归而言![]()

逻辑斯蒂回归模型:输出Y=1的对数几率是输入x的线性函数表示的模型。

(3)决策函数![]()

实际应用时,特定的情况选择不同阈值

- 如果对正例的判别准确性要求高,则可以选择阈值大一些

- 如果对正例的召回要求高,则可以选择阈值小一些

3)参数估计

(1)可以应用极大似然估计法估计模型参数

似然函数:![]()

求Lw的极大值,得到w的估计值。

(2)对数似然函数为目标函数的最优化问题

(3)通常使用梯度下降法及拟牛顿法进行学习

4)多项逻辑斯蒂回归(多分类)

(1)k个类别不是互斥时,对每个类标训练一个二元分类器

(2)k个类别是互斥时,使用softmax替换sigmoid函数。它能使一个含任意k维向量Z压缩到另一个k维向量中,使每个元素都在[0,1]之间,并且它们之和为1。

3. 最大熵模型

1)最大熵原理:在满足约束条件的模型集合中选取熵最大的模型。

2)当X服从均匀分布时,熵最大。

3)最大熵模型与逻辑斯蒂回归模型有类型的形式,它们又称为对数线性模型。模型学习就是在给定的训练数据条件下对模型进行极大似然估计或正则化的极大似然估计。

4.模型学习的最优化算法

1)逻辑斯蒂回归模型和最大熵模型是以似然函数为目标函数的最优化问题,可以形式化为无约束最优化问题。求解该最优化问题的算法有改进的迭代尺度法、梯度下降法、牛顿法或拟牛顿法,牛顿法或拟牛顿法一般收敛速度更快。