Brain-Computer Interfaces and Augmented Reality: A State of the Art

脑机接口和增强现实:最先进的技术

文章目录

摘要

本文回顾了最新技术 结合使用脑机接口(BCI) 增强现实(AR)。 首先介绍一下 AR领域及其主要概念。 其次,它描述 到目前为止设计的各种系统结合AR和 BCI按其应用领域分类:医药, 机器人,家庭自动化和大脑活动 可视化。 最后,它总结并讨论了 调查结果显示,此前大部分都是如此 工程使用P300或SSVEP范例与脑电图 在视频透视系统中,机器人是一个 最主要的应用领域 现有系统。

介绍

BCI领域的研究越来越多 过去几十年的人气。 BCI已经 用于各种各样的应用,康复[3], 机器人技术[7],娱乐[24]或与之相关联 不同的输入形式:凝视跟踪器或 肌电图系统。 他们也有广泛的 已被用于虚拟现实环境[27]等 最近有增强现实[22,30],这本身就是 现在获得更多的兴趣。

脑 - 计算机接口和增强现实是 可以组合用于交互和/或的两个字段可视化目的。 一方面,基于AR 系统通常依赖于头戴式显示器(HMD) 配备摄像头,可用于场景需要免提互动[9]。 BCI范例可以 提供这样的输入方式,要么与之互动 虚[16]或真实物体[36]。 另一方面,BCIs 可以利用AR来与真实互动 世界。 AR还可以提供有趣的方式 通过将其集成到现实世界中来显示反馈 环境。 这种反馈对于基于BCI的重要性很重要 系统使用户能够访问和调整他们的脑活动[26,32]。

尽管如此,将BCI和AR结合起来并不是一件容易的事。 必须考虑许多限制因素。 首先,在硬件层面,这两种技术都需要 头戴式设备,不能轻易穿在同一时间,如果磨损,有必要确保 他们不会干涉。 BCI使用非常低的幅度信号,因此对噪声非常敏感。 然后,软件 还必须考虑到制约因素。那是为了 拥有中间件或中间件所必需的实例 中介代理,以便在它们之间进行同步 并结合输入。 最后,记录大脑活动 在用户通常可以自由使用的AR环境中 由于肌肉活动引起的,移动也可能很困难 BCI录音中的人工制品[17]。 本文旨在概述现有技术 结合BCI和AR的系统。 第 2 节介绍 增强现实领域,突出其中的一些 最重要的概念。 第 3 节评论现有的 BCI-AR应用程序,根据它们进行分类 他们的应用领域。 第 4 节总结和 讨论了我们的调查结果。 最后,第 5 节是结论。

增强现实介绍

增强现实的定义

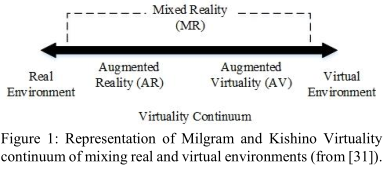

增强现实与虚拟的整合有关 实时的现实世界中的对象和信息 [40]。 根据Azuma [5]的三个特征定义 AR系统:(1)真实与虚拟的结合 内容,(2)实时交互,(3)3D 在真实环境中注册虚拟内容。 与用户沉浸其中的虚拟现实相反 在完全虚拟的世界中,AR混合虚拟和真实 内容,理想情况下,使它们看起来共存于 相同的空间[5]。 米尔格兰姆和基希诺[31]建立了一个连续统一体 从完全虚拟到完整的现实。 在它们之间,存在着真实和不同的组合 虚拟环境,取决于每个级别 在场景中(见图1)。 在本文的范围内,只有视觉AR应用程序 被考虑。

增强现实的类型

增强现实通常分为:(1) 视频透视(VST)AR:真实图像用相机拍摄的设备(平板电脑,手机等) 通过屏幕可视化,增加了虚拟信息; (2)光学透视(OST)AR: 其中虚拟内容直接显示在前面将用户的眼睛放在半透明屏幕上(例如, 微软Hololens); (3)投射AR(又名空间增强现实):虚拟内容投射到真实的环境对象[4]。

跟踪和注册

任何AR系统的一个重要部分是能力融合虚拟和真实对象,这被称为注册。 之后,跟踪允许正确 根据要求渲染虚拟对象的变化 相机的位置,从而确保他们的可靠性融入现实世界[40]。 注册虚拟元素可以使用基准标记完成放置在真实环境中,通过模式识别真实物体的识别技术有源传感器[5]。 实现这一目标的一种流行方式 跟踪,包括使用同步本地化与映射(SLAM)算法[8]相关的解决启用机器人的问题 同时发现它的周围环境并推断出它立场[37]。 最初设计用于机器人的导航 [14],它已经适用于AR [13],因为它允许 跟踪未知环境中的物体[8]。

交互

由于必要,交互是AR的主要挑战为用户提供对虚拟动作的手段 元素[40]并操纵它们。 但是,存在 在可穿戴计算机的背景下,新的方式互动,不同于鼠标和键盘,必须受雇。 到目前为止,这主要是通过完成的 语音命令和手势识别[21](如 与微软的Hololens),凝视跟踪[20]或与物理按钮[34](与谷歌眼镜一样)。 景气指数可能特别有助于基于AR的系统交互方式,特别是在视觉选择任务上这可以通过SSVEP或P300来完成[19, 25]。

结合AR和BCI的应用程序

理论上,结合AR和BCI可能是适用于BCI可以提供的大多数主题,例如协助残疾人士,娱乐,体育。 有 结合AR和BCI的不同原因。 第一,从BCI的角度来看,AR提供了新的方法在现实世界环境中整合反馈,因此,带来新的互动可能性并增强用户体验。 其次,从AR的角度来看,BCIs 提供新的“意念控制”,以便与之互动,真实和虚拟对象以及新的生理特征 关于用户心理状态的信息,允许创造更多适应性场景。 本节介绍了BCI组合的最新技术 和AR系统,根据他们的分类 应用领域是:(1)医疗; (2)机器人; (3)家庭自动化; (4)大脑活动可视化。

医疗

结合AR和AR的三种主要应用类型 可以确定药物的BCI:(1)外科医生援助或 培训,(2)心理治疗和(3)残疾人 人们的帮助。

在手术期间帮助外科医生的尝试就是工作 Blum等人。 [9]谁开发了视频透视 头戴式显示器(VST HMD)AR系统授权 “X射线超人般的视觉”让外科医生为了让 他们对患者有更深入的视力 手术。 这个应用程序的目标是结合一个 BCI有凝视跟踪器,后者选择区域 放大的位置和用于控制的前者 缩放级别。 在此使用BCI的主要用途 背景是,外科医生是完全免提的 背景,因为他们的手被消毒,因此,不可能 曾经与AR-System互动[9]。 但是,他们的 最终设置依赖于EMG而不是EEG。

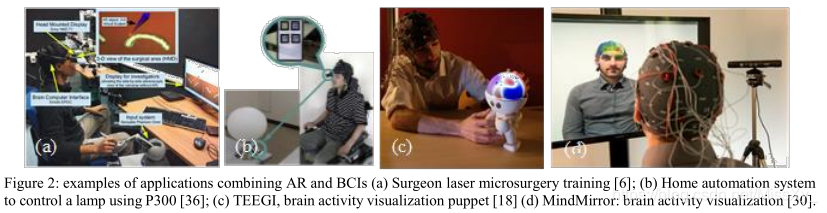

在帮助外科医生方面,这可以做到 通过为他们提供在操作期间使用的工具[9], 或提供方法让他们在操作前进行训练。这已经由Barresi等人完成。 谁开发了一个 原型称为BcAR [6]。 他们结合了BCI和AR 反馈,以培训人体机器人的外科医生 - 基于互动的手术。 在BcAR,外科医生训练 机器人辅助激光显微外科手术。 他们必须 操纵由触觉代表的“可伸缩”手术刀 臂。 AR反馈,通过视频显示 - 通过头戴式显示器(VST HMD),习惯了 向他们展示他们的注意力水平 - 通过测量 BCI - 用手术刀的长度表示,这样 他们可以适应它(见图2(a))。 该系统的目标 是教外科医生保持他们的注意力 整个操作时间。 有另一种治疗方法 通过结合AR和BCI得到增强 “暴露疗法”。 从恐惧症和恐惧症中治愈病人 焦虑,Acar等。 开发了基于EEG的系统 帮助患者克服恐惧[1]。 AR系统 由智能手机组成,显示摄像头视图 增加了用户担心的实体(例如 昆虫),帮助他们对抗它。 脑电图测量了 为了确定这种增强AR的效率 暴露疗法。 如前所述,BCI和AR可以 也要结合起来,以增强心理 疗法。 Correa-Agudelo等。 [12]发达 ViLimbs,一个基于计算机屏幕的AR-BCI用于幻像 四肢疼痛治疗。 在该系统中,患者被放入 显示面对相机流的宽屏幕前面。 感谢基准标记放置在开头 缺失的肢体,患者有自己的形象 双臂,允许他移动失踪者 痛苦的立场。 因此,它的增强版本 镜子治疗。 大脑和肌肉活动习惯 确定用户的动作意图,允许他移动他的动作 虚拟肢体。 尽管使用了脑电图,作者的原型 依赖80%的肌电信号,而电机信号则更少 意象[12]。 最后一种医疗应用 结合BCI和AR是关于辅助技术, 特别是电动轮椅控制。 这一直是 由Borges等人研究。 [10]文中正在设计一个环境允许残疾人安全地学习如何 开车轮椅。 在不同的形式中 驾驶轮椅,他们设计了一个SSVEP为基础 控制方向的解决方案。 AR的目标就在于此 系统是能够提供不同的驾驶 将虚拟障碍与真实障碍相结合的场景 世界舞台,同时仍然确保用户的安全。

机器人

BCI和AR特别用于该领域 机器人:(1)明确地操纵或控制机器人代理 或(2)操纵机器人手臂。 有可能通过 AR,提供现实世界的第一人称视角, 使用上下文可视命令进行扩充。 这有 Escolano等人的作品已经证明了这一点。 谁 开发了基于P300的AR系统来控制移动设备 机器人[15]。 机器人在一个不同的房间,配备 用相机显示第一人称视角 电脑屏幕,增加了P300菜单来控制 它。 Gergondet等人也做了类似的工作。 [19]谁提出了一个使用机器人来引导机器人 SSVEP。 他们的系统允许用户控制机器人 配备了显示增强的相机 机器人在电脑屏幕上的视图。 但在这种情况下, 菜单包含四个闪烁的命令。 此外 仅仅操纵机器人,就可以选择 不同的速度。 Petit等。 开发了机器人导航 系统允许用户与机器人进行交互[33]。 感谢用户的VST上放置了一个基准标记 HMD,用户可以让机器人走向他。 然后,用基准点进行身体部位选择 标记放置在用户身体的不同部位 开始闪烁,以便他们可以通过选择 SSVEP让机器人与之互动。

BCI和AR也被用于控制机器人手臂 通过目标选择(共享控制)而不是步骤 - 逐步控制。 Lenhardt特别做到了这一点 和Ritter [25]使用了P300奇怪的范例 为了使机器人手臂移动真实物体 表。 对象是5个用AR标记标记的立方体 那个3D虚拟数字出现在它们之上 当通过VST HMD看到。 数字是 以随机顺序突出显示以引发P300响应 当用户想要选择其中一个时。 当一个 选择了对象,表格上出现了一个网格。 每 表示可能的目标目的地的案例 也通过P300范例选择。 之后 选择目标对象和目的地,机器人 手臂进行了动作。 另一个机器人手臂控制 项目已由Martens等人完成。

他们 为两项任务设计了机械臂[29]。 首先 包括通过P300选择和移动物体 范例。 移动的“石头”在增加时增加 通过VST HMD看到,以便用户可以专注 刺激。 第二项任务是控制机器人 手臂将钥匙插入钥匙孔,并通过 用四个SSVEP增强HMD视图 命令。 兰佩等人 使用了Motor Imagery(MI) 用于控制存在于其中的机器人设备 与用户不同的位置[23]。 机器人是 配备两个摄像头,一个用于手持视图和 其他用于场景视图,并且都显示在一个 显示屏。 每当输入可选对象时 在视野方面,它得到了增强,以便用户可以 选择要通过MI和机器人手臂抓住的物体 自主抓住它。 在这种情况下,三个命令 通过Motor Imagery发送: 左,右,选择 哪个对象要掌握,并 确认 。 这些 分别对应于左或右的命令 手指敲打和脚趾紧握。

家庭自动化

另一个应用是控制智能的能力 环境,无论是提供舒适自动化 操纵家庭的机制或辅助控制 家电。 在这种情况下,组合BCI和AR是 通过两种不同的策略实现:(1) 直接互动[36],(2)通过间接互动 机器人代理[22]。 Takano等人使用了第一种策略。 在一个 基于P300的AR-BCI系统可控制多个设备 在家里[36]。 他们用AR标记家用电器 通过光学看到的标记 - 通过(OST HMD),使控制面板显示出来 他们。 然后使用P300范例来选择 命令执行(见图2(b))。 Kansaku等人提出了间接相互作用。 [22],用一个允许用户控制远程的系统 通过大脑活动在房屋环境中的机器人。 该 机器人配备了显示视频的摄像头 设备标记的环境流 用基准标记。 当其中一人进入时 机器人的视野,显示一个控制面板, 允许用户控制它。

大脑活动可视化

BCI也可用于大脑活动可视化目的。 无论是(1)神经反馈还是(2)神经反馈 教学方面的原因,AR可以提供一种自然的展示方式 大脑如何工作并将其融入现实生活环境中。 神经反馈的概念是神经反馈的重要组成部分BCI使用培训[28]。 神经反馈已经 通过将其投影到现实生活中的物体,在AR中提供 [18],或直接在表示上显示 用户[30]。 Mercier-Ganady等。 [30]开发了一个 用于此目的的名为MindMirror的应用程序使用AR 神经反馈 该系统由智能镜子组成 - 带有摄像头的液晶显示屏 - 显示用户 以某种方式X射线视觉方式(见图2(d)) 向他/她展示他/她大脑的激活区域 通过脑电图测量。 更准确地说,系统 显示了电位的分布 虚拟大脑的表面。 弗雷等人。 开发了一个 预计的AR系统称为Teegi [18]。 它包括一个 头部有形小雕像,记录的脑电图 显示用户(见图2(c))。 的目标 Teegi因其专为人们设计而具有教育意义 了解EEG的工作原理。

研究性学习

有些作品并不完全属于这些类别之一。 它们是概念和可行性/研究的证明 学习。 Faller等人的系统就属于这种情况。 谁 开发了基于SSVEP的BCI概念证明 控制在真实表格上增强的虚拟角色[16]。 他们的系统包括一个VST HMD设备和用户’ 目标是让角色通过一系列的移动 由闪烁的棋盘代表的点。 另一个 可行性研究由Uno等人完成。 谁想要 确定不受控制的真实空间的影响 关于基于P300的BCI性能的背景知识 [39]。 他们的初步结果显示没有真实效果 因此,空间背景对选择的准确性 鼓励使用组合的AR-BCI应用程序。Chin等人。 开发了一个用户可以使用的原型 到达并掌握在真实桌面上增强的虚拟对象 [11]。 用户的手增加了虚拟的手 他可以通过Motor Imagery来控制。 整体 场景显示在电脑屏幕上,没有任何影响 在MI表现中发现了AR。 另一种类型 应用程序在上下文中使用了fNIRS 可穿戴设备。 Afergan等。 开发了一个fNIRS- 基于BCI的Phylter [2]。 与…结合使用 谷歌眼镜,他们的系统帮助防止用户 从被通知淹没。 这是被动的 分析用户的认知状态以确定是否或 不是他/她可以收到通知。 决定是 基于用户的认知工作量水平 在不同用户的训练分类器后确定 状态。 仍在使用基于fNIRS的BCI,Shibata等。 介绍了Google Glass应用程序的原型 称为零快门相机[35],它由一个 被动式照片触发器,基于用户的心理工作量。 系统将预测的用户心理状态作为输入 并在’特殊情况下自动触发相机快照 用户心理负担的估计时刻 超过通过培训确定的阈值 。

讨论

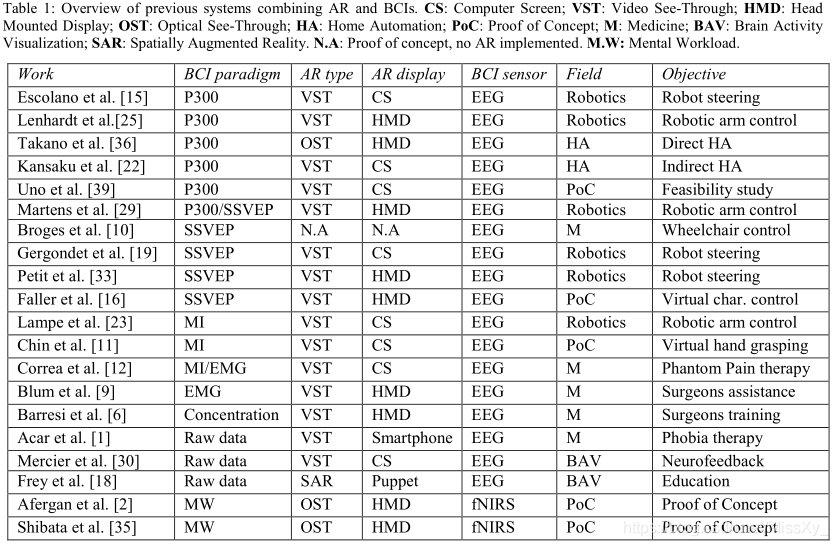

表1总结了以前结合AR的工作 和BCI根据BCI范式,即AR的类型 显示和使用的大脑传感技术。 这张桌子 首先表明大部分时间都是在进行增强 通过电脑屏幕或HMD,只有 少数使用光学透视AR。 原因对此可能是第一种解决方案很方便 原型设计和第二个非常直观,实现更多 用户的移动性。 但是,如果基于屏幕的AR清楚 防止用户移动,BCI的状态 到目前为止,发展也阻止他们移动 由于肌肉伪影的风险,与HMDs。 如 结合AR和BCI是比较新的问题 大多数人似乎都没有讨论过移动性问题 使用HMD的论文。 但是,发展和 BCI技术的改进,特别是发展 过滤方法有效去除肌肉神器 将BCI用作AR交互工具的先决条件 充满潜力。 可以做出的第二个观察 是大多数作品都使用了脑电图。 一个 原因可能是AR交互的实时性质 脑电图的时间分辨率似乎更多 比fNIRS更合适。 关于BCI 范例,虽然已经考虑了一些, SSVEP和P300范例是最常用的范例。 这个 受欢迎程度可能是由于图形方面的原因 增强,因为AR基于显示图形 因此,用户视野上的虚拟元素 基于视觉的范例非常适合选择 任务。 但是,更深入地探索是很重要的 AR对BCI表现的影响,不仅来自于 系统的观点,但也在用户的认知方面 在AR上下文中进行扩展的负载可能更多 认知要求高。 此外,大部分作品 仍然处于原型阶段。 他们利用了 中介计算机翻译大脑活动和 将其整合到交互中。 如果SSVEP似乎相当 强大的同步问题,P300可能更多 对抖动敏感。 使用中间计算机 BCI和AR设备可能会引入偏差和减少 P300表演。 对此的解决方案可能是 开发一体化可穿戴设备,功能强大 直接处理心理活动,这将免除 从使用外部中介代理和减少 失步的风险。 此外,它可能是 有趣的是探索AR中的其他BCI范例 上下文。 隐蔽注意[38]例如可能 有趣的研究AR意味着整体的元素 用户的视野,不受屏幕限制 边界。 从表1中可以看出,大多数情况都是如此 作品依赖于积极的BCI范式(包括 反应性的)。 它们主要用于操纵和 自愿控制物理或虚拟对象。 被动 BCI就其本身而言,主要用于收集 关于用户的神经生理学信息 确定他的精神状态。 这种被动范式可以 在未来的作品中进行更深入的研究。

最后,似乎有必要考虑AR-BCI系统 从人机交互的角度来看 评估和改进它们。 此外,更多和其他 应用领域可以研究和受益 将来结合AR和BCI。 例子包括: 娱乐和游戏,康复,教育或 沟通和视频会议。

结论

本文介绍了结合的最新技术 脑 - 计算机交互增强现实。 它 首先介绍了AR领域,可以分为 光学透视,视频透视和投影 AR。 然后它介绍了以前结合AR的作品 和BCIs在医学,机器人,家庭领域 - 自动化,大脑活动可视化以及证明 概念或可行性研究。 我们的调查显示 以前的大多数作品都使用了P300或SSVEP 在VST设置中的范例,EEG是最多的 采用脑感应技术,机器人技术 应用程序数量最多的字段。 结合AR和BCI似乎在场景中很有用 支持免提互动,但毫无疑问 未来的作品将在很多方面探索这种组合 更多的应用领域,以及新的互动 将设计技术以及新的反馈 将发明模式,利用两者技术。