My thoughts through a robot’s eyes: An augmented reality-brain–machine interface

机器人是我的眼:增强现实-脑机接口

文章目录

- My thoughts through a robot's eyes: An augmented reality-brain–machine interface

- 机器人是我的眼:增强现实-脑机接口

- 摘要

- 正文

-

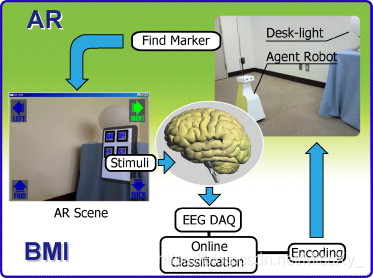

图1 增强现实 - 脑机界面。受试者被要求观看计算机监视器,该计算机监视器显示代理机器人上的USB摄像头检测到的场景。控制机器人运动(前,后,右和左)的四个图标显示在显示器的角落。当机器人的眼睛检测到AR标记时,预先指定的红外设备变得可控。显示屏上还会显示一个面板,其中包含四个用于控制灯光的图标(打开,关闭,亮起并调暗)。因此,受试者可以在代理机器人的环境中操作灯。 -

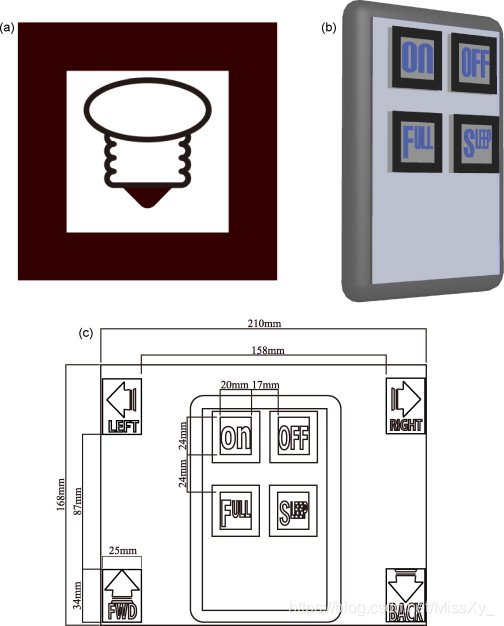

图2 用于AR-BMI的AR标记和面板。(a)桌面灯控制的AR标记。当机器人的眼睛检测到AR标记时,它变得可控制。(b)用于控制台灯的控制面板的3D模型。(c)PC监视器上显示的场景图。 -

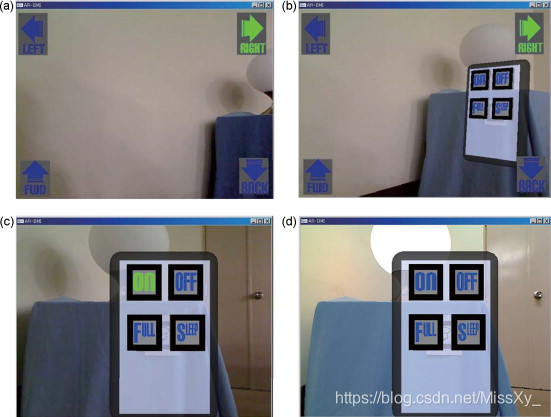

图3 实验场景。受试者在实验中看到的场景的例子。(a)机器人接近光线。(b)机器人的眼睛检测到AR标记,并显示光控制面板。(c)灯光控制面板闪烁。(d)成功发送打开灯的命令。 -

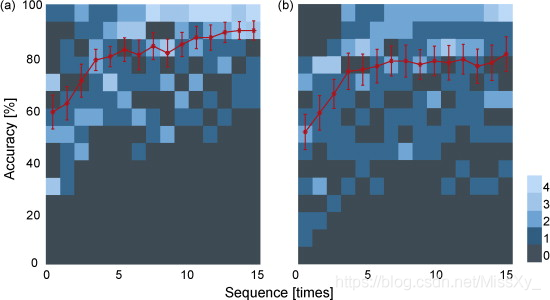

图4 受试者的控制准确性。显示控制:(a)机器人和(b)光的准确度。横轴表示序列数,纵轴表示精度。红色实线表示标准误差(SE)的平均精度。红色实线后面的蓝色方块是二维直方图,每个蓝色方块表示每个序列中受试者的频率及其准确性。

来源:https://www.sciencedirect.com/science/article/pii/S0168010209020094

摘要

脑机接口(BMI)使用来自大脑的神经生理信号来控制外部设备,例如机器人手臂或计算机光标。将增强现实与BMI相结合,我们研究表明用户的大脑信号成功地控制了环境中的机器人的行为和操作设备。通过机器人的眼睛,用户的想法变为现实,增强人体解剖结构外的真实环境。

Keywords:BMI; BCI; Augmented reality ; Human body

正文

大脑和人工设备之间的直接功能接口技术,即所谓的脑机(BMI)或脑机(BCI)接口,在过去十年中已经取得了令人印象深刻的成长(Lebedev和Nicolelis,2006,Birbaumer和Cohen,2007) 。BMI的一种研究方法利用神经生理学信号,例如单个细胞的神经元放电。使用猴子或大鼠的电生理学研究成功地对机器人手臂进行了多维控制(Chapin等,1999,Moritz等,2008)),旨在控制感觉和行为像四肢的革命假肢。另一种方法利用来自大脑的神经生理学信号,主要使用脑电图(EEG)进行非侵入性访问,脑电图是一种使用放置在头皮上的电极记录神经生理信号的技术。基于脑电图的BMI成功实现了二维光标控制(Wolpaw和McFarland,2004)。

广泛的BMI研究使用户能够在自己的环境中控制外部设备; 然而,使用大脑信号来控制用户环境之外的设备仍然是BMI的新概念。在人类获得新的视觉观点的情况下,最近的神经科学研究报告我们的身体方案可能会改变(Botvinick和Cohen,1998,Ehrsson等,2004,Lenggenhager等,2007),e。例如,视觉视角的操纵会影响我们身体内部的正常持续体验,并且可能会出现与另一个人或人造体交换身体的感知错觉(Petkova和Ehrsson,2008))。因此,开发新BMI的一个挑战是将用户的视觉直观放在另一个环境中。这也可能引起必须进一步评估的各个方面。新BMI的另一个可能方向是准备具有可视透视的可控代理机器人,然后让用户看到机器人“看到”的内容。在这里,我们描述了一种新的BMI系统,它允许控制用户自身身体环境之外的设备; 我们将增强现实(AR)与BMI技术相结合,并表明大脑信号不仅可以控制代理机器人的运动,还可以通过其眼睛在机器人的环境中操作光。通过机器人的眼睛,用户的想法变为现实,使人体解剖结构外的真实环境得以增强。

招募了10名未参加本研究的健康,未训练的幼稚受试者(年龄19-39岁; 2名女性和8名男性)作为参与者。根据爱丁堡清单,所有受试者均为神经正常且右手强烈。该研究得到了机构审查委员会的批准。所有受试者均根据机构指南提供书面知情同意书。

AR-BMI系统包括个人计算机(PC),监视器,实验室代理机器人,USB摄像头(QCAM-200V,Logicool,东京,日本),EEG放大器(gUSBamp,Guger Technologies OEG,Graz,Austria),和EEG上限(g.EEGcap,Guger Technologies OEG,格拉茨,奥地利)(图1)。当机器人的眼睛检测AR标记(图2),预先指定的红外设备变得可控。AR标记的位置和方向由相机检测到的图像计算,并且用于器具的控制面板由AR系统创建并叠加在机器人眼睛检测到的场景上。为了通过使用脑信号控制我们的系统,我们修改了Donchin P300拼写器。这使用了P300范例,它提供了一系列以矩阵排列的图标。该主题将注意力集中在矩阵中的一个图标上作为目标,并且矩阵中的每个行/列或单个图标以随机序列加强。目标刺激表现为罕见的刺激(Oddball Paradigm)。引出与目标刺激相关的P300相关响应,然后可以提取并分类该响应以确定目标(Farwell和Donchin,1988)。注意,需要引起注意的方向以引起与P300相关的反应,而不一定是引人注目的方向。最近,我们的研究小组修改了Donchin P300 speller(Takano et al。,2009),并通过环境控制系统(ECS)应用它,使C3 / C4级四肢瘫痪患者能够成功使用该系统(28个正确信号/没有经过重大培训的28项试验(Komatsu等,2008)。

图1 增强现实 - 脑机界面。受试者被要求观看计算机监视器,该计算机监视器显示代理机器人上的USB摄像头检测到的场景。控制机器人运动(前,后,右和左)的四个图标显示在显示器的角落。当机器人的眼睛检测到AR标记时,预先指定的红外设备变得可控。显示屏上还会显示一个面板,其中包含四个用于控制灯光的图标(打开,关闭,亮起并调暗)。因此,受试者可以在代理机器人的环境中操作灯。

图2 用于AR-BMI的AR标记和面板。(a)桌面灯控制的AR标记。当机器人的眼睛检测到AR标记时,它变得可控制。(b)用于控制台灯的控制面板的3D模型。(c)PC监视器上显示的场景图。

AR-BMI系统使用ARToolKit(Kato和Billinghurst,1999)和OpenGL。ARToolKit C语言库用于检测和确定AR标记的位置,OpenGL C语言库用于绘制3D控制面板。图 2b示出了用于控制台灯的控制面板的3D模型。图 2c示出了PC监视器上显示的场景的图。请注意,AR-BMI系统可以控制代理机器人和台灯。机器人控制面板有四个图标(向前,向后,向右和向左),光控制面板也是如此(打开,关闭,打亮,调暗)。我们准备了绿色/蓝色闪烁图标(Takano et al。,2009并且,闪烁的增强/静止的持续时间是100/50 ms。所有图标以随机顺序闪烁,形成一个序列(600 毫秒)。每15个序列进行一次分类。受试者被要求发送15个命令红外信号以控制机器人和光。在试验之前,我们检查了受试者将要发送的命令,然后使用该信息来评估受试者的在线表现。我们还使用记录的数据执行了离线评估。

使用以下方法记录8通道(扩展国际10-20系统的Fz,Cz,Pz,P3,P4,Oz,PO7和PO8)EEG数据(Krusienski等,2007,Lu等,2008)。脑电图上限。所有通道都参考Fpz并接地到AFz。存储的EEG数据通过0.1Hz的八阶高通滤波器 和四阶48-52Hz陷波滤波器,并以128Hz的速率放大/数字化 。一阶带通滤波器(8.0-18.0 rad / s)应用于记录的EEG数据。然后,根据强化的时间记录120个事件相关电位(ERP)数据样本。来自前20个样品(强化前)的数据用于基线校正。将最后100个样品(强化后)下采样至25.6 Hz和Fisher的线性判别分析用于分类。在Fisher的线性判别分析中,我们首先收集数据以导出后续测试会话的特征向量。分配了四个目标来制作特征向量。使用闪光定时信息对EEG数据进行分类,然后使用Fisher的线性判别分析来生成特征向量(160维,每个EEG通道20维),以区分目标和非目标。针对每种条件导出特征向量。在测试阶段,使用特征向量评估来自EEG特征的视觉诱发反应。分类的结果被解释为总和分数的最大值。

使用基于EEG的BMI系统,参与者首先需要使机器人在机器人的环境中移动到台灯(图3a和b )。为了控制机器人,每个命令是在一系列15个序列中选择的,并且参与者需要发送15个命令。评估在线性能,控制机器人的平均精度为90.0%。

图3 实验场景。受试者在实验中看到的场景的例子。(a)机器人接近光线。(b)机器人的眼睛检测到AR标记,并显示光控制面板。(c)灯光控制面板闪烁。(d)成功发送打开灯的命令。

当机器人的眼睛检测到台灯的AR标记时,在屏幕上显示用于控制器具的闪烁面板(图 3c和d)。然后,参与者必须使用他们的大脑信号通过机器人的眼睛操作机器人环境中的光。为了操作灯,每个命令在一系列15个序列中被选中,并且参与者被要求发送15个命令。评估在线性能,光控制的平均准确度为80.7%。

图4示出了在机器人控制(a)和光控制(b)条件下的参与者的性能的离线评估。控制机器人和台灯的性能差异显着,双向重复ANOVA(F (1,280) = 6.53,p < 0.05)观察到相互作用。事后测试显示机器人控制条件和光控条件之间存在显着差异(Tukey-Kramer测试,p < 0.05)。差异可能与屏幕上闪烁图标的相对位置的差异有关(Cheng et al。,2002)(另请参见图 2)。

图4 受试者的控制准确性。显示控制:(a)机器人和(b)光的准确度。横轴表示序列数,纵轴表示精度。红色实线表示标准误差(SE)的平均精度。红色实线后面的蓝色方块是二维直方图,每个蓝色方块表示每个序列中受试者的频率及其准确性。

通过将AR技术应用于BMI,我们成功地证明了大脑信号不仅可以控制代理机器人,还可以在机器人环境中操作家用电子设备。BMI研究已经开发出革命性的假肢,感觉和行为就像使用者的四肢(Chapin等,1999,Moritz等,2008)或计算机设备(Wolpaw和McFarland,2004)),但这些还没有控制用户环境之外的设备。在本研究中,我们应用AR技术并成功地增强了真实环境。我们还应用了P300拼写算法,并成功地将主体的思想转化为预先分配给每个图标的命令; 受试者的想法成功地操作了机器人和机器人环境中的台灯。

在这项研究中,人类成功地使用了一种具有人体外部另一种视角的药剂。其他可能的方法可以包括直接向用户提供新的视觉观点; 在这方面需要谨慎应用,因为这可能很容易改变使用者的身体方案(Botvinick和Cohen,1998,Ehrsson等,2004,Lenggenhager等,2007,Petkova和Ehrsson,2008)。沿着这些线路扩展人类活动的环境,使用未来的非侵入性神经生理信号或神经元射击数据,可以为身体残疾人和身体健全的人提供新的日常活动。