Python 爬虫基础学习

Requests库的安装

Win平台: “以管理员身份运行”cmd,执行 pip install requests

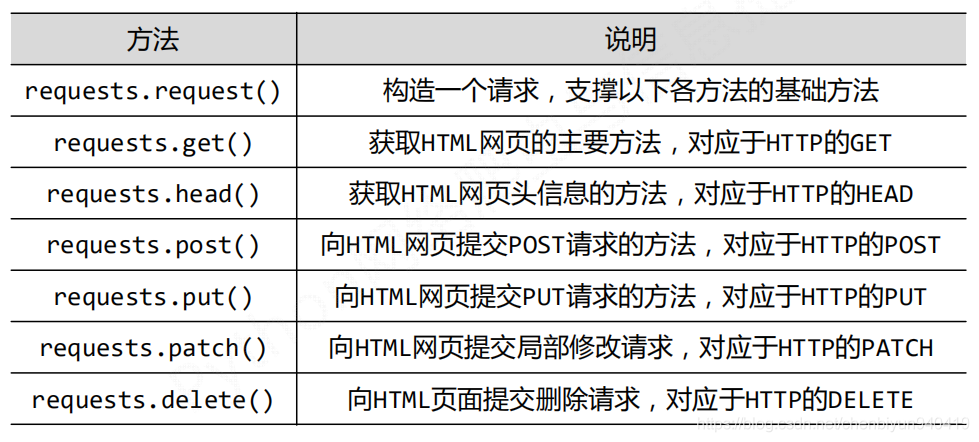

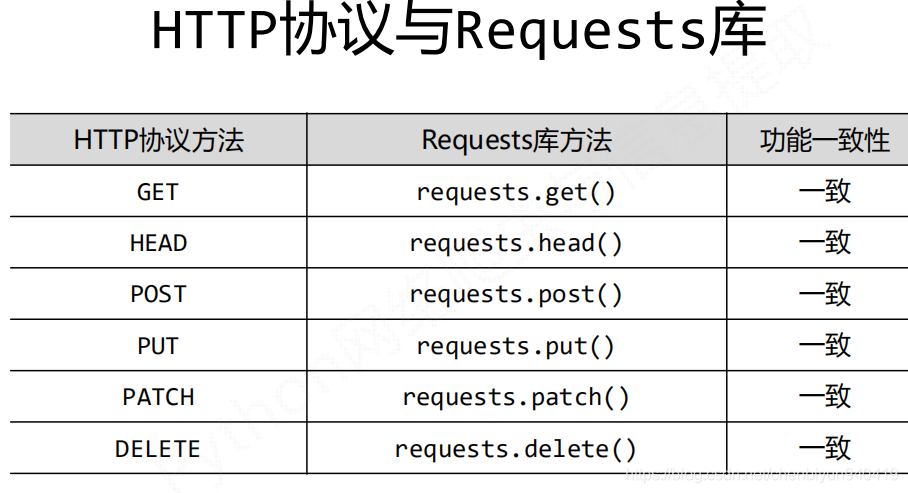

Requests库的7个主要的方法

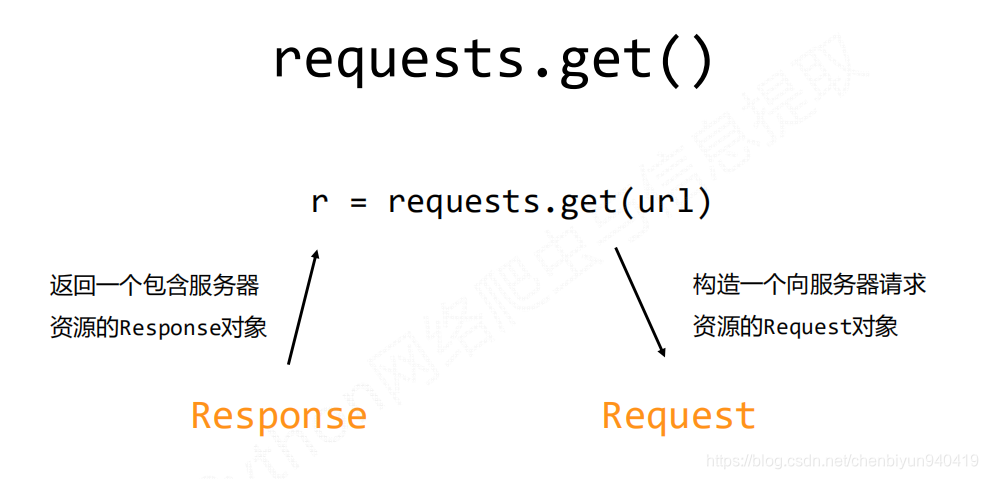

Requests库中2个重要的对象:Request和Response

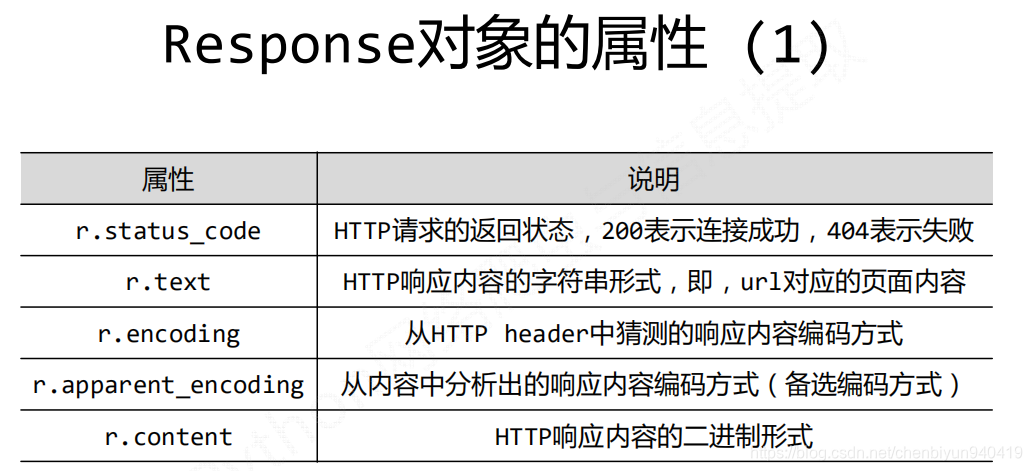

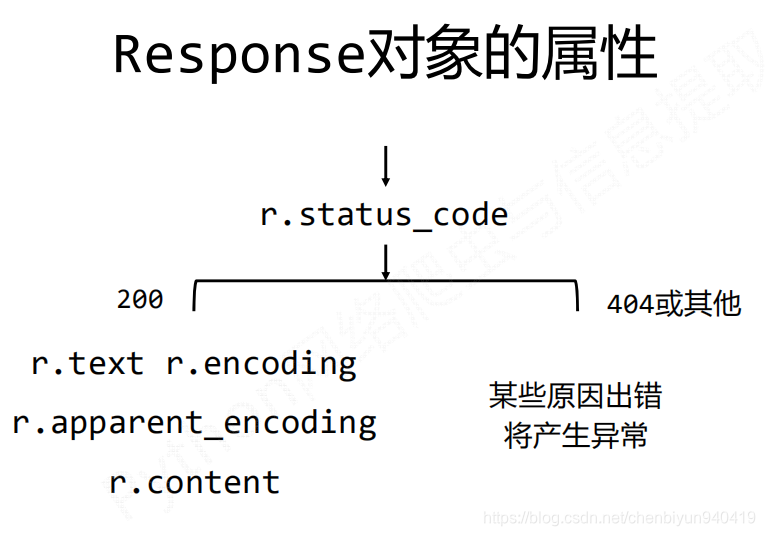

Response对象包含爬虫返回的内容,也包含请求的Request信息。

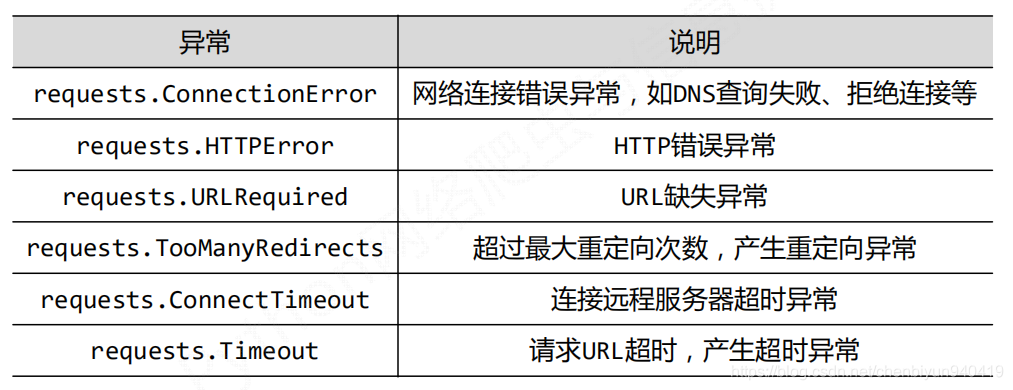

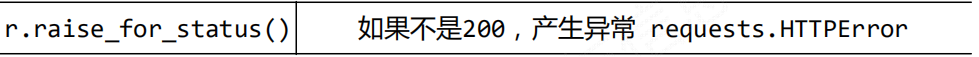

Requests库的异常

Requests对网页进行访问时时时刻刻都会出现一些问题,那么出现问题就需要相关的异常处理来解决。

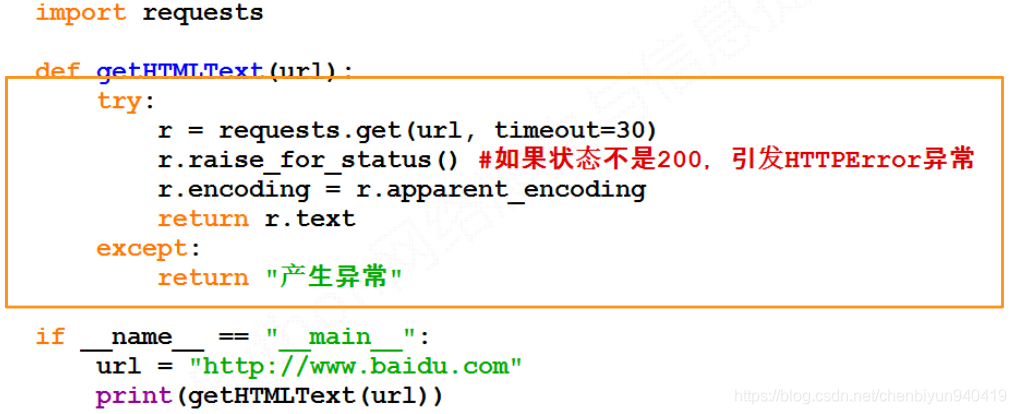

爬取网页的通用框架为:

下面介绍一下HTTP协议,以此来了解url:

HTTP协议是超文本传输协议,基于“请求与响应”模式的,无状态的应用层协议,采用URL作为定位网络资源的标识,URL的格式如下:

![**http://host[:port][path]**](https://img-blog.csdnimg.cn/20181205114603866.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L2NoZW5iaXl1bjk0MDQxOQ==,size_16,color_FFFFFF,t_70)

对于URL的理解:

URL是通过HTTP协议存取资源的Internet路径,一个URL对应一个数据资源

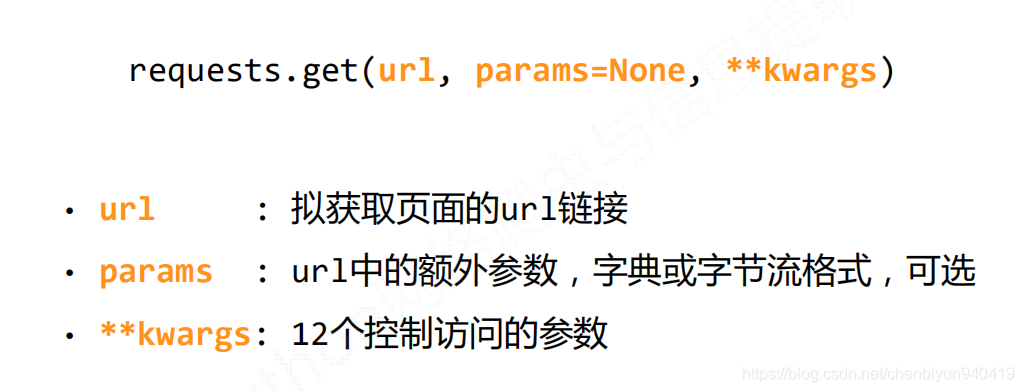

Request请求

requests.request(method, url, **kwargs)

method : 请求方式,对应get/put/post等7种

url : 拟获取页面的url链接

**kwargs: 控制访问的参数,共13个

**kwargs:控制访问的参数,均为可选项

params:字典或字节序列,作为参数增加到URL中

data:字典、字节序列或文件对象,作为Request的内容

json:JSON格式的数据,作为Requet的内容

headers:字典,HTTP定制头

cookies:字典或CookieJar,Request中的cookie

auth:元组,支持HTTP认证功能

files:字典类型,传输文件

timeout:设定超时时间,秒为单位。

proxies:字典类型,设定访问代理服务器,可以增加登录认证。

allow_redirects :True或False,默认为True,重定向开关。

stream:True或False,默认为True,认证SSL证书开关

cert:本地SSL证书路径