目录

1、Spark架构设计

2、运行模式与用户交互方式

3、java实现spark wordcount示例

4、scala实现spark wordcount示例

5、经典习题

详情

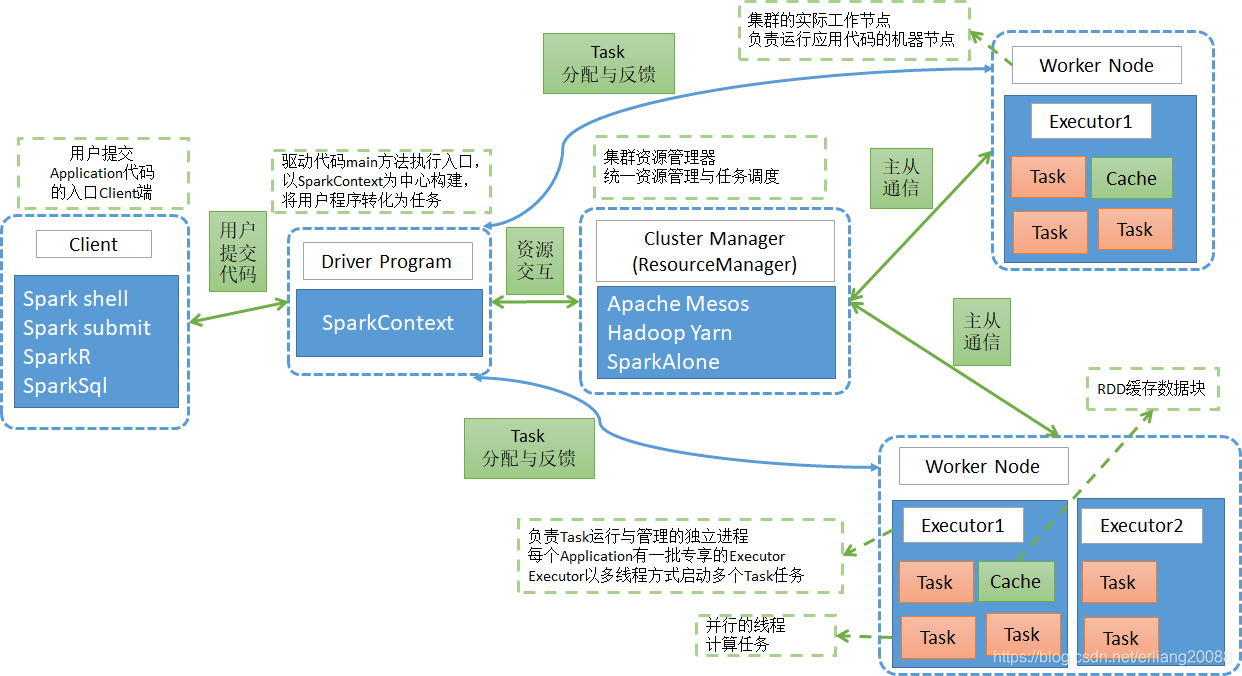

1、Spark架构设计

-

1.1 架构设计图

-

1.2 相关术语名词解释

-

RDD (Resilient Distributed DataSet)

- 弹性分布式数据集,是对数据集在spark存储和计算过程中的一种抽象。

- 是一组只读、可分区的的分布式数据集合

- 一个RDD 包含多个分区Partition(类似于MapReduce中的InputSplit),分区是依照一定的规则的,将具有相同规则的属性的数据记录放在一起 。

- 横向上可切分并行计算,以分区Partition为切分后的最小存储和计算单元。

- 纵向上可进行内外存切换使用,即当数据在内存不足时,可以用外存磁盘来补充。

-

Partition(分区)

- Partition类似hadoop的Split,计算是以partition为单位进行的,提供了一种划分数据的方式。

- partition的划分依据有很多,可以自己定义的,像HDFS文件,划分的方式就和MapReduce一样,以文件的block来划分不同的partition。

- 一个Partition交给一个Task去计算处理

-

算子

- 英文简称:Operator

- 广义上讲,对任何函数进行某一项操作都可以认为是一个算子

- 通俗上讲,算子即为映射、关系、变换。

- MapReduce算子,主要分为两个,即为Map和Reduce两个主要操作的算子,导致灵活可用性比较差。

- Spark算子,分为两大类,即为Transformation和Action类,合计有80多个。

-

Transformation类算子

-

操作是延迟计算的,也就是说从一个RDD 转换生成另一个 RDD 的转换操作不是马上执行,需要等到有 Action 操作的时候才会真正触发运算。

-

细分类

- Value数据类型的Transformation算子

- Key-Value数据类型的Transfromation算子

-

-

Action类算子

- 会触发 Spark 提交作业(Job),并将数据输出 Spark系统。

-

窄依赖

- 如果一个父RDD的每个分区只被子RDD的一个分区使用 ----> 一对一关系

-

宽依赖

- 如果一个父RDD的每个分区要被子RDD 的多个分区使用 ----> 一对多关系

-

Application

- Spark Application的概念和MapReduce中的job或者yarn中的application类似,指的是用户编写的Spark应用程序,包含了一个Driver 功能的代码和分布在集群中多个节点上运行的Executor代码;

- 一般是指整个Spark项目从开发、测试、布署、运行的全部。

-

Driver

-

运行main函数并且创建SparkContext的程序。

称为驱动程序,Driver Program类似于hadoop的wordcount程序的main函数。

-

-

-

-

Cluster Manager

- 集群的资源管理器,在集群上获取资源的外部服务。如Yarn、Mesos、Spark Standalone等。

- 以Yarn为例,驱动程序会向Yarn申请计算我这个任务需要多少的内存,多少CPU等,后由Cluster Manager会通过调度告诉驱动程序可以使用,然后驱动程序将任务分配到既定的Worker Node上面执行。

-

WorkerNode

-

集群中任何一个可以运行spark应用代码的节点。

Worker Node就是物理机器节点,可以在上面启动Executor进程。

-

-

Executor

- Application运行在Worker节点上的一个进程,该进程负责运行Task,并且负责将数据存在内存或者磁盘上,每个Application都有各自独立专享的一批Executor。

- Executor即为spark概念的资源容器,类比于yarn的container容器,真正承载Task的运行与管理,以多线程的方式运行Task,更加高效快速。

-

Task

-

与Hadoop中的Map Task或者Reduce Task是类同的。

-

分配到executor上的基本工作单元,执行实际的计算任务。

-

Task分为两类,即为ShuffleMapTask和ResultTask。

- ShuffleMapTask:即为Map任务和发生Shuffle的任务的操作,由Transformation操作组成,其输出结果是为下个阶段任务(ResultTask)进行做准备,不是最终要输出的结果。

- ResultTask:即为Action操作触发的Job作业的最后一个阶段任务,其输出结果即为Application最终的输出或存储结果。

-

-

Job(作业)

-

Spark RDD 里的每个action的计算会生成一个job。

-

用户提交的Job会提交给DAGScheduler(Job调度器),Job会被分解成Stage去执行,

每个Stage由一组相同计算规则的Task组成,该组Task也称为TaskSet, 实际交由TaskScheduler去调度Task的机器执行节点, 最终完成作业的执行。

-

-

Stage(阶段)

-

Stage是Job的组成部分,每个Job可以包含1个或者多个Stage。

-

Job切分成Stage是以Shuffle作为分隔依据,Shuffle前是一个Stage,Shuffle后是一个Stage。

即为按RDD宽窄依赖来划分Stage。

-

-

每个Job会被拆分很多组Task,每组任务被称为Stage,也可称TaskSet,一个作业分为多个阶段;

2、spark运行模式与用户交互方式

* 运行模式

* 即作业以什么样的模式去执行,主要是单机、分布式两种方式的细节选择。

序号模式名称特点应用场景

1本地运行模式(local)单台机器多线程来模拟spark分布式计算机器资源不够测试验证程序逻辑的正确性

2伪分布式模式单台机器多进程来模拟spark分布式计算机器资源不够测试验证程序逻辑的正确性

3standalone(client)独立布署spark计算集群自带clustermanagerdriver运行在spark submit client端机器资源充分纯用spark计算框架任务提交后在spark submit client端实时查看反馈信息

4standalone(cluster)独立布署spark计算集群自带clustermanagerdriver运行在spark worknode端机器资源充分纯用spark计算框架任务提交后将退出spark submit client端

5spark on yarn(yarn-client)以yarn集群为基础只添加spark计算框架相关包driver运行在yarn client上机器资源充分多种计算框架混用数据共享性强任务提交后在yarn client端实时查看反馈信息

6spark on yarn(yarn-cluster)以yarn集群为基础只添加spark计算框架相关包driver运行在集群的am contianer中机器资源充分多种计算框架混用数据共享性强任务提交后将退出yarn client端

7spark on mesos/ec2与spark on yarn类似与spark on yarn类似在国内应用较少

-

用户交互方式

- 交互方式列表

- 1、spark-shell: spark命令行方式来操作spark作业。

-

多用于简单的学习、测试、简易作业操作。

-

2、spark-submit: 通过程序脚本,提交相关的代码、依赖等来操作spark作业。

- 最多见的提交任务的交互方式,简单易用、参数齐全。

-

3、spark-sql :通过sql的方式操作spark作业。

- sql相关的学习、测试、生产环境研发均可以使用该直接操作交互方式。

-

4、spark-class: 最低层的调用方式,其它调用方式多是最终转化到该方式中去提交。

- 直接使用较少

-

5、sparkR,sparkPython:通过其它非java、scala语言直接操作spark作业的方式。

- R、python语言使用者的交互方式。

-

-

重要交互方式使用介绍

-

重点说明spark-shell,spark-submit两大方式,spark-sql后有专门章节介绍,其它小众方式不做介绍。

-

1、spark-shell

-

交互方式定位

- 一个强大的交互式数据操作与分析的工具,提供一个简单的方式快速学习spark相关的API。

-

启动方式

- 前置环境:已将spark-shell等交互式脚本已加入系统PATH变量,可在任意位置使用。

-

-

-

- 1、spark-shell: spark命令行方式来操作spark作业。

- 交互方式列表

#以本地2个线程来模拟运行spark相关操作,该数量一般与本机的cpu核数相一致为最佳spark-shell --master local[2]

- 相关参数

-

参数列表获取方式:spark-shell --help

- 其参数非常多,但由于该方式主要是简单学习使用,故其参数使用极少,故不做详解。

-

使用示例介绍

- 交互式入口

-

构建一个scala列表,并输出

-

通过scala列表,构造一个rdd,并进行基本操作

-

通过本地文本文件构建rdd,并进行基本操作

-

通过hdfs文本文件构建rdd,并进行基本操作

-

对rdd进行字符串过滤操作

-

对rdd进行求最大值操作

-

对输入进行wodcount计算-无排序

-

对输入进行wodcount计算-按词频降序排列输出

-

2、spark-submit

-

交互方式定位

- 最常用的通过程序脚本,提交相关的代码、依赖等来操作spark作业的方式。

-

启动方式

- spark-submit提交任务的模板

spark-submit \ --class \ --master \ --jars jar_list_by_comma \ --conf = \ … # other options \ [application-arguments]

- spark-submit提交任务的模板

-

-

天亮教育是一家从事大数据云计算、人工智能、教育培训、产品开发、咨询服务、人才优选为一体的综合型互联网科技公司。

公司由一批BAT等一线互联网IT精英人士创建,

以"快乐工作,认真生活,打造高端职业技能教育的一面旗帜"为愿景,胸怀"让天下没有难找的工作"使命,

坚持"客户第一、诚信、激情、拥抱变化"的价值观,

全心全意为学员赋能提效,践行技术改变命运的初心。

更多学习讨论, 请加入

官方-天亮大数据交流-366784928

群二维码:

天亮教育公开课-从小白到大佬修成记-全系列视频地址:http://bbs.myhope365.com/forum.php?mod=viewthread&tid=1422&extra=page%3D1

欢迎关注天亮教育公众号,大数据技术资料与课程、招生就业动态、教育资讯动态、创业历程分享一站式分享,官方微信公众号二维码:

天亮教育官方群318971238,

爬虫、nlp技术qq群320349384

hadoop & spark & hive技术群297585251,

教育培训官网:http://myhope365.com

项目研发官网:http://shangyuninfo.com/

官方天亮论坛:http://bbs.myhope365.com/