4.1 基于贝叶斯决策理论的分类方法

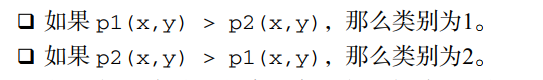

朴素贝叶斯是贝叶斯决策理论的一部分,贝叶斯决策理论的的核心思想,即选择具有最高概率的决策。若p1(x,y)和p2(x,y)分别代表数据点(x,y)属于类别1,2的概率,则判断新数据点(x,y)属于哪一类别的规则是:

4.3 使用条件概率来分类

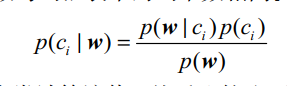

在实际问题中,我们真正需要计算和比较的是

和

。这些符号代表的意思是:数据点(x,y)来自c1和c2的概略分别是多少。其中,

4.4 使用朴素贝叶斯进行文档分类

4.5 使用python进行文本分类

文本的特征来自文本的词条(token),一个词条可以使单词,url或其他任意字符。将每一个文本片段表示为一个词条向量,其中1表示词条出现在文档中,0表示词条未出现。

以在线社区的留言板为例。为了不影响社区的发展,因此要屏蔽侮辱性言论,所以要构建一个过滤器。当留言使用了侮辱性言论,则将留言标识为内容不当。对此问题建立两个类别:侮辱类和非侮辱类,使用1和0表示。

4.5.1 准备数据:从文本中构建词向量

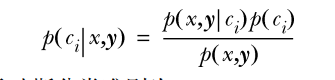

在此步,我们要将句子转化为向量。考虑文档中出现的所有单词,整合成词汇表,然后将每一篇文档转换为词汇表上的向量。首先,创建文件bayes.py,添加程序。

import numpy as np

# 4-1 词表到向量的转换函数

# 创建实验数据集

def loadDataSet():

postingList = [['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],

['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'],

['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'],

['stop', 'posting', 'stupid', 'worthless', 'garbage'],

['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],

['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]

classVec = [0,1,0,1,0,1] # 1代表侮辱性文字 0 代表正常言论 类别标签的集合

return postingList,classVec

# 根据实验数据集,生成词汇表

def createVocabList(dataSet):

vocabSet = set([]) # 创建空集

for document in dataSet:

vocabSet = vocabSet | set(document) # 集合去重,合并两个集合

return list(vocabSet) # 返回词汇表

# 输入参数:词汇表及某个文档 输出:文档向量

def setOfWord2Vec(vocabList, inputSet):

returnVec = [0]*len(vocabList) # 创建一个所含元素都为0的向量

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] = 1

else:

print("the word: %s is not in my Vocabulary!") % word

return returnVec

listOPosts, listClasses = loadDataSet()

myVocabList = createVocabList(listOPosts)

print(myVocabList)

print(setOfWord2Vec(myVocabList, listOPosts[0]))

假设文本已切分完,存放于列表中。函数loadDataSet()创建了一些实验样本,其将返回实验数据集和类别标签的集合。createVocabList()将会创建一个包含postingList出现的不重复词的列表,获得词汇表后,便可以使用函数setOfWords2Vec(),该函数的输入参数为词汇表及某个文档,输出的是文档向量,向量的每一元素为1或0,分别表示词汇表中的单词在输入文档中是否出现。

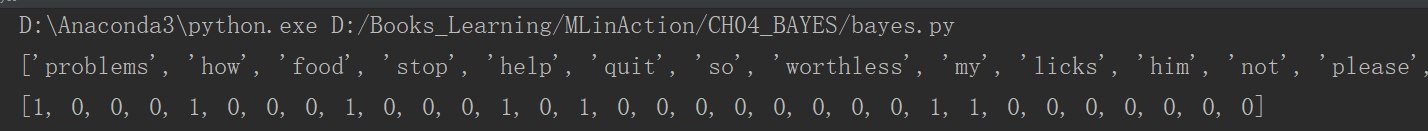

程序运行结果:

4.5.2 训练算法:从词向量计算概率

前面我们将一组单词转换为一组数字,接下来我们用这些数字计算概率。设w表示一个向量,它由多个数值组成,数值个数与词汇表中的词个数相同。

使用上述公式计算一条留言属于类别1或0的概率,然后比较两个值的大小,即可判断某条留言的类别。其中

计算

,这里假设

相互独立,则

则程序4-2代码如下:

def trainNB0(trainMatrix, trainCategory):

numTrainDocs = len(trainMatrix) # 训练文档数

numWords = len(trainMatrix[0]) # 总词数

pAbusive = sum(trainCategory)/float(numTrainDocs) # 计算文档属于侮辱性文档的概率

p0Num = np.zeros(numWords)

p1Num = np.zeros(numWords)

p0Denom = 0.0; p1Denom = 0.0

for i in range(numTrainDocs):

if trainCategory[i] == 1:

p1Num += trainMatrix[i]

p1Denom += sum(trainMatrix[i])

else:

p0Num += trainMatrix[i]

p0Denom += sum(trainMatrix[i])

p1Vect = p1Num/p1Denom # 对每个元素做除法

p0Vect = p0Num/p0Denom

return p0Vect,p1Vect,pAbusive

listOPosts, listClasses = loadDataSet()

myVocabList = createVocabList(listOPosts)

print(myVocabList)

trainMat = []

# 构建训练矩阵

for postinDoc in listOPosts:

trainMat.append(setOfWord2Vec(myVocabList, postinDoc))

p0V, p1V, pAb = trainNB0(trainMat, listClasses)

print("p0V:\n", p0V)

print("p1v:\n", p1V)

print("pAb:", pAb)

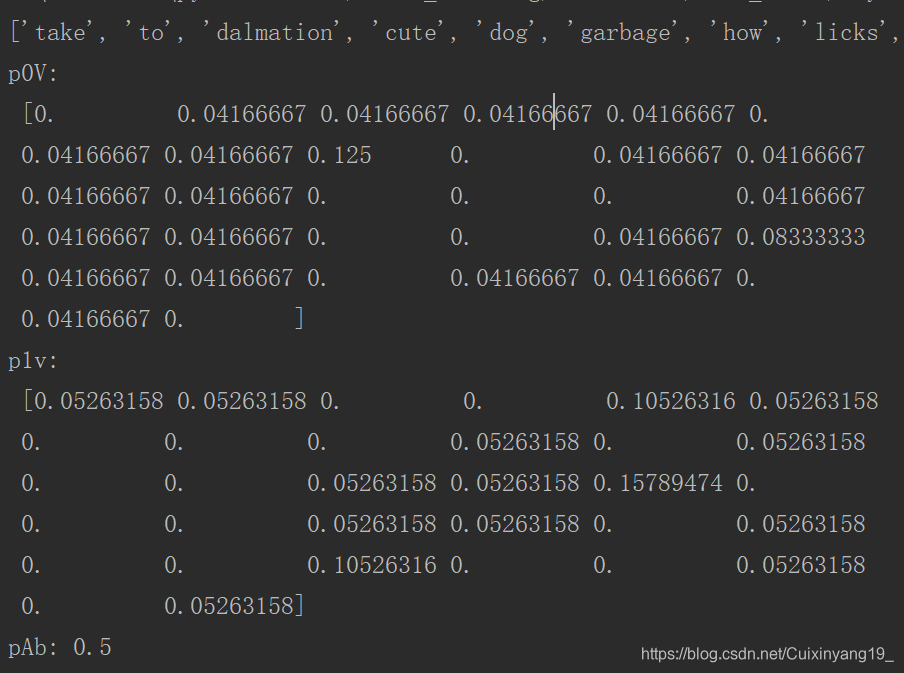

运行程序,结果如下:

其中cute在第四个位置,其只在类别0中出现一次,对应条件概率分别为0.0.4166667和0.0。

4.5.3 测试算法:修改分类器

因为

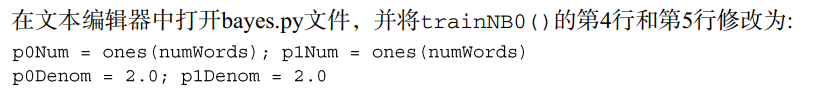

若其中一个概率值为0,最后乘积为0,所以将所有词出现次数初始化为1,并将分母初始化为2。

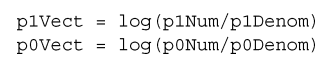

由于大部分因子都非常小,很可能经四舍五入后得到0,所以对乘积取自然对数。所以修改return前两行代码:

构建分类函数,添加到bayes.py文件中,

# 程序4-3 朴素贝叶斯分类函数

'''

输入:要分类的向量vec2Classify,使用trainNB0()计算得到的三个概率

'''

def classifyNB(vec2Classify, p0Vec, p1Vec, pClass1):

p1 = sum(vec2Classify * p1Vec) + np.log(pClass1) # 元素相乘

p0 = sum(vec2Classify * p0Vec) + np.log(1 - pClass1)

if p1 > p0:

return 1

else:

return 0

def testingNB():

listOPosts, listClasses = loadDataSet()

myVocabList = createVocabList(listOPosts)

trainMat = []

for postinDoc in listOPosts:

trainMat.append(setOfWord2Vec(myVocabList, postinDoc))

p0V,p1V,pAb = trainNB0(np.array(trainMat),np.array(listClasses))

testEntry = ['love', 'my', 'dalmation']

thisDoc = np.array(setOfWord2Vec(myVocabList, testEntry))

print(testEntry, "classified as:", classifyNB(thisDoc,p0V, p1V, pAb))

testEntry = ['stupid', 'garbage']

thisDoc = np.array(setOfWord2Vec(myVocabList, testEntry))

print(testEntry, "classified as:", classifyNB(thisDoc, p0V, p1V, pAb))

testingNB()

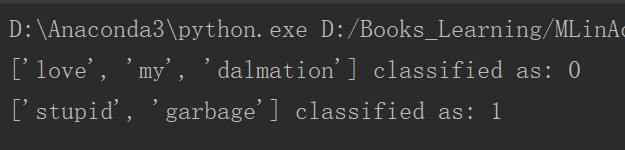

运行程序:

4.5.4 准备数据:文档词袋模型

上述程序中,我们使用了词集模型(set-of-words model),即每个词的出现与否作为一个特征。

**词袋模型(bag-of-words model)**中,每个单词可以出现多次,因此将词集模型代码修改为词袋模型的代码:

# 词袋模型

def bagOfWord2Vec(vocabList, inputSet):

returnVec = [0] * len(vocabList) # 创建一个所含元素都为0的向量

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] += 1

return returnVec

4.6 示例:使用朴素贝叶斯过滤垃圾邮件

代码实例:

#coding=utf-8

_date_ = '2018/11/20 20:01'

_author_ = 'Cxy'

# 邮件过滤实例

import numpy as np

import random

# 根据实验数据集,生成词汇表

def createVocabList(dataSet):

vocabSet = set([]) # 创建空集

for document in dataSet:

vocabSet = vocabSet | set(document) # 集合去重,合并两个集合

return list(vocabSet) # 返回词汇表

# 词集模型 输入参数:词汇表及某个文档 输出:文档向量

def setOfWord2Vec(vocabList, inputSet):

returnVec = [0]*len(vocabList) # 创建一个所含元素都为0的向量

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] = 1

else:

print("the word: %s is not in my Vocabulary!") % word

return returnVec

# 词袋模型

def bagOfWord2Vec(vocabList, inputSet):

returnVec = [0] * len(vocabList) # 创建一个所含元素都为0的向量

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] += 1

return returnVec

# 4-2 朴素贝叶斯分类器训练函数

'''

输入参数:文档矩阵trainMatrix 文档类别向量:trainCategory

输出:每个类别的条件概率向量

'''

def trainNB0(trainMatrix, trainCategory):

numTrainDocs = len(trainMatrix) # 训练文档数

numWords = len(trainMatrix[0]) # 总词数

pAbusive = sum(trainCategory)/float(numTrainDocs) # 计算文档属于侮辱性文档的概率

p0Num = np.zeros(numWords)

p1Num = np.zeros(numWords)

p0Num = np.ones(numWords)

p1Num = np.ones(numWords)

p0Denom = 2.0; p1Denom = 2.0

for i in range(numTrainDocs):

if trainCategory[i] == 1:

p1Num += trainMatrix[i]

p1Denom += sum(trainMatrix[i])

else:

p0Num += trainMatrix[i]

p0Denom += sum(trainMatrix[i])

# p1Vect = p1Num/p1Denom # 对每个元素做除法

# p0Vect = p0Num/p0Denom

p1Vect = np.log(p1Num/p1Denom)

p0Vect = np.log(p0Num/p0Denom)

return p0Vect,p1Vect,pAbusive

# 程序4-3 朴素贝叶斯分类函数

'''

输入:要分类的向量vec2Classify,使用trainNB0()计算得到的三个概率

'''

def classifyNB(vec2Classify, p0Vec, p1Vec, pClass1):

p1 = sum(vec2Classify * p1Vec) + np.log(pClass1) # 元素相乘

p0 = sum(vec2Classify * p0Vec) + np.log(1 - pClass1)

if p1 > p0:

return 1

else:

return 0

# 接收大字符串,并将其解析为字符串列表

def textParse(bigString):

import re

listOfTokens = re.split(r'\W*', bigString) # 分隔符为除单词、数字外的任意字符串

return [tok.lower() for tok in listOfTokens if len(tok) > 2] # 去掉少于两个字符的字符串,并将其转为小写

# 对贝叶斯垃圾邮件分类器进行自动化处理

def spamTest():

docList = [] # 文档列表

classList = [] # 类别列表

fullText= [] # 全文列表

for i in range(1, 26): # 导入并解析文本

wordList = textParse(open('email/spam/%d.txt' % i, 'r').read()) # 读取第i个文档

docList.append(wordList) # 将切割后词语列表放进文档列表

fullText.extend(wordList)

classList.append(1) # 将文本对应类别将入类别列表

wordList = textParse(open('email/ham/%d.txt' % i, 'r').read())

# 读取第i个文档

docList.append(wordList) # 将切割后词语列表放进文档列表

fullText.extend(wordList)

classList.append(0)

vocabList = createVocabList(docList) # 生成词语列表

trainingSet = list(range(50)) # 训练集 整数列表0-49

testSet = [] # 测试集

for i in range(10): # 随机选择10个文件

randIndex = int(np.random.uniform(0, len(trainingSet))) # 在0-50范围内随机生成一个实数

testSet.append(trainingSet[randIndex]) # 将文件加入测试集

del(trainingSet[randIndex]) # 删除已选择的文件

trainMat = [] # 训练矩阵

trainClasses = []

for docIndex in trainingSet: # 对训练集中的每篇文档构建词向量

trainMat.append(setOfWord2Vec(vocabList, docList[docIndex]))

trainClasses.append(classList[docIndex])

p0V,p1V,pSpam = trainNB0(np.array(trainMat), np.array(trainClasses))

errorCount = 0

# 遍历测试集,对其中的每封电子邮件进行分类

for docIndex in testSet:

wordVector = setOfWord2Vec(vocabList, docList[docIndex]) # 构建词向量

if classifyNB(np.array(wordVector), p0V, p1V, pSpam) != classList[docIndex]: # 判断分类类别与实际类别是否相等

errorCount += 1

print("the error rate is:", float(errorCount) / len(testSet))

# 调用函数,进行测试

spamTest()

运行结果:

参考资料:

1.《机器学习实战》

2.https://cuijiahua.com/blog/2017/11/ml_5_bayes_2.html