一.概述

二.理论基础

三.文档分类

四.垃圾邮件过滤

五.从个人广告中获取区域倾向

六.代码问题总结

七.总结

一、概述

贝叶斯分类是一类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类。本章首先介绍贝叶斯分类算法的基础——贝叶斯定理。最后,我们通过实例来讨论贝叶斯分类的中最简单的一种: 朴素贝叶斯分类。

二、理论基础

1 条件概率公式

相信学过概率论的同学对于概率论绝对不会陌生,如果一时觉得生疏,可以查阅相关资料,在这里主要是想贴出条件概率的计算公式:

P(A|B)=P(A,B)/P(B)=P(B|A)*P(A)/P(B)

2 如何使用条件概率进行分类

假设这里要被分类的类别有两类,类c1和类c2,那么我们需要计算概率p(c1|x,y)和p(c2|x,y)的大小并进行比较:

如果:p(c1|x,y)>p(c2|x,y),则(x,y)属于类c1

p(c1|x,y)<p(c2|x,y),则(x,y)属于类c2

我们知道p(x,y|c)的条件概率所表示的含义为:已知类别c1条件下,取到点(x,y)的概率;那么p(c1|x,y)所要表达的含义呢?显然,我们同样可以按照条件概率的方法来对概率含义进行描述,即在给定点(x,y)的条件下,求该点属于类c1的概率值。那么这样的概率该如何计算呢?显然,我们可以利用贝叶斯准则来进行变换计算:

p(ci|x,y)=p(x,y|ci)*p(ci)/p(x,y)

利用上面的公式,我们可以计算出在给定实例点的情况下,分类计算其属于各个类别的概率,然后比较概率值,选择具有最大概率的那么类作为点(x,y)的预测分类结果。

以上我们知道了通过贝叶斯准则来计算属于各个分类的概率值,那么具体而言,就是计算贝叶斯公式中的三个概率,只要得到了这三个概率值,显然我们就能通过贝叶斯算法预测分类的结果了。因此,到了这里,我们就知道了朴树贝叶斯算法的核心所在了。

3 朴素贝叶斯

朴素贝叶斯是使用概率论来分类的算法。其中朴素:各特征条件独立;贝叶斯:根据贝叶斯定理。

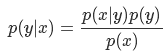

根据贝叶斯定理,对一个分类问题,给定样本特征x,样本属于类别y的概率是:

在这里,x 是一个特征向量,设 x 维度为 M。因为朴素的假设,即特征条件独立,根据全概率公式展开,上式可以表达为:

这里,只要分别估计出,特征 Χi 在每一类的条件概率就可以了。类别 y 的先验概率可以通过训练集算出,同样通过训练集上的统计,可以得出对应每一类上的,条件独立的特征对应的条件概率向量。

4 算法特点

优点:在数据较少的情况下仍然有效,可以处理多类别问题。

缺点:对于输入数据的准备方式较为敏感。

适用数据类型:标称型数据。

三、文档分类

朴素贝叶斯的一个非常重要的应用就是文档分类。在文档分类中,整个文档(比如一封电子邮件)是实例,那么邮件中的单词就可以定义为特征。说到这里,我们有两种定义文档特征的方法。一种是词集模型,另外一种是词袋模型。顾名思义,词集模型就是对于一篇文档中出现的每个词,我们不考虑其出现的次数,而只考虑其在文档中是否出现,并将此作为特征;假设我们已经得到了所有文档中出现的词汇列表,那么根据每个词是否出现,就可以将文档转为一个与词汇列表等长的向量。而词袋模型,就是在词集模型的基础上,还要考虑单词在文档中出现的次数,从而考虑文档中某些单词出现多次所包含的信息。

开发流程

使用朴素贝叶斯对电子邮件进行分类

收集数据: 提供文本文件

准备数据: 将文本文件解析成词条向量

分析数据: 检查词条确保解析的正确性

训练算法: 使用我们之前建立的 trainNB() 函数

测试算法: 使用朴素贝叶斯进行交叉验证

使用算法: 构建一个完整的程序对一组文档进行分类,将错分的文档输出到屏幕上1 从文本中构建词条向量

要从文本中获取特征,需要先拆分文本,这里特征是指来自文本的词条,每个词条是字符的任意组合。词条可以理解为单词,当然也可以是非单词词条,比如URL、IP地址或者其他任意字符串 。将文本拆分成词条向量后,将每一个文本片段表示为一个词条向量,值为1表示出现在文档中,值为0表示词条未出现

2 由词向量计算朴素贝叶斯用到的概率值

这里,如果我们将之前的点(x,y)换成词条向量w(各维度的值由特征是否出现的0或1组成),在这里词条向量的维度和词汇表长度相同。p(ci|w)=p(w|ci)*p(ci)/p(w)我们将使用该公式计算文档词条向量属于各个类的概率,然后比较概率的大小,从而预测出分类结果。

具体地,首先,可以通过统计各个类别的文档数目除以总得文档数目,计算出相应的p(ci);然后,基于条件独立性假设,将w展开为一个个的独立特征,那么就可以将上述公式写为p(w|ci)=p(w0|ci)*p(w1|ci)*...p(wN|ci),这样就很容易计算,从而极大地简化了计算过程。

函数的伪代码为:

计算每个类别文档的数目

计算每个类别占总文档数目的比例

对每一篇文档:

对每一个类别:

如果词条出现在文档中->增加该词条的计数值#统计每个类别中出现的词条的次数

增加所有词条的计数值#统计每个类别的文档中出现的词条总数

对每个类别:

将各个词条出现的次数除以类别中出现的总词条数目得到条件概率

返回每个类别各个词条的条件概率和每个类别所占的比例

3 针对算法的部分改进

1)计算概率时,需要计算多个概率的乘积以获得文档属于某个类别的概率,即计算p(w0|ci)*p(w1|ci)*...p(wN|ci),然后当其中任意一项的值为0,那么最后的乘积也为0.为降低这种影响,采用拉普拉斯平滑,在分子上添加a(一般为1),分母上添加ka(k表示类别总数),即在这里将所有词的出现数初始化为1,并将分母初始化为2*1=2

2)解决下溢出问题

正如上面所述,由于有太多很小的数相乘。计算概率时,由于大部分因子都非常小,最后相乘的结果四舍五入为0,造成下溢出或者得不到准确的结果,所以,我们可以对成绩取自然对数,即求解对数似然概率。这样,可以避免下溢出或者浮点数舍入导致的错误。同时采用自然对数处理不会有任何损失。

4、所有准备工作做完了之后,就可以写朴素贝叶斯的分类器了。在这里用到是词集模型,即对于一篇文档,将文档中是否出现某一词条作为特征,即特征只能为0不出现或者1出现;然后,一篇文档中词条的出现次数也可能具有重要的信息,于是我们可以采用词袋模型,在词袋向量中每个词可以出现多次,这样,在将文档转为向量时,每当遇到一个单词时,它会增加词向量中的对应值。

四、过滤垃圾邮件

完成朴素贝叶斯的一个最著名的应用: 电子邮件垃圾过滤。

开发流程

使用朴素贝叶斯对电子邮件进行分类

收集数据: 提供文本文件

准备数据: 将文本文件解析成词条向量

分析数据: 检查词条确保解析的正确性

训练算法: 使用我们之前建立的 trainNB() 函数

测试算法: 使用朴素贝叶斯进行交叉验证

使用算法: 构建一个完整的程序对一组文档进行分类,将错分的文档输出到屏幕上对于一个文本字符串,可以使用python的split()方法对文本进行切割,比如字符串'hello, Mr.lee.',分割结果为['hell0,','Mr.lee.'] 这样,标点符合也会被当成词的一部分,因为此种切割方法是基于词与词之间的空格作为分隔符的。此时,我们可以使用正则表达式来切分句子,其中分割符是除单词和数字之外的其他任意字符串,即

import re

re.compile('\\W*')

这样就得到了一系列词组成的词表,但是里面的空字符串还是需要去掉,此时我们可以通过字符的长度,去掉长度等于0的字符。并且,由于我们是统计某一词是否出现,不考虑其大小写,所有还可以将所有词转为小写字符,即lower(),相应的,转为大写字符为upper()。此外,需要注意的是,由于是URL,因而可能会出现en和py这样的单词。当对URL进行切分时,会得到很多的词,因此在实现时也会过滤掉长度小于3的词。当然,也可以根据自己的实际需要来增加相应的文本解析函数。

在这里,采用随机选择的方法从数据集中选择训练集,剩余的作为测试集。这种方法的好处是,可以进行多次随机选择,得到不同的训练集和测试集,从而得到多次不同的错误率,我们可以通过多次的迭代,求取平均错误率,这样就能得到更准确的错误率。这种方法称为留存交叉验证。

五、从个人广告中获取区域倾向

广告商往往想知道关于一个人的一些特定人口统计信息,以便能更好地定向推销广告。

我们将分别从美国的两个城市中选取一些人,通过分析这些人发布的信息,来比较这两个城市的人们在广告用词上是否不同。如果结论确实不同,那么他们各自常用的词是那些,从人们的用词当中,我们能否对不同城市的人所关心的内容有所了解。

开发流程

收集数据: 从 RSS 源收集内容,这里需要对 RSS 源构建一个接口

准备数据: 将文本文件解析成词条向量

分析数据: 检查词条确保解析的正确性

训练算法: 使用我们之前简历的 trainNB0() 函数

测试算法: 观察错误率,确保分类器可用。可以修改切分程序,以降低错误率,提高分类结果

使用算法: 构建一个完整的程序,封装所有内容。给定两个 RSS 源,改程序会显示最常用的公共词1 利用RSS源得到文本数据,Universal Feed Parser是Python中最常见的RSS程序库。通过如下语句可以获得相应的文本数据

2 获取并统计相关数据 。需要说明的是,这里用到了将出现次数最多的30个单词删除的方法,结果发现去掉了这些最常出现的高频词后,错误率大幅度上升,这表明了文本中的小部分高频单词占据了文本中绝大部分的用词。产生这种情况的原因是因为语言中大部分是冗余和结果辅助性内容。所以,我们不仅可以尝试移除高频词的方法,还可以进一步从某个预定词表(停用词表)中移除结构上的辅助词,通过移除辅助性词,分类错误率会所有下降。 此外,为了得到错误率的精确估计,应进行多次上述实验,从而得到错误率平均值。

3 对得到的数据进行分析。得到各个用词的概率之后,我们可以设定相应的阈值,保留大于相应阈值的用词及其出现的概率,然后按照概率的大小进行排序;最后返回两个地域最具表征性的词汇,观察和比较他们的异同。

六、代码问题总结

1.python模块之feedparser学习使用

2.Python3 异常捕获。因为文中的数据集是有一些格式错误的,在编写代码的时候应该使用各种方法去找出错误源,进行相应的调试。

3.python 3.x中列表中元素删除del、remove、pop的用法及区别。

4.Python3 uniform() 函数。

5.python3 re模块。

以上问题是自己在写程序的时候遇到的一些问题的总结与学习。

七、总结

尽管朴素贝叶斯的条件独立性假设存在一定的问题,但是朴素贝叶斯算法仍然能取得比较理想的分类预测结果。此外,朴素贝叶斯在数据较少的情况下仍然适用,虽然例子中为两类类别的分析,但是朴素贝叶斯可以处理多分类的情况;朴素贝叶斯的一个不足的地方是,对输入的数据有一定的要求,需要花费一定的时间进行数据的处理和解析。朴素贝叶斯中用来计算的数据为标称型数据,我们需要将字符串特征转化为相应的离散值,用于后续的统计和计算。