Hadoop伪分布搭建:https://blog.csdn.net/qq_38038143/article/details/83144840

Hadoop集群搭建:https://blog.csdn.net/qq_38038143/article/details/83050840

本次环境为,Hadoop2.7.3,Hadoop集群。

1. 官网下载linux版eclipse

官网:https://www.eclipse.org/downloads/packages/

安装Hadoop-Eclipse-Plugin插件:https://download.csdn.net/download/qq_38038143/10745367

2. 配置

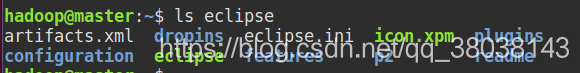

2.1解压Eclipse:

tar -zxvf eclipse-committers-2018-09-linux-gtk-x86_64.tar.gz -C ~/

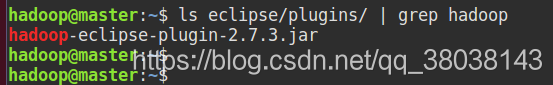

2.2将 hadoop-eclipse-plugin.rar中的 jar文件 复制到 eclipse/plugins 目录下:

使用Ubuntu自带文件,进入eclipse解压目录,右键eclipse运行,并选择工作目录:

注:eclipse的其他配置如自动提示、注解作者时间等请百度。

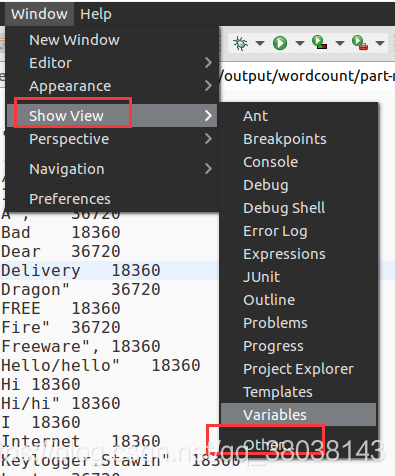

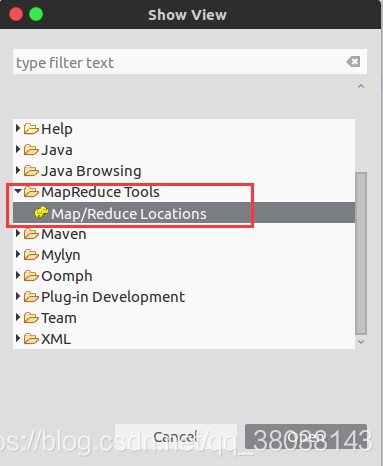

2.3选择 Window 下的 Show View 和 Other:

找到MapReduce Tools,选择点击Open:

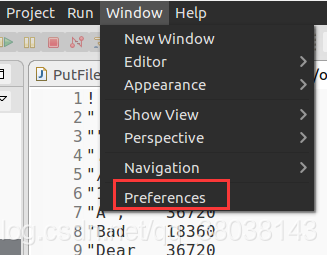

2.4选择 Window 下的 Preferences:

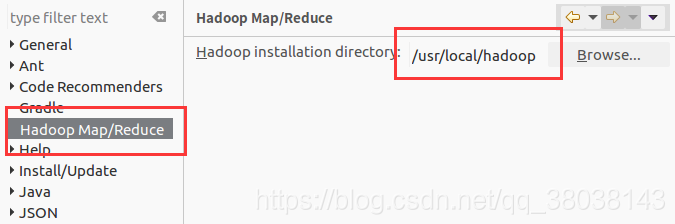

因为在plugins目录下添加了hadoop-eclipse-plugin文件,所以可以看到Hadoop Map/Reduce,选中并选择Hadoop的安装目录:

2.5选择 Window 下的 Preferences:

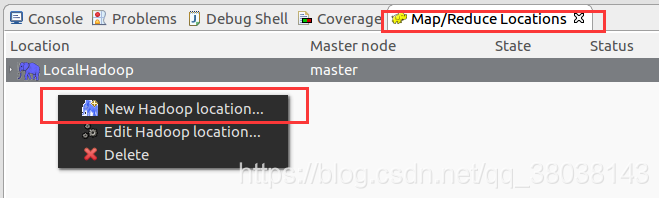

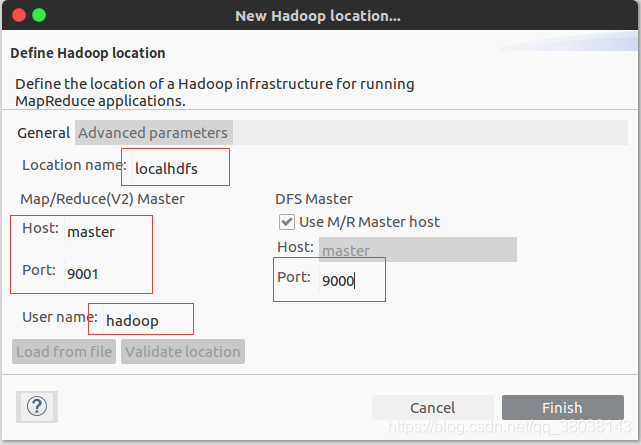

定义Hadoop集群的链接:

新建Hadoop Localtion:

注:master为在/etc/hosts 中添加的IP地址映射,若未添加映射,应写主节点的IP地址。

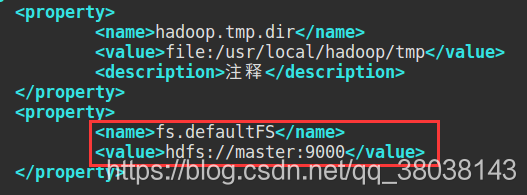

上述配置参考core-site.xml配置文件:

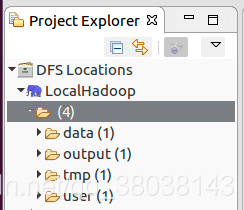

点击Finish后,Eclipse界面左端会出现DFSLocations,并且已连接上HDFS:

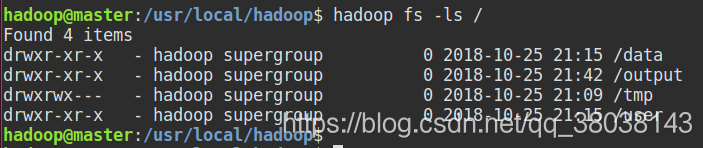

终端查看:

3. 测试上传文件:

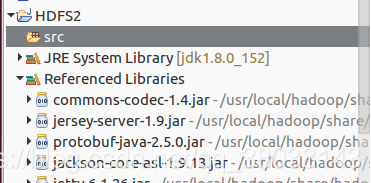

3.1 新建Map/Reduce 项目:

项目自动添加依赖:

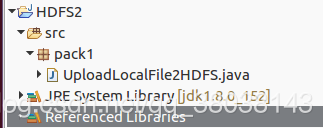

3.2 创建java类:

创建UploadLocalFile2HDFS.java:

代码:

package pack1;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

/**

* @author: Gu Yongtao

* @Description:

* @date: 2018年10月26日

* @Filename: UploadLocalFile2HDFS.java

*/

public class UploadLocalFile2HDFS {

public static void main(String[] args) throws IOException, URISyntaxException {

Configuration conf = new Configuration();

URI uri = new URI("hdfs://master:9000");

FileSystem fs = FileSystem.get(uri, conf);

// 本地文件

Path src = new Path("/home/hadoop/file");

//HDFS存放位置

Path dst = new Path("/");

fs.copyFromLocalFile(src, dst);

System.out.println("Upload to " + conf.get("fs.defaultFS"));

//相当于hdfs dfs -ls /

FileStatus files[] = fs.listStatus(dst);

for (FileStatus file:files) {

System.out.println(file.getPath());

}

}

}

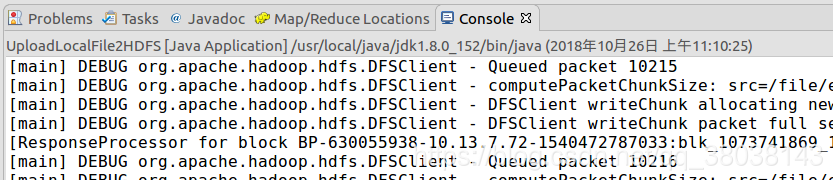

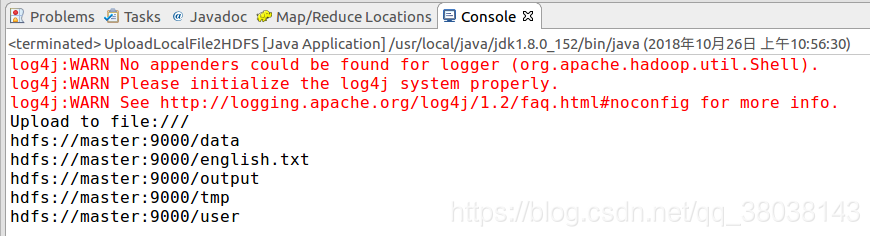

点击运行 UploadLocalFile2HDFS 程序:

等待上传完毕,控制台输出如下:

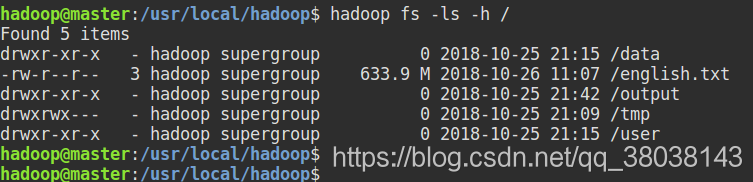

查看HDFS文件系统:

上传成功。

3.3 若想解决log4j的警告信息,可以添加如下设置:

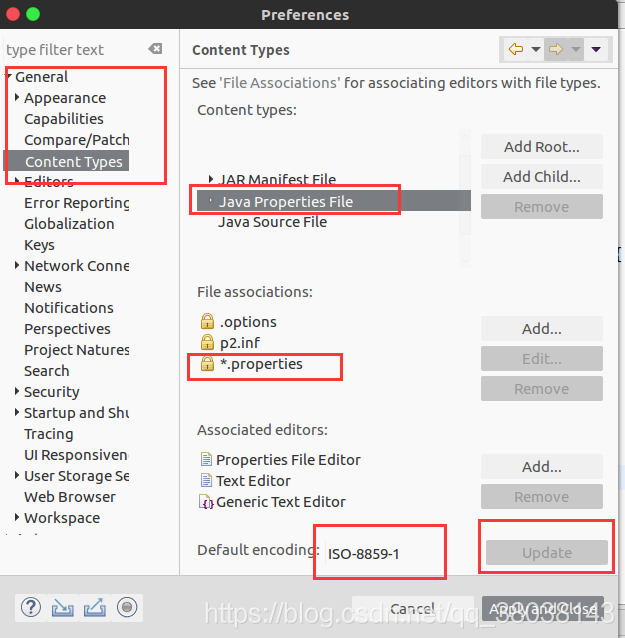

在window窗口,点击General > Content Types > 在右侧中间下拉 Text > Java Properties File:其默认编码为ISO-8859-1,修改为UTF-8(若不使用中文可以不修改)。

修改为UTF-8,点击Update:

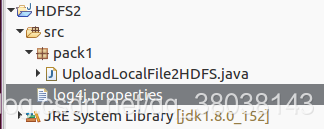

在 src 目录下创建 log4j.properties 文件:

log4j.properties 添加如下内容:

# Configure logging for testing: optionally with log file

#可以设置级别:debug>info>error

#debug:可以显式debug,info,error

#info:可以显式info,error

#error:可以显式error

log4j.rootLogger=debug,appender1

#log4j.rootLogger=info,appender1

#log4j.rootLogger=error,appender1

#输出到控制台

log4j.appender.appender1=org.apache.log4j.ConsoleAppender

#样式为TTCCLayout

log4j.appender.appender1.layout=org.apache.log4j.TTCCLayout

保存后,重新运行 UploadLocalFile2HDFS ,控制台将显示debug信息,控制台文字过多可将debug注释: