前向传播:

这里只说CNN前向传播不同于全连接前向传播的部分,即:输入层到卷积层和卷积层到池化层。

1、输入层到卷积层的前向传播

输入层到卷积层,采用的是局部连接,参数共享,卷积操作的方式,进行计算的,有个最好的说明就是cs231n笔记中的gif图,现展示如下:

图中有两个卷积核,w0和w1,注:这两个卷积核是已经翻转过的,然后进行协相关操作。由于输入的是3个通道的图片,因此每个卷积核也必须是3个通道的。所谓局部连接、权值共享都在这幅图上体现的淋淋尽致,非常好的表达。

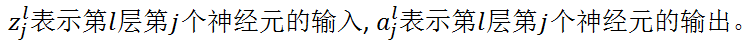

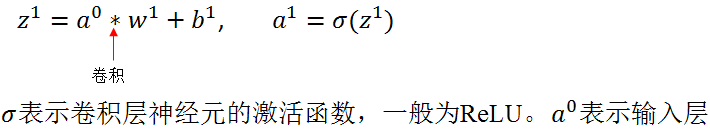

现作理论推导:

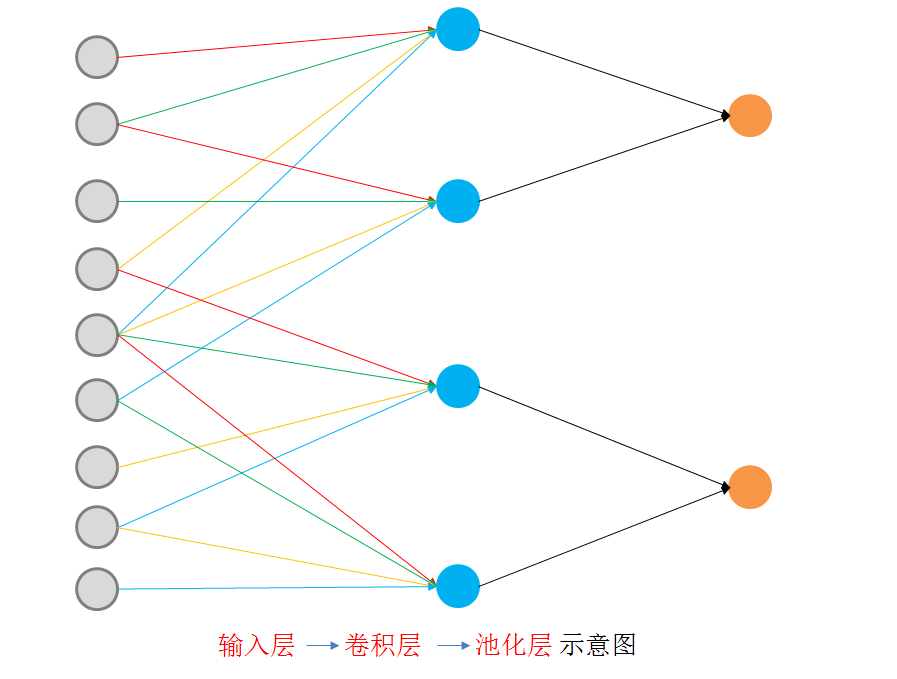

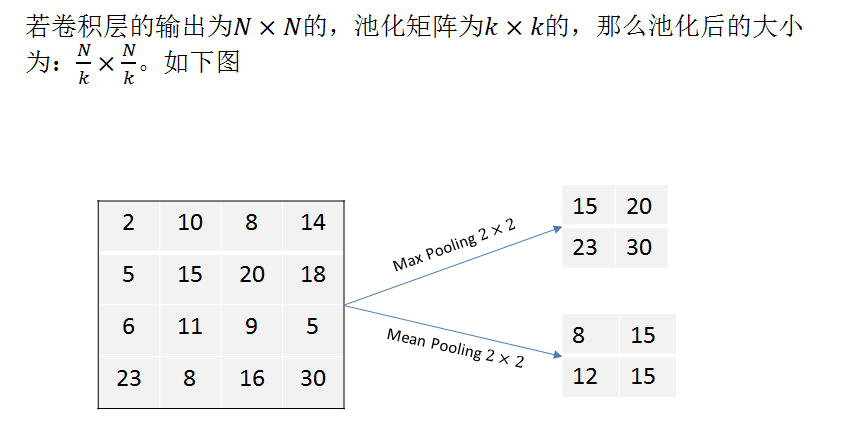

2、卷积层到池化层的前向传播:

前向传播比较简单,介绍就到这里,下面分析反向传播算法:

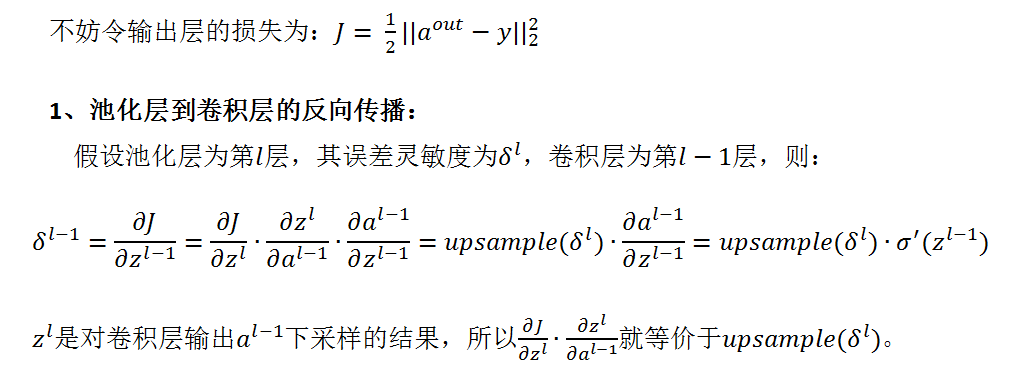

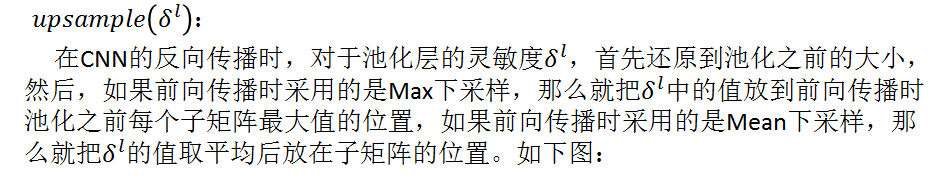

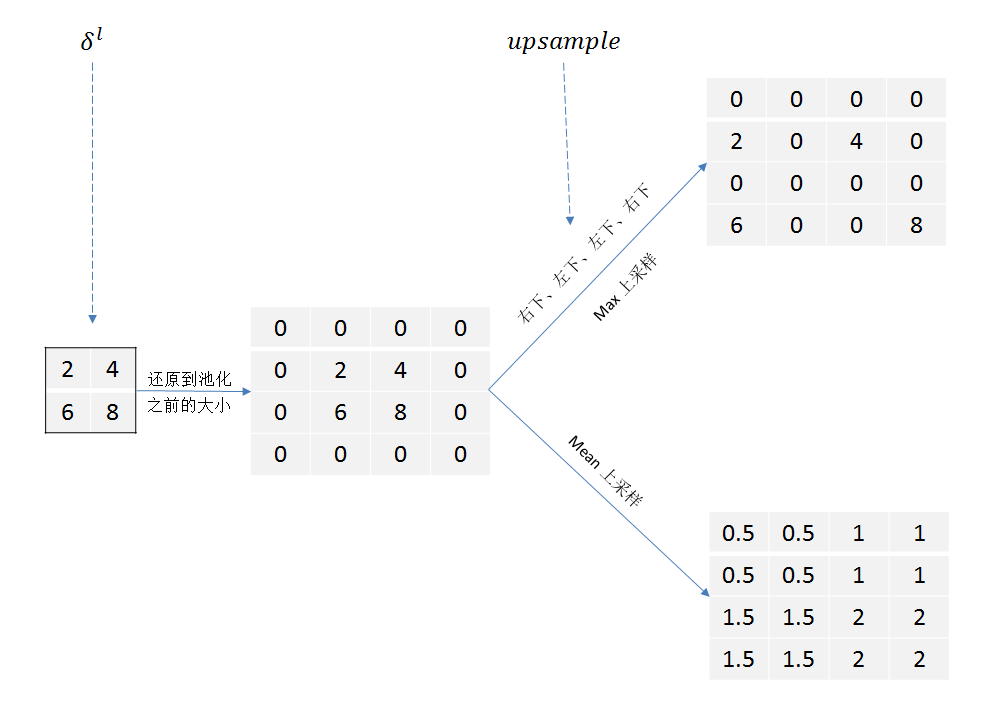

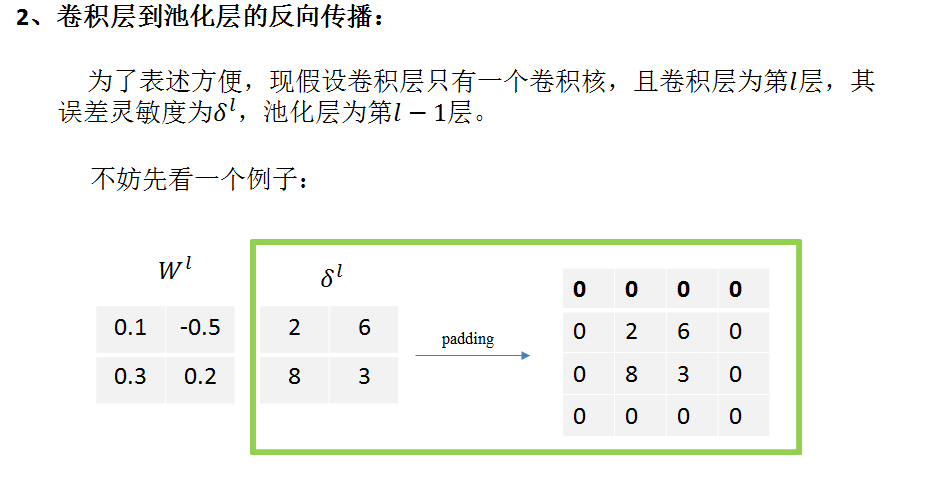

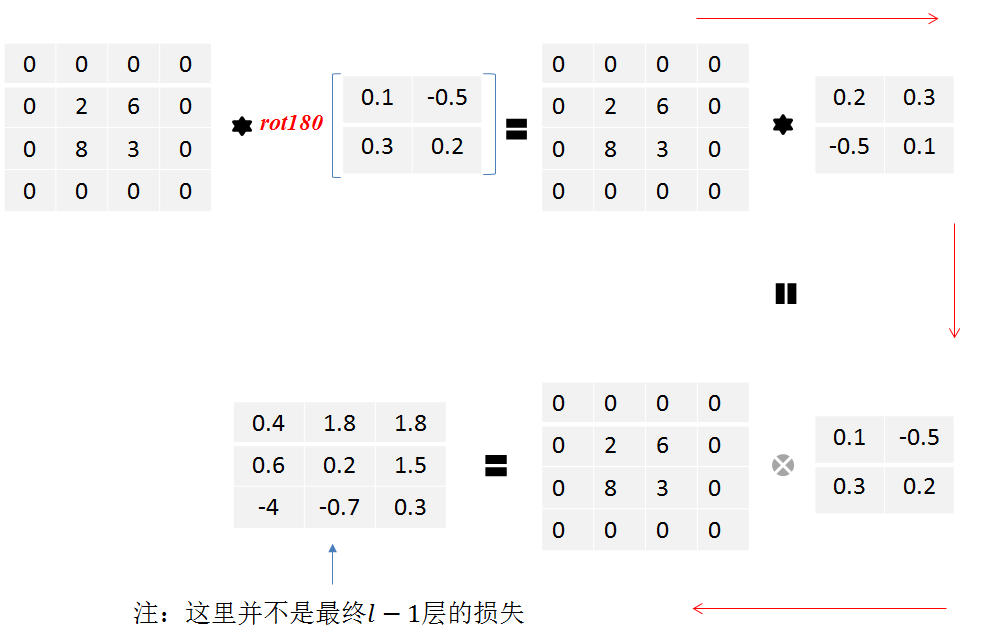

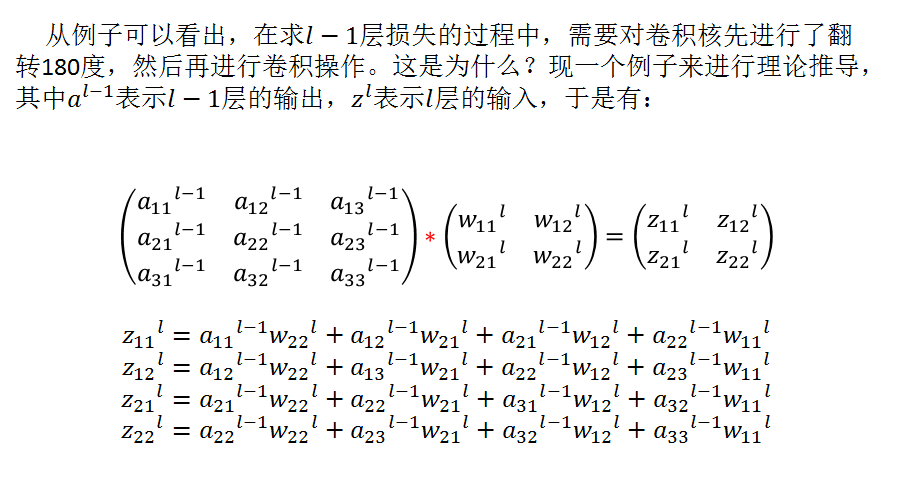

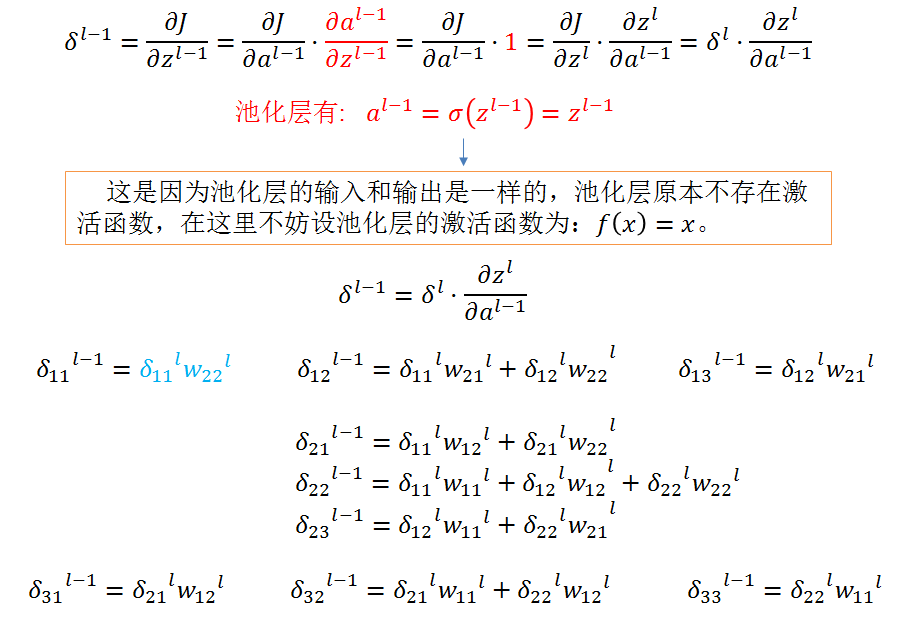

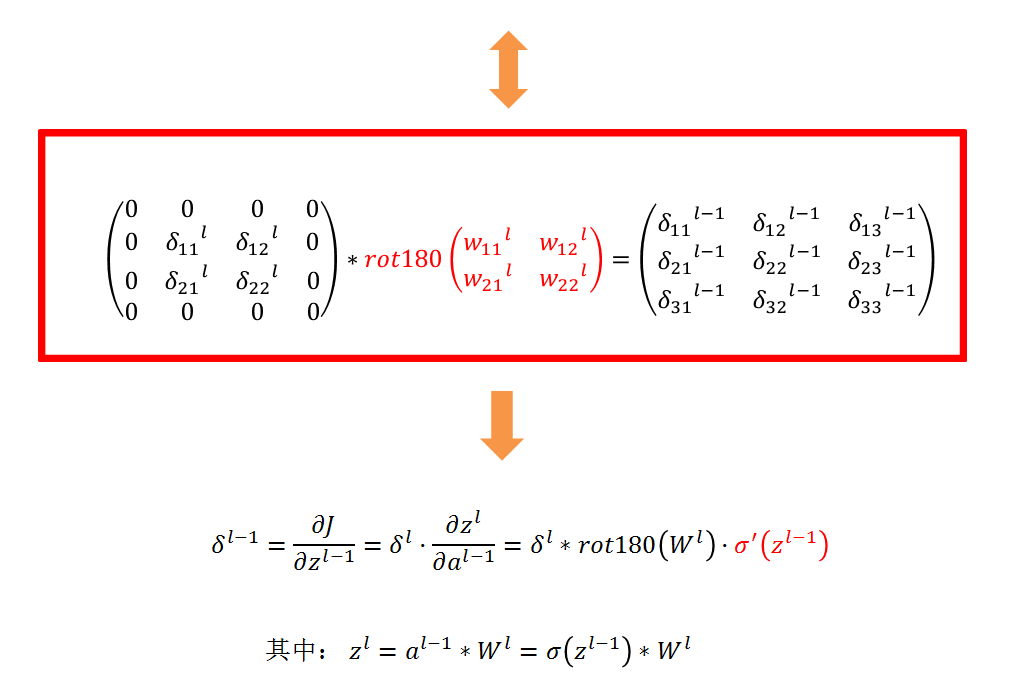

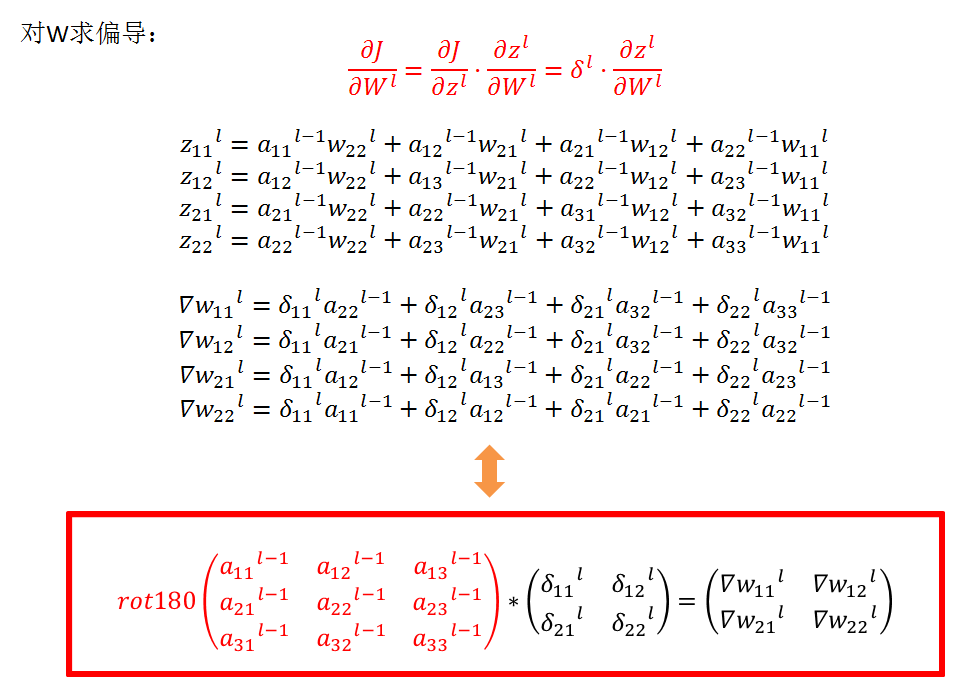

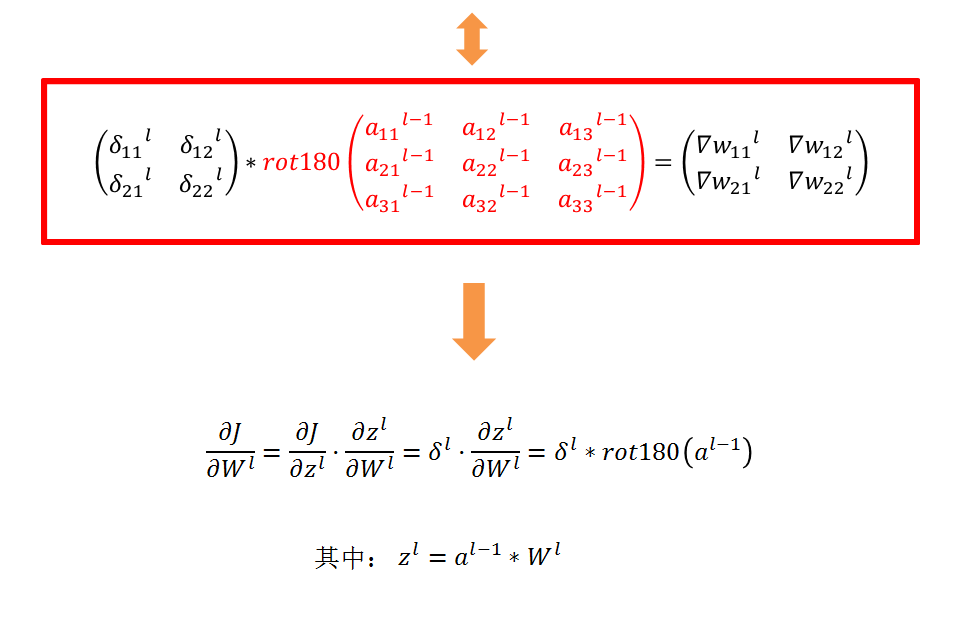

CNN的反向传播其实与全连接神经网络的反向传播有很大不同,只是从最后的输出层到最后一个卷积层的池化层的误差计算方式是相同的,但是从池化层到卷积层,卷积层到输出层(or池化层)的误差传播方式与全连接网络是大不相同的。