3 种爬取网站的常见方法:

- 下载网页

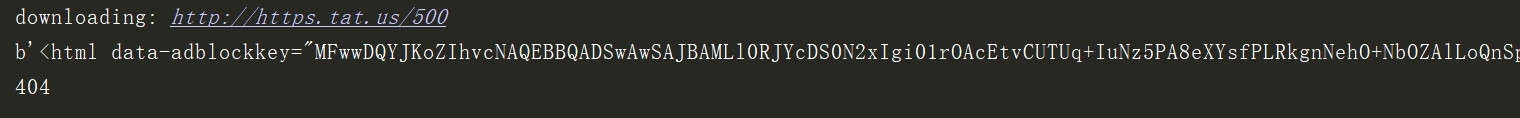

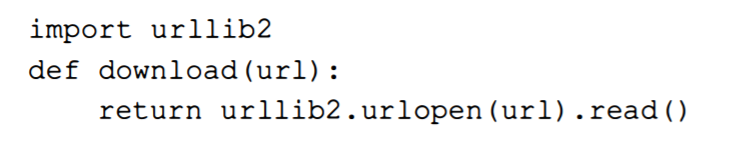

首先需要把网页下载下来,使用Python 的urllib 2 模块下载URL。

不过这样子的无法处理一些异常情况,如网页不存在,可以加入异常处理机制。

有时候服务器过载返回503 Service Unavailable错误是临时性的,我们可以尝试重新下载,并设置重试下载次数。

实验结果。。。

3 种爬取网站的常见方法:

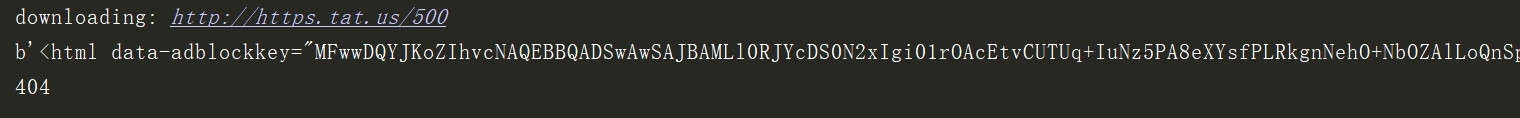

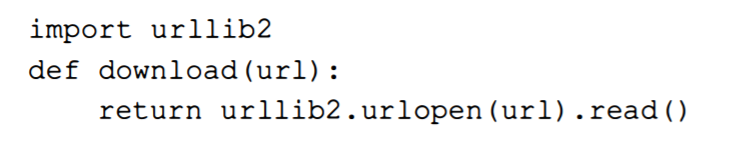

首先需要把网页下载下来,使用Python 的urllib 2 模块下载URL。

不过这样子的无法处理一些异常情况,如网页不存在,可以加入异常处理机制。

有时候服务器过载返回503 Service Unavailable错误是临时性的,我们可以尝试重新下载,并设置重试下载次数。

实验结果。。。