我的训练的是VGGnet19,训练从一开始loss就一直是NAN,ACC准确率也很低,而且一直也没有提高的迹象,在0.0xx徘徊。

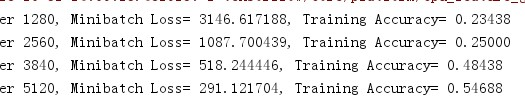

我发现我的网络中未加归一化操作,最后在每层都加了归一化层,解决了该问题,见下图,loss逐渐减少,ACC逐步增大,呵呵。

(**提示**:在2015年 Very Deep Convolutional Networks for Large-Scale Image Recognition.提到LRN基本没什么用。)

# 归一化定义

def norm(name, l_input, lsize=4):

return tf.nn.lrn(l_input, lsize, bias=1.0, alpha=0.001 / 9.0, beta=0.75, name=name)

#省略其他

# 第3段卷积层

conv3_1 = conv2d('conv3_1', norm2, _weights['wc3_1'], _biases['bc3_1'])#28*28

conv3_2 = conv2d('conv3_2', conv3_1, _weights['wc3_2'], _biases['bc3_2'])#28*28

conv3_3 = conv2d('conv3_3', conv3_2, _weights['wc3_3'], _biases['bc3_3'])#28*28

conv3_4 = conv2d('conv3_4', conv3_3, _weights['wc3_4'], _biases['bc3_4'])#28*28

pool3 = max_pool('pool3', conv3_4, k1=2, k2=2)#14*14

norm3 = norm('norm3', pool3, lsize=4)在网上查了一些资料,汇总可能的原因还可能是如下原因:

1、学习步长过大,(现象可能是loss越来越大,最后变成NAN)

2、网络结构有问题

3、网络中未加归一化操作

4、训练数据中有脏数据,(现象可能是: 在训练中loss突然变为NAN,在公共数据集不存在此现象,比如mnist,cifar)

5、求损失loss时的交叉熵函数中log函数出现log(0)的情况,一般解决办法是加clip对值进行范围限制。比如cross_entropy=-tf.reduce_sum(y*tf.log(tf.clip_by_value(pred,1e-10,1.0)))