aggregate

(

zeroValue

,

seqOp

,

combOp

)

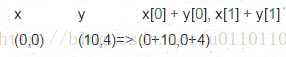

seqOp操作会聚合各分区中的元素,然后combOp操作把所有分区的聚合结果再次聚合,两个操作的初始值都是zeroValue. seqOp的操作是遍历分区中的所有元素(y),第一个y跟zeroValue做操作,结果再为与第二个y做操作,直到遍历完整个分区。combOp操作是把各分区聚合的结果,再聚合。aggregate函数返回一个跟RDD不同类型的值。因此,需要一个操作seqOp来把分区中的元素y合并成一个x,另外一个操作combOp把所有x(seqOp的结果)聚合。

seqOp= (lambda x, y: (x[0]+ y, x[1]+1))

combOp = (lambda x, y: (x[0]+ y[0], x[1]+ y[1]))

sc.parallelize([1,2,3,4]).aggregate((0,0), seqOp, combOp)

(10, 4)

过程:

seqOp的操作:

zeroValue(0,0) x相当于是当轮的结果(第一轮的时候x=zeroValue),y是分区中的元素

combOp的操作:

y是上一轮运算的x,这里即时(10,4)