近来,DeepMind的一篇论文《LARGE SCALE GAN TRAINING FOR

SNR的讨论是从网络的泛化((Generalizability))开始的。对于Deep Learning而言,泛化是一个重要的性能指标,直觉上它与扰动(Perturbation)的影响有关。我们可以这样理解:局部最小点附近如果是平坦(flatness)的话,那么其泛化的性能将较好,反之,若是不平坦(sharpness)的话,稍微一点变动,将产生较大变化,则其泛化性能一点不好,因此,我们可以从网络对抗扰动的性能入手来提升网络的泛化能力。

扰动(Perturbation)的来源有两个:1)参数的扰动;2)输入的扰动。[2]是从输入扰动角度来进行讨论的。假设一个前馈网络的第

l

l

l

x

l

=

f

l

(

W

l

x

l

−

1

+

b

l

)

(

1

)

\mathbf x^l=f^l(W^l\mathbf x^{l-1}+\mathbf b^l)\qquad(1)

x l = f l ( W l x l − 1 + b l ) ( 1 )

x

l

\mathbf x^l

x l

l

l

l

x

l

−

1

\mathbf x^{l-1}

x l − 1

l

l

l

W

l

,

b

l

W^l,\mathbf b^l

W l , b l

f

l

(

⋅

)

f^l(\cdot)

f l ( ⋅ )

l

=

1

,

⋯

,

L

l=1,\cdots,L

l = 1 , ⋯ , L

Θ

=

{

W

l

,

b

l

}

l

=

1

L

\Theta = \{ W^l,\mathbf b^l\}^L_{l=1}

Θ = { W l , b l } l = 1 L

(

x

i

,

y

i

)

i

=

1

K

(\mathbf x_i, \mathbf y_i)^K_{i=1}

( x i , y i ) i = 1 K

x

i

∈

R

n

0

,

y

i

∈

R

n

L

\mathbf x_i \in \mathbb R^{n_0},\mathbf y_i \in \mathbb R^{n_L}

x i ∈ R n 0 , y i ∈ R n L

L

o

s

s

=

1

K

∑

i

=

1

K

L

(

f

Θ

(

x

i

)

,

y

i

)

(

2

)

Loss=\frac{1}{K}\sum^K_{i=1}L(f_{\Theta}(\mathbf x_i),\mathbf y_i)\qquad(2)

L o s s = K 1 i = 1 ∑ K L ( f Θ ( x i ) , y i ) ( 2 )

L

(

⋅

)

L(\cdot)

L ( ⋅ )

l

2

l_2

l 2

x

→

x

+

ξ

f

(

x

)

→

f

(

x

+

ξ

)

So we define:

P

=

∥

f

(

x

+

ξ

)

−

f

(

x

)

∥

∥

ξ

∥

(

3

)

\mathbf x\rightarrow \mathbf x+\mathbf \xi \\ f(\mathbf x) \rightarrow f(\mathbf x +\mathbf \xi )\\ \text{So we define:}\\ P=\frac{\Vert f(\mathbf x +\mathbf \xi )-f(\mathbf x)\Vert}{\Vert \mathbf \xi \Vert} \qquad(3)

x → x + ξ f ( x ) → f ( x + ξ ) So we define: P = ∥ ξ ∥ ∥ f ( x + ξ ) − f ( x ) ∥ ( 3 ) 扰动指数 ——

P

P

P

x

\mathbf x

x

x

\mathbf x

x

∥

f

(

x

+

ξ

)

−

f

(

x

)

∥

∥

ξ

∥

=

∥

W

Θ

,

x

(

x

+

ξ

)

+

b

Θ

,

x

−

W

Θ

,

x

x

−

b

Θ

,

x

∥

∥

ξ

∥

=

∥

W

Θ

,

x

ξ

∥

∥

ξ

∥

≤

σ

(

W

Θ

,

x

)

(

4

)

\frac{\Vert f(\mathbf x +\mathbf \xi )-f(\mathbf x)\Vert}{\Vert \mathbf \xi \Vert} = \frac{\Vert W_{\Theta,x}(\mathbf x +\mathbf \xi )+\mathbf b_{\Theta,x}-W_{\Theta,x}\mathbf x -\mathbf b_{\Theta,x}\Vert}{\Vert \mathbf \xi \Vert}\\ =\frac{\Vert W_{\Theta,x} \xi \Vert}{\Vert \mathbf \xi \Vert} \le \sigma(W_{\Theta,x}) \qquad(4)

∥ ξ ∥ ∥ f ( x + ξ ) − f ( x ) ∥ = ∥ ξ ∥ ∥ W Θ , x ( x + ξ ) + b Θ , x − W Θ , x x − b Θ , x ∥ = ∥ ξ ∥ ∥ W Θ , x ξ ∥ ≤ σ ( W Θ , x ) ( 4 )

σ

(

W

Θ

,

x

)

\sigma(W_{\Theta,x})

σ ( W Θ , x )

W

Θ

,

x

W_{\Theta,x}

W Θ , x

A is a matrix,

A

∈

R

m

×

n

σ

(

A

)

=

m

a

x

ξ

∈

R

m

×

n

,

ξ

≠

0

∥

A

ξ

∥

∥

ξ

∥

(

5

)

\text{ A is a matrix, } A \in \mathbb R^{m\times n}\\ \sigma(A) = max_{\xi \in R^{m\times n},\xi \neq0} \frac{\Vert A \xi \Vert}{\Vert\xi\Vert} \qquad(5)

A is a matrix, A ∈ R m × n σ ( A ) = m a x ξ ∈ R m × n , ξ ̸ = 0 ∥ ξ ∥ ∥ A ξ ∥ ( 5 )

A

A

A

l

l

l

D

Θ

,

x

l

∈

R

n

l

×

n

l

D_{\Theta,x}^l \in \mathbb R^{n^l\times n^l}

D Θ , x l ∈ R n l × n l

W

Θ

,

x

W_{\Theta,x}

W Θ , x

y

=

W

Θ

,

x

x

.

W

Θ

,

x

=

D

Θ

,

x

L

W

L

D

Θ

,

x

L

−

1

W

L

−

1

⋯

D

Θ

,

x

1

W

1

(

6

)

\mathbf y = W_{\Theta,x} \mathbf x \\ . \\ W_{\Theta,x}=D_{\Theta,x}^L W^L D_{\Theta,x}^{L-1} W^{L-1}\cdots D_{\Theta,x}^1 W^1 \qquad(6)

y = W Θ , x x . W Θ , x = D Θ , x L W L D Θ , x L − 1 W L − 1 ⋯ D Θ , x 1 W 1 ( 6 )

σ

(

W

Θ

,

x

)

≤

σ

(

D

Θ

,

x

L

)

σ

(

W

Θ

,

x

L

)

σ

(

D

Θ

,

x

L

−

1

)

σ

(

W

Θ

,

x

L

−

1

)

⋯

σ

(

D

Θ

,

x

1

)

σ

(

W

Θ

,

x

1

)

≤

∏

l

=

1

L

σ

(

W

l

)

(

7

)

\sigma(W_{\Theta,x} )\le \sigma(D_{\Theta,x}^L)\sigma(W_{\Theta,x}^L)\sigma(D_{\Theta,x}^{L-1})\sigma(W_{\Theta,x}^{L-1})\cdots\sigma(D_{\Theta,x}^1)\sigma(W_{\Theta,x}^1)\le \prod_{l=1}^L \sigma(W^l)\qquad(7)

σ ( W Θ , x ) ≤ σ ( D Θ , x L ) σ ( W Θ , x L ) σ ( D Θ , x L − 1 ) σ ( W Θ , x L − 1 ) ⋯ σ ( D Θ , x 1 ) σ ( W Θ , x 1 ) ≤ l = 1 ∏ L σ ( W l ) ( 7 )

Θ

=

a

r

g

m

i

n

Θ

(

1

K

∑

i

=

1

K

L

(

f

Θ

(

x

i

)

,

y

i

)

+

λ

2

∑

i

=

1

K

σ

(

W

l

)

2

)

(

8

)

\Theta = argmin_{\Theta}\left(\frac 1 K \sum_{i=1}^K L(f_{\Theta}(\mathbf x_i),\mathbf y_i) + \frac {\lambda}{2} \sum_{i=1}^K \sigma(W^l)^2 \right) \qquad(8)

Θ = a r g m i n Θ ( K 1 i = 1 ∑ K L ( f Θ ( x i ) , y i ) + 2 λ i = 1 ∑ K σ ( W l ) 2 ) ( 8 )

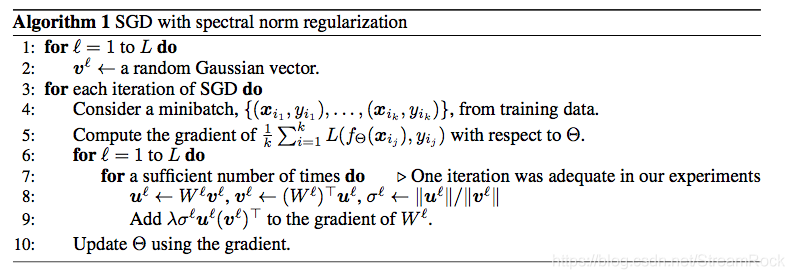

在通过SGD(统计梯度下降)的方法求最优值时,需要(8)式对

Θ

\Theta

Θ

u

n

←

W

v

n

−

1

v

n

←

W

T

u

n

and

σ

(

W

l

)

=

∥

u

∥

2

∥

v

∥

2

(

9

)

u_{n} \leftarrow W v_{n-1}\\ v_{n}\leftarrow W^T u_n\\ \text{and } \sigma(W^l) = \frac{\Vert u \Vert_2} {\Vert v \Vert_2} \qquad(9)

u n ← W v n − 1 v n ← W T u n and σ ( W l ) = ∥ v ∥ 2 ∥ u ∥ 2 ( 9 )

v

0

v_0

v 0

A

=

W

T

W

A=W^TW

A = W T W

n

×

n

n\times n

n × n

λ

1

,

⋯

,

λ

n

\lambda_1,\cdots,\lambda_n

λ 1 , ⋯ , λ n

η

1

,

⋯

,

η

n

\eta_1,\cdots,\eta_n

η 1 , ⋯ , η n

u

(

0

)

=

c

1

η

1

+

⋯

+

c

n

η

n

A

u

(

0

)

=

A

(

c

1

η

1

+

⋯

+

c

n

η

n

)

=

c

1

λ

1

η

1

+

⋯

+

c

n

λ

n

η

n

A

A

u

(

0

)

=

A

A

(

c

1

η

1

+

⋯

+

c

n

η

n

)

=

c

1

λ

1

2

η

1

+

⋯

+

c

n

λ

n

2

η

n

⋯

A

r

u

(

0

)

=

A

r

(

c

1

η

1

+

⋯

+

c

n

η

n

)

=

c

1

λ

1

r

η

1

+

⋯

+

c

n

λ

n

r

η

n

u^{(0)}=c_1\eta_1+\cdots+c_n\eta_n \\ Au^{(0)}=A(c_1\eta_1+\cdots+c_n\eta_n)=c_1\lambda_1\eta_1+\cdots+c_n\lambda_n\eta_n\\ AAu^{(0)}=AA(c_1\eta_1+\cdots+c_n\eta_n)=c_1\lambda_1^2\eta_1+\cdots+c_n\lambda_n^2\eta_n\\ \cdots \\ A^ru^{(0)}=A^r(c_1\eta_1+\cdots+c_n\eta_n)=c_1\lambda_1^r\eta_1+\cdots+c_n\lambda_n^r\eta_n

u ( 0 ) = c 1 η 1 + ⋯ + c n η n A u ( 0 ) = A ( c 1 η 1 + ⋯ + c n η n ) = c 1 λ 1 η 1 + ⋯ + c n λ n η n A A u ( 0 ) = A A ( c 1 η 1 + ⋯ + c n η n ) = c 1 λ 1 2 η 1 + ⋯ + c n λ n 2 η n ⋯ A r u ( 0 ) = A r ( c 1 η 1 + ⋯ + c n η n ) = c 1 λ 1 r η 1 + ⋯ + c n λ n r η n

λ

1

\lambda_1

λ 1

A

r

u

(

0

)

λ

1

r

=

c

1

η

1

+

⋯

+

c

n

(

λ

n

λ

1

)

r

η

n

∵

λ

k

λ

1

<

1

,

∴

lim

r

→

∞

A

r

u

(

0

)

λ

1

r

=

c

1

η

1

\frac{A^ru^{(0)}}{\lambda_1^r}=c_1\eta_1+\cdots+c_n(\frac {\lambda_n} {\lambda_1})^r\eta_n \\ \because \frac{\lambda_k}{\lambda_1}\lt 1,\therefore \lim_{r\rightarrow\infty}\frac{A^ru^{(0)}}{\lambda_1^r}=c_1\eta_1

λ 1 r A r u ( 0 ) = c 1 η 1 + ⋯ + c n ( λ 1 λ n ) r η n ∵ λ 1 λ k < 1 , ∴ r → ∞ lim λ 1 r A r u ( 0 ) = c 1 η 1

u

=

A

r

u

(

0

)

∥

A

r

u

(

0

)

∥

2

,

so

.

A

u

=

A

A

r

u

(

0

)

∥

A

r

u

(

0

)

∥

2

≈

A

r

+

1

c

1

η

1

∥

A

r

u

(

0

)

∥

2

=

λ

1

η

1

u = \frac{A^ru^{(0)}}{\Vert A^ru^{(0)}\Vert_2},\text{ so}\\ . \\ Au=A\frac{A^ru^{(0)}}{\Vert A^ru^{(0)}\Vert_2}\approx \frac{A^{r+1}c_1\eta_1}{\Vert A^ru^{(0)}\Vert_2}=\lambda_1\eta_1

u = ∥ A r u ( 0 ) ∥ 2 A r u ( 0 ) , so . A u = A ∥ A r u ( 0 ) ∥ 2 A r u ( 0 ) ≈ ∥ A r u ( 0 ) ∥ 2 A r + 1 c 1 η 1 = λ 1 η 1

u

=

η

1

u=\eta_1

u = η 1

u

T

A

u

=

λ

1

u^TAu=\lambda_1

u T A u = λ 1

u

u

u

谱正则来自于一个朴素的直觉:最小值处平坦,则泛化能力强。然后,从前馈网络入手,导出以矩阵相乘形式的近似网络函数,最后,对矩阵进行奇异值分析,从矩阵谱的角度说明平坦与奇异值之间的关系,最后,给出一个可行的正则项设计。

参考文献:https://kexue.fm/archives/6051