分类目录:《深入理解深度学习》总目录

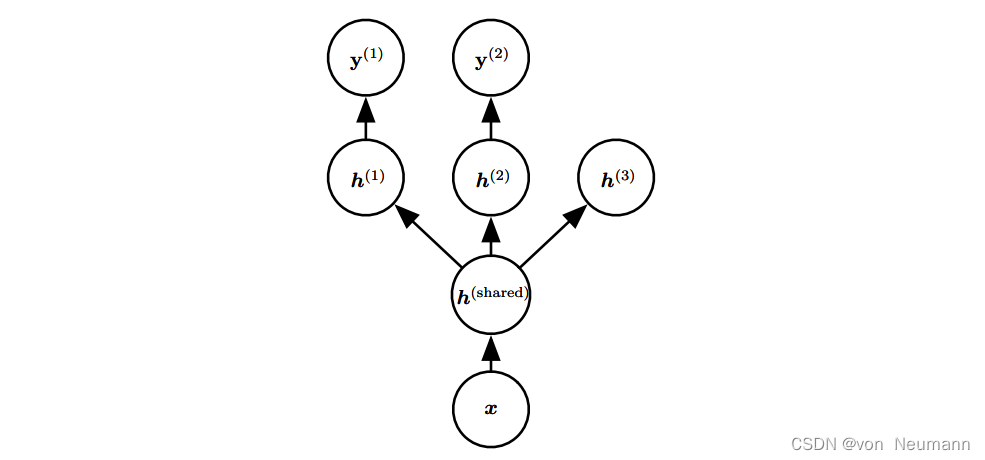

多任务学习是通过合并几个任务中的样例(可以视为对参数施加的软约束)来提高泛化的一种方式。正如额外的训练样本能够将模型参数推向具有更好泛化能力的值一样,当模型的一部分被多个额外的任务共享时,这部分将被约束为良好的值(如果共享合理),通常会带来更好的泛化能力。下图展示了多任务学习中非常普遍的一种形式,其中不同的监督任务(给定 x x x预测 y ( i ) y^{(i)} y(i))共享相同的输入 x x x以及一些中间层表示 h ( s h a r e ) h^{(share)} h(share),能学习共同的因素池。该模型通常可以分为两类相关的参数:

- 具体任务的参数(只能从各自任务的样本中实现良好的泛化)。如下图中的上层。

- 所有任务共享的通用参数(从所有任务的汇集数据中获益)。如下图中的下层。

因为共享参数,其统计强度可大大提高(共享参数的样本数量相对于单任务模式增加的比例),并能改善泛化和泛化误差的范围 。当然,仅当不同的任务之间存在某些统计关系的假设是合理(意味着某些参数能通过不同任务共享)时才会发生这种情况。从深度学习的观点看,底层的先验知识如下:能解释数据变化(在与之相关联的不同任务中观察到)的因素中,某些因素是跨两个或更多任务共享的。

参考文献:

[1] Lecun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015

[2] Aston Zhang, Zack C. Lipton, Mu Li, Alex J. Smola. Dive Into Deep Learning[J]. arXiv preprint arXiv:2106.11342, 2021.