P-R曲线

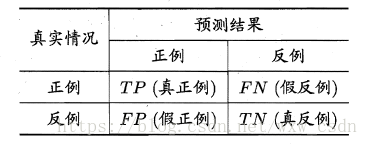

对于二分类问题,可以将训练集的真实类别与机器学习预测的类别划分为真正例(true positive) 、假正例(false positive) 、真反倒(true negative) 、假反例(false negative) 四种情形,令TP 、FP 、TN 、FN 分别表示其对应的样例数,则显然有TP+FP+TN+FN=样例总数。分类结果的“混淆矩阵”如下:

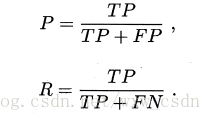

查准率 P 与查全率 R 的定义如下:

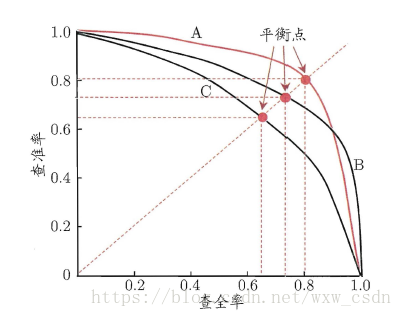

查准率与查全率是一对矛盾的度量,一般来说,查准率高时,查全率较低;查全率高时,查准率偏低,常用查准率 P 作为纵轴,查全率 R 作为横轴的 P-R 曲线来表示两者的变化情况。

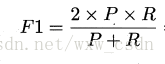

在进行机器学习比较时,可以用平衡点来比较,也可以使用P、R 的调和平均数 F1 来综合度量模型的效果,其公式如下:

ROC曲线

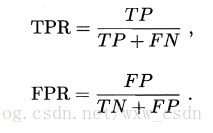

"真正例率" (True Positive Rate,简称TPR) ,"假正例率" (False PositiveRate,简称FPR)的公式如下:

ROC曲线的纵轴是TPR,横轴是FPR。其图像如下:

进行学习器的比较时, 与P-R 图相似, 若一个学习器的 ROC 曲线被另一个学习器的曲线完全"包住", 则可断言后者的性能优于前者;若两个学习器的 ROC 曲线发生交叉,则较难断言两者孰优孰劣。 此时如果一定要进行比较, 则较为合理的判据是比较ROC 曲线下的面积,即AUC (Area UnderROC Curve)。