版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/PerPLexlty/article/details/83386890

很早就对爬虫有所耳闻,于是乎就在网上买了一本python爬虫的书,在学习的过程中也想做一些笔记与大家分享分享,勿喷

1.准备工作

- 环境:python3(本人用的是anaconda ,里面已经集成了很多python需要的库以及依赖的包)

- 运行软件:pycharm

- 浏览器:谷歌

- 爬取方法:正则表达式

2.分析网站

2.1. 猫眼电影top100:http://maoyan.com/board/4

2.2. F12打开控制台,在response中找到需要的页面信息

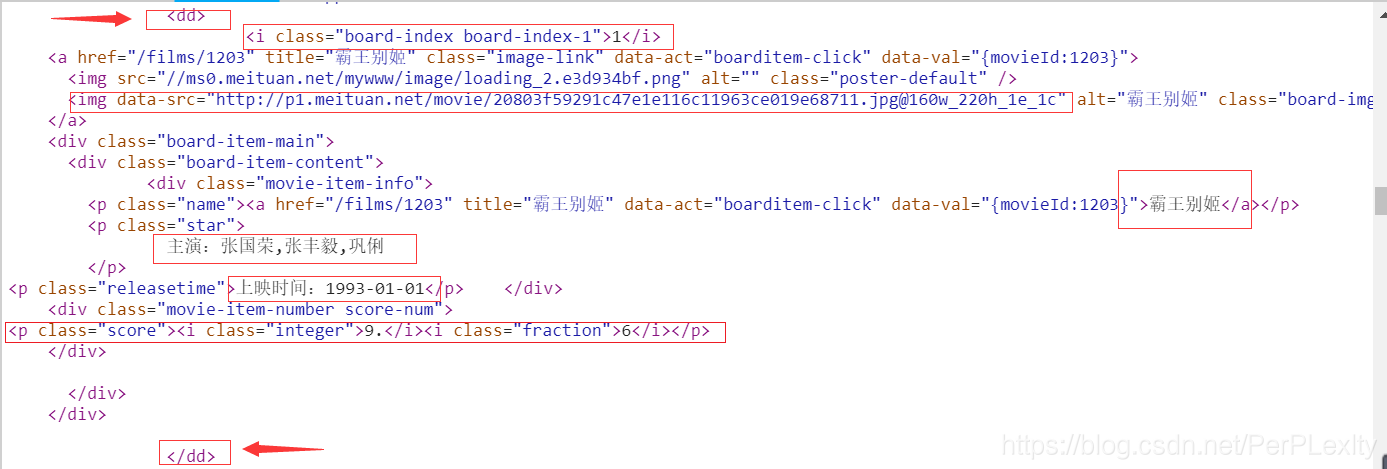

如图

2.3. 发现每一部电影都是一个dd标签,我们需要爬取它的排名、图片地址、电影名称、主演名单、上映时间以及评分。排名信息就在class为board-index的i节点内,使用非贪婪(.*?)来提取i节点内的信息

<dd>.*?board-index.*?>(.*?)</i>

2.4. 接下来就是提取电影图片链接,经过检查第二个img节点的data-src属性是图片链接,正则如下

<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)"

2.5.再往后就是提取电影的名称,它在下面的p节点内,class为name,用name做一个标志位,进一步提取a节点中的正文内容,如下

<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>

2.6.最后提取主演、发布时间、评分都是以此类推

<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>

3.抓取首页排行

- 代码如下

import requests,re

from requests.exceptions import RequestException

#定义一个爬取首页的函数

def get_one_page(url):

#做出异常处理

try:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.92 Safari/537.36'

}

response = requests.get(url, headers=headers)

#在这里做了一个判断,如果响应的状态码是200,说明有内容,返回获取的内容

if response.status_code == 200:

return response.text

return None

except RequestException:

return None

#定义一个提取首页排行信息的函数

def parse_one_page(html):

patten = re.compile(

'<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>',

re.S) #由于页面中有换行,所以在正则匹配的过程中为了避免匹配不到完整的信息,使用re.S匹配到换行

items = re.findall(patten, html)

for item in items: #遍历结果并生成字典

yield {

#自定义标题

'index': item[0],

'image': item[1],

'title': item[2],

'actor': item[3].strip()[3:], #使用strip方法去掉爬取过程中出现的换行,[3:]使用切片去掉"主演:"

'time': item[4].strip()[5:], #[5:]使用切片去掉"上映时间:"

'score': item[5] + item[6]

}

#主函数

def main():

url = 'http://maoyan.com/board/4'

html = get_one_page(url)

for result in parse_one_page(html):

print(result)

main()

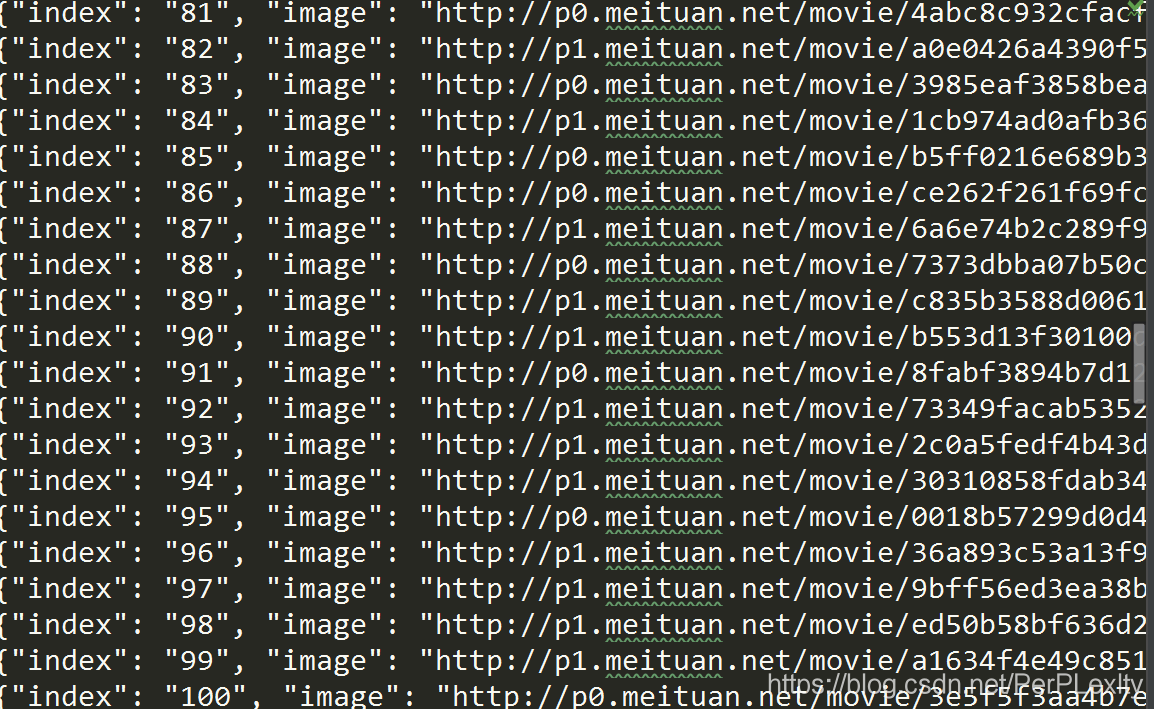

结果

4.分页爬取

4.1.分析

每一页都有十部电影,在换页会发现url的变化,

第二页:http://maoyan.com/board/4?offset=10,

第三页:http://maoyan.com/board/4?offset=20,

很明显是10的倍数

下面我就直接放整个代码了,不啰嗦了

import requests,re,json,time

from requests.exceptions import RequestException

def get_one_page(url):

#做出异常处理

try:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.92 Safari/537.36'

}

response = requests.get(url, headers=headers)

#在这里做了一个判断,如果响应的状态码是200,说明有内容,返回获取的内容

if response.status_code == 200:

return response.text

return None

except RequestException:

return None

def parse_one_page(html):

patten = re.compile(

'<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>.*?releasetime.*?>(.*?)</p>.*?integer.*?>(.*?)</i>.*?fraction.*?>(.*?)</i>.*?</dd>',

re.S) #由于页面中有换行,所以在正则匹配的过程中为了避免匹配不到完整的信息,使用re.S匹配到换行

items = re.findall(patten, html)

for item in items: #遍历结果并生成字典

yield {

'index': item[0],

'image': item[1],

'title': item[2],

'actor': item[3].strip()[3:], #使用strip方法去掉爬取过程中出现的换行,[3:]使用切片去掉"主演:"

'time': item[4].strip()[5:], #[5:]使用切片去掉"上映时间:"

'score': item[5] + item[6]

}

def write_to_file(content):

with open('result.txt','a',encoding='utf-8') as f: #爬取信息写入文本

# print(type(json.dumps(content)))

f.write(json.dumps(content,ensure_ascii=False)+'\n')

def main(offset):

url = 'http://maoyan.com/board/4?offset='+str(offset) #构造一个参数offset

html = get_one_page(url)

for result in parse_one_page(html):

print(result)

write_to_file(result)

if __name__ == '__main__':

for i in range(10):

main(offset=i*10)

time.sleep(1)

结果

至此,猫眼电影Top100信息爬取完毕