RDD是弹性分布式数据集,通常RDD很大,会被分成很多分区,分别保存在不同节点上

分区原则

RDD分区是使分区的个数尽量等于集群中的CPU核心数目

默认分区数

对于不同的Spark部署模式而言(本地模式、Standalone模式、YARN模式、Mesos模式),都可以通过设置spark.default.parallelism这个参数的值来配置默认分区数。

本地模式:默认为本地机器的CPU数目,若设置了local[N],则默认为N

Mesos:默认分区数为8

Standalone/YARN:在“集群中所有CPU核心数目总和”和“2”二者中较大值作为默认值

如何手动设置分区

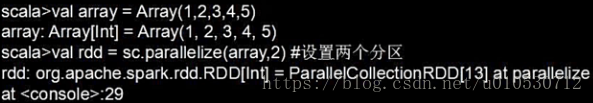

(1)创建RDD时:在调用textFile和parallelize方法时候手动指定分区个数,sc.textFile(path,partionNum)

对于parallelize而言,如果没有在方法中指定分区数,则默认为spark.default.parallelism

对于textFile而言,如果没有在方法中指定分区,则默认为min(defaultParallelism,2),其中defaultParallelism对应的就是spark.default.parallelism

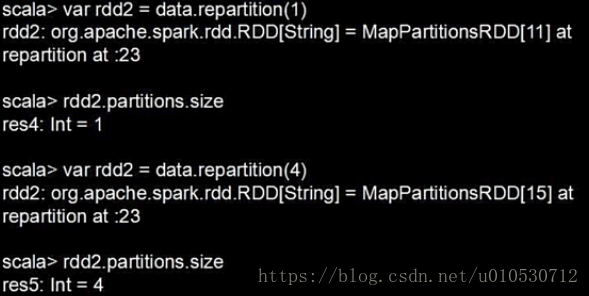

(2)通过转换操作得到新RDD时:直接调用reparation方法

扫描二维码关注公众号,回复:

3532352 查看本文章

如果是从HDFS中读取文件,则分区数为文件分片数(比如,128MB/片)