版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/shouhuxianjian/article/details/67644341

1 -单变量高斯分布

单变量高斯分布概率密度函数定义为:

p(x)=12πσ−−−√exp{−12(x−μσ)2}(1.1)

式中

μ

为随机变量

x

的期望,

σ2

为

x

的方差,

σ

称为标准差:

μ=E(x)=∫∞−∞xp(x)dx(1.2)

σ2=∫∞−∞(x−μ)2p(x)dx(1.3)

可以看出,该概率分布函数,由期望和方差就能完全确定。高斯分布的样本主要都集中在均值附近,且分散程度可以通过标准差来表示,其越大,分散程度也越大,且约有95%的样本落在区间

(μ−2σ,μ+2σ)

2 - 多元高斯分布

多元高斯分布的概率密度函数。多元高斯分布的概率密度函数定义:

p(x)=1(2π)d2|Σ|12exp{−12(x−μ)TΣ−1(x−μ)}(2.1)

其中

x=[x1,x2,...,xd]T

是

d

维的列向量;

μ=[μ1,μ2,...,μd]T

是

d

维均值的列向量;

Σ

是

d×d

维的协方差矩阵;

Σ−1

是

Σ

的逆矩阵;

|Σ|

是

Σ

的行列式;

(x−μ)T

是

(x−μ)

的转置,且

μ=E(x)(2.2)

Σ=E{(x−μ)(x−μ)T}(2.3)

其中

μ,Σ

分别是向量

x

和矩阵

(x−μ)(x−μ)T

的期望,诺

xi

是

x

的第

i

个分量,

μi

是

μ

的第

i

个分量,

σ2ij

是

∑

的第

i,j

个元素。则:

μi=E(xi)=∫∞−∞xip(xi)dxi(2.4)

其中

p(xi)

为边缘分布:

p(xi)=∫∞−∞⋅⋅⋅∫∞−∞p(x)dx1dx2⋅⋅⋅dxd(2.5)

而

σ2ij==E[(xi−μi)(xj−μj)]∫∞−∞∫∞−∞(xi−μi)(xj−μj)p(xi,xj)dxidxj(2.6)

不难证明,协方差矩阵总是对称非负定矩阵,且可表示为:

Σ=⎡⎣⎢⎢⎢⎢σ211σ212⋅⋅⋅σ21dσ212⋅⋅⋅σ21dσ222⋅⋅⋅σ22d⋅⋅⋅σ22d⋅⋅⋅σ2dd⎤⎦⎥⎥⎥⎥

对角线上的元素

σ2ii

为

xi

的方差,非对角线上的元素

σ2ij

为

xi

和

xj

的协方差。

由上面可以看出,均值向量

μ

有

d

个参数,协方差矩阵

∑

因为对称,所以有

d(d+1)/2

个参数,所以多元高斯分布一共由

d+d(d+1)/2

个参数决定。

从多元高斯分布中抽取的样本大部分落在由

μ

和

Σ

所确定的一个区域里,该区域的中心由向量

μ

决定,区域大小由协方差矩阵

Σ

决定。且从式子(2.1)可以看出,当指数项为常数时,密度

p(x)

值不变,因此等密度点是使指数项为常数的点,即满足:

(x−μ)TΣ−1(x−μ)=常数(2.7)

上式的解是一个超椭圆面,且其主轴方向由

∑

的特征向量所决定,主轴的长度与相应的协方差矩阵

Σ

的特征值成正比。

在数理统计中,式子(2.7)所表示的数量:

γ2=(x−μ)TΣ−1(x−μ)

称为

x

到

μ

的Mahalanobis距离的平方。所以等密度点轨迹是

x

到

μ

的Mahalanobis距离为常数的超椭球面。这个超椭球体大小是样本对于均值向量的离散度度量。对应的M式距离为

γ

的超椭球体积为:

V=Vd|Σ|12γd

其中

Vd

是d维单位超球体的体积:

Vd=⎧⎩⎨⎪⎪⎪⎪⎪⎪πd2(d2)!,2dπ(d−12)(d−12)!d!,d为奇数d为偶数

如果多元高斯随机向量

x

的协方差矩阵是对角矩阵,则

x

的分量是相互独立的高斯分布随机变量。

2.1 - 多变量高斯分布中马氏距离的2维表示

上面式2.7是样本点

x

与均值向量

μ

之间的马氏距离。我们首先对

Σ

进行特征分解,即

Σ=UΛUT

,这里

U

是一个正交矩阵,且

UTU=I

,

Λ

是特征值的对角矩阵。且:

Σ−1=U−TΛ−1U−1=UΛ−1UT=∑i=1d1λiuiuTi

这里

ui

是

U

的第

i

列,包含了第

i

个特征向量。因此可以重写成:

(x−μ)TΣ−1(x−μ)===(x−μ)T(∑i=1d1λiuiuTi)(x−μ)∑i=1d1λi(x−μ)TuiuTi(x−μ)∑i=1dy2iλi

这里

yi=uTi(x−μ)

,可以看出,当只选择两个维度时,即可得到椭圆公式 :

y21λ1+y22λ2=1

其中该椭圆的长轴与短轴的方向由特征向量而定,轴的长短由特征值大小而定。

ps:所以得出结论,马氏距离就是欧式距离先通过

μ

中心化,然后基于

U

旋转得到的。

2.2多变量高斯分布的最大似然估计

假设有

N

个iid的高斯分布的样本即

xi

~

N(μ,Σ)

,则该分布的期望和方差(这里是协方差):

μ^=1N∑i=1Nxi=x¯(2.2.1)

Σ^====1N∑i=1N(xi−x¯)(xi−x¯)T1N∑i=1N(xixTi−xix¯T−x¯xTi+x¯x¯T)1N∑i=1N(xixTi)−2x¯x¯T+x¯x¯T1N∑i=1N(xixTi)−x¯x¯T(2.2.2)

为了求得他们的最大似然估计,需要预先知道如下知识:

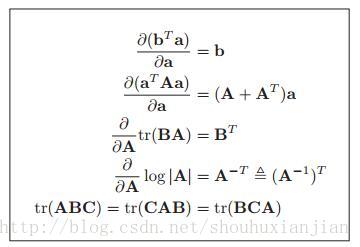

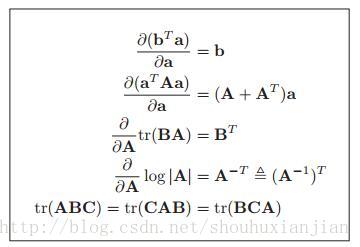

图2.2.1 书mlapp上公式4.10

图2.2.1 书mlapp上公式4.10

xTAx=tr(xTAx)=tr(xxTA)=tr(AxxT)(2.2.3)

因为多元高斯分布可写成:

p(d|μ,Σ)=12πd/2∗|Σ−1|1/2∗exp[−12(x−μ)TΣ−1(x−μ)](2.2.4)

L(μ,Σ)==logp(d|μ,Σ)0+N2log|Λ|−12∑i=1N(xi−μ)TΛ(xi−μ)(2.2.5)

这里

Λ=Σ−1

是协方差矩阵的逆矩阵,也就是精度矩阵。

并假设

yi=xi−μ

,采用链式求导法则,且按照图2.2.1第二个公式,得:

ddμ(12(xi−μ)TΣ−1(xi−μ))===ddyi(yTiΣ−1yi)dyidμ(Σ−1+Σ−T)yi(−1)−(Σ−1+Σ−T)yi

且

Σ

是对称矩阵,所以:

ddμL(μ,Σ)====0+ddμ(−12∑i=1N(xi−μ)TΛ(xi−μ))−12∑i=1N(−(Σ−1+Σ−T)yi)∑i=1NΣ−1yiΣ−1∑i=1N(xi−μ)=0

从而,

多元高斯分布的期望为:

μ^=1N∑Ni=1xi

因为

A1B+A2B=(A1+A2)B

tr(A)+tr(B)=tr(A+B)

所以

tr(A1B)+tr(A2B)=tr[(A1+A2)B]

通过公式2.2.3,且假定

Sμ=∑Ni=1(xi−μ)(xi−μ)T

可知公式2.2.5可表示成:

L(μ,Σ)===logp(d|μ,Σ)0+N2log|Λ|−12∑i=1Ntr[(xi−μ)(xi−μ)TΛ]N2log|Λ|−12tr(SμΛ)(2.2.5)

所以:

dL(μ,Σ)dΛ=N2Λ−T−12STμ=0

Λ−T=Λ−1=Σ=1NSμ

最后得到了

多元高斯分布协方差的期望值为:

Σ^=1N∑Ni=1(xi−μ)(xi−μ)T

2.3 基于多元变量高斯分布的分类方法

1 - 各个类别的协方差都相等

Σck=Σ

:

并且可以直观的知道:

p(X=x|Y=ck,θ)=N(x|μck,Σck)(3.1)

ps:基于第

k

类基础上关于变量

x

的概率,就是先挑选出所有

k

类的样本,然后再计算其多元高斯概率。且如果

Σck

是对角矩阵(即不同特征之间相互独立),则其就等于朴素贝叶斯。

且可知对于多分类问题,给定一个测试样本其特征向量,预测结果为选取概率最大的那个类别:

y^(x)==argmaxckP(Y=ck|X=x)argmaxckP(Y=ck,X=x)P(X=x)(3.2)

因为对于每个类别计算当前测试样本概率时,分母都是相同的,故省略,比较分子大的就行,也就是联合概率大的那个,从而式子3.2等价于:

y^(x)=argmaxckP(X=x|Y=ck)P(Y=ck)

而所谓LDA,就是当每个类别的协方差都相等,即

Σck=Σ

,所以:

P(X=x|Y=ck)=1(2π)d/2|Σ|1/2exp[−12(x−μck)TΣ−1(x−μck)]

P(Y=ck)=πck

从而,可发现:

P(Y=ck|X=x)正比于====πckexp[−12(x−μck)TΣ−1(x−μck)]πckexp[−12xTΣ−1x+12xTΣ−1μck+12μTckΣ−1x−12μTckΣ−1μck]πckexp[−12xTΣ−1x+μTckΣ−1x−12μTckΣ−1μck]exp[μTckΣ−1x−12μTckΣ−1μck+logπck]exp[−12xTΣ−1x]exp[μTckΣ−1x−12μTckΣ−1μck+logπck]exp[12xTΣ−1x]

从而上式的分母又可以省略

假定

γck=−12μTckΣ−1μck+logπck

,而

βck=Σ−1μck

从而:

P(Y=ck|X=x)=exp(βTckx+γck)∑|c|k=1exp(βTckx+γck)=S(η)ck

这里

η=[βTc1x+γc1,βTc2x+γc2,...,βTc|c|x+γc|c|]

,可以发现它就是一个softmax函数,即:

S(η)ck=exp(ηck)∑|c|k=1exp(ηck)

softmax之所以这样命名就是因为它有点像max函数。

对于LDA模型,假设将样本空间划分成n个互相独立的空间,则线性分类面,就是该分类面两边的类别预测概率相等的时候,即:

P(Y=ck|X=x)=P(Y=c′k|X=x)

βTckx+γck=βTc′kx+γc′k

xT(βc′k−βck)=ηc′k−ηck

参考资料:

[] 边肇祺。模式识别 第二版

[] Machine learning A Probabilistic Perspective

[] William.Feller, 概率论及其应用(第1卷)