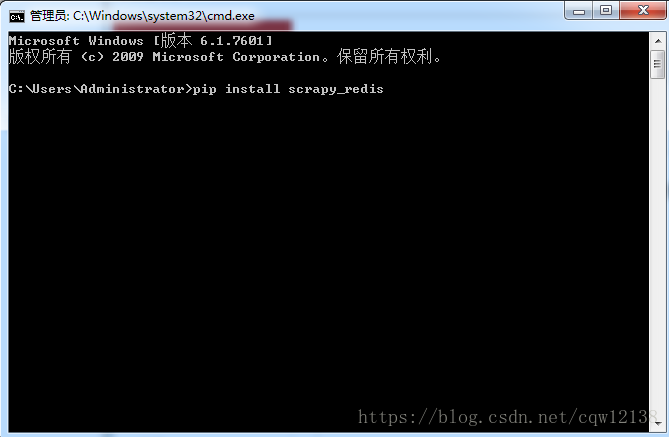

1.在虚拟环境下下载scrapyd工具包后(命令行中输入pip install scrapyd 回车),然后下载scrapy_redis工具包,在命令行中输入pip install scrapy_redis,回车,出现success则视为下载成功!

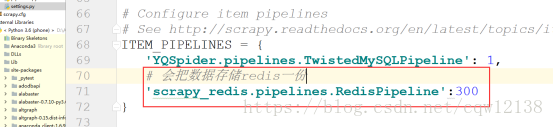

2.使用PyCham 打开项目,找到settings配置文件,来配置scrapy项目使用的调度器和过滤器。

3. 修改项目中的spider文件

主要操作有:引入scrapy_redis中的类;修改继承的类;注释掉start_url;添加redis_key.

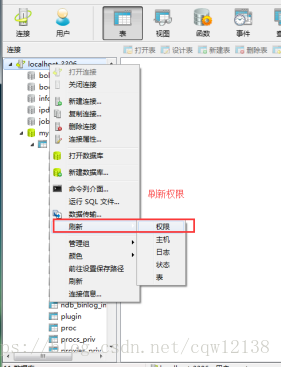

4.如果连接的有远程服务,例如MySQL,Redis等,需要将远程服务连接开启,保证在其他主机上能够成功连接(下图是MySQL的设置方法)

注:一定要记得刷新权限,负责后面会报错!

5.配置远程连的MySQL及redis地址

注: MYSQL-HOST就是你的主机地址

6.

分布式用到的代码应该是同一套代码

1) 先把项目配置为分布式

2) 把项目拷贝到多台服务器中

3) 把所有爬虫项目都跑起来

4) 在主redis-cli中lpush你的网址即可

5) 效果:所有爬虫都开始运行,并且数据还都不一样