新闻特征向量:

和前面一样,显然衡量两个新闻的相似性要根据新闻中的词的相似性。如果两个新闻中出现相同的词较大,相似的可能性就较大。当然这其中的类似于“的”的词应该占据较小权重。这就和我们前面提到的度量关键词和网页相关性问题非常相似。TF-IDF应该是个不错的算法。

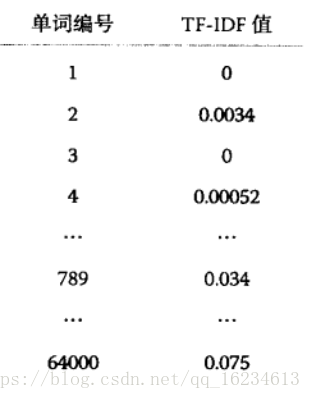

我们应该建立一个字典,然后根据TF-IDF算法对字典中每个词赋予权重,形成如下特征向量,向量中每一项代表这个词对当前文章的贡献度:

显然,如果两篇文章比较相似,那么其包含的特定描述词相同的就比较多。反映在特征向量上就是,如果两篇文章相似性较大,他们的特征向量在某几个维度上都比较大,反之相似性较小,由于使用的特定词不同,则特征向量上较大值的维度也就没有什么交集。

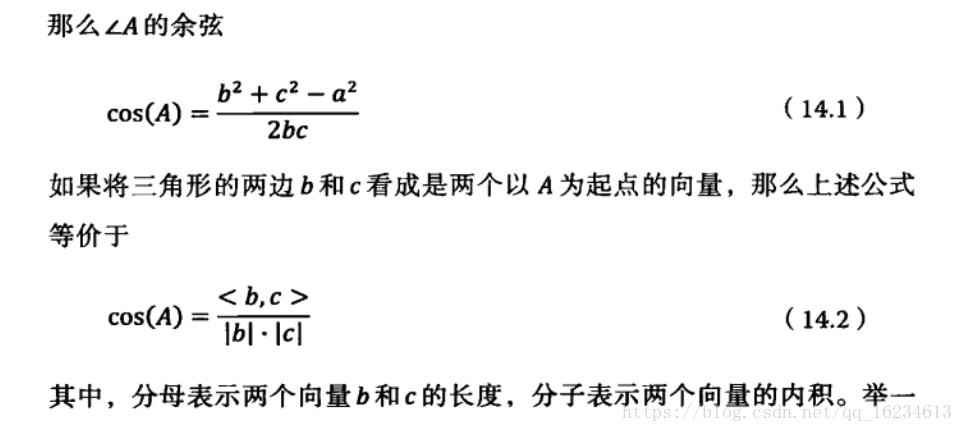

对于不同文章,长度不同,生成的特征维度大小不一。因此单纯比较维度大小没有什么意义,但是使用向量夹角就能很好避免由于数值大小带来的问题。这就用到了几何中的余弦定理。

更多相似性度量,见度量学习。

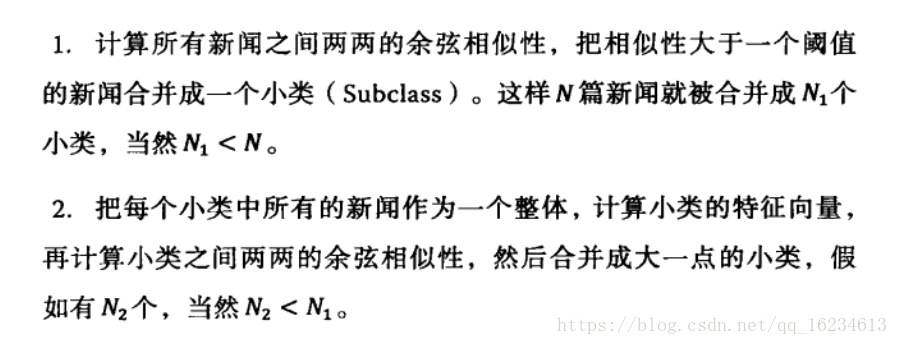

当我们可以使用余弦定理度量两个文本相似性时,接下来需要考虑的就是如何进行分类。一种方法是假设已经知道每个新闻类别的特征向量,那么只需要将预测新闻与各个新闻类别特征向量计算相似度来进行分类。另一方法就是自底向上逐渐聚合的方式,具体思想是:

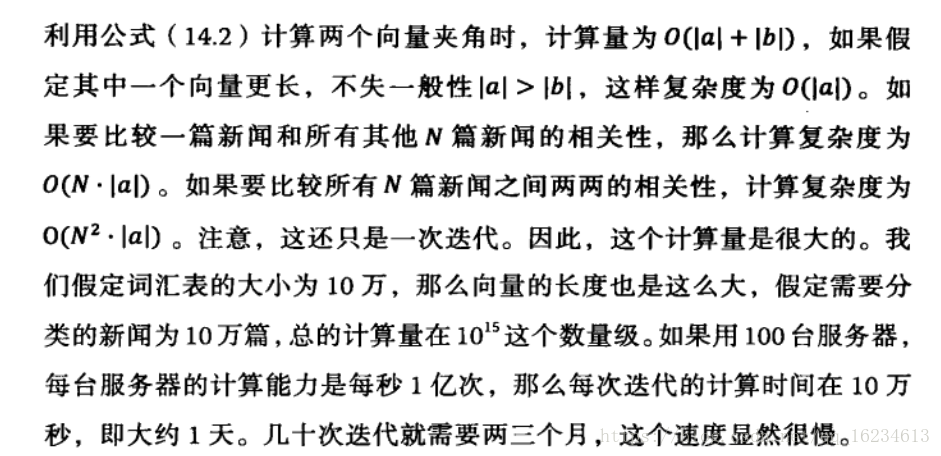

计算余弦向量的技巧:

简化计算可有:

1、分母中向量长度只需计算一次,计算后保存起来,需要使用时拿出来。

2、对于两个向量的内积,只需要考虑两个特征向量中非0元素个数最小值。也就是那个特征向量非0元素个数少,就取这个特征向量中非0元素对应位置元素值计算即可。

3、删除虚词的计算。虚词对于相似的度量并没有意义,而且删除虚词不仅可以增加计算速度,还能提高分类效果。因为虚词的存在其实是一种干扰分类的噪音。

位置加权:

出现在标题和文章首尾的词重要性显然更高。