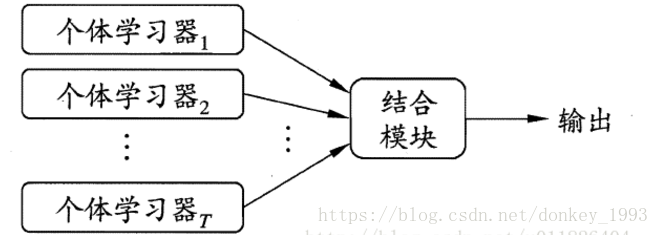

集成学习本质上就是将多个基学习器通过某种结合策略结合在一起然后输出结果。

现在我们介绍一下集成学习的种类:

1. Boosting,采用的是串行工作机制。其中最为经典的就是AdaBoost。AdaBoost采用的是指数损失函数。算法流程是:

- 初始化训练数据的权值分布。如果有N个样本,则每一个训练样本最开始时都被赋予相同的权值:1/N。

- 训练弱分类器。具体训练过程中,如果某个样本点已经被准确地分类,那么在构造下一个训练集中,它的权值就被降低;相反,如果某个样本点没有被准确地分类,那么它的权值就得到提高。然后,权值更新过的样本集被用于训练下一个分类器,整个训练过程如此迭代地进行下去。

- 将各个训练得到的弱分类器组合成强分类器。各个弱分类器的训练过程结束后,加大分类误差率小的弱分类器的权重,使其在最终的分类函数中起着较大的决定作用,而降低分类误差率大的弱分类器的权重,使其在最终的分类函数中起着较小的决定作用。

2.Bagging,采用的是并行工作机制,又放回的采样训练。这是一个对训练集十分敏感的不稳定算法。(神经网络,决策树)。

3.随机森林,bagging算法的拓展,基学习器只能是决策树,通过树来构成森林。又放回的采样添加样本扰动。同时它还引入了一种属性扰动,即在基决策树的训练过程中,在选择划分属性时,RF先从候选属性集中随机挑选出一个包含K个属性的子集,再从这个子集中选择最优划分属性,一般推荐K=log2(d)。

这样随机森林中基学习器的多样性不仅来自样本扰动,还来自属性扰动,从而进一步提升了基学习器之间的差异度。相比决策树的Bagging集成,随机森林的起始性能较差(由于属性扰动,基决策树的准确度有所下降),但随着基学习器数目的增多,随机森林往往会收敛到更低的泛化误差。同时不同于Bagging中决策树从所有属性集中选择最优划分属性,随机森林只在属性集的一个子集中选择划分属性,因此训练效率更高。

4.结合策略

1.平均法(回归问题)

2.投票法(分类问题)

3.学习法