scrap是python的一个快速高层次的爬虫框架,它使用Twisted来处理网络通讯,用于抓取web站点并从页面中提取结构化的数据。

selenium是一套完整的web应用程序测试系统,它包含了测试的录制、编写及运行和测试的并行处理。selenium的核心SelenuimCore基于JsUnit,完全由JavaScript编写,因此可以用于任何支持JavaScript的浏览器上。

selenium可以模拟真实的浏览器,自动化测试工具,支持多种浏览器,爬虫中主要用来解决JavaScript渲染问题。

PhantomJS是一个基于webkit的JavaScript API代码。它是使用QtWebKit作为它的核心浏览器,使用webkit来编译解释执行JavaScript代码。任何你可以在基于webkit浏览器里做的事它都能做到。

假设以上各种环境都配置完成,下面开始爬取淘宝网页信息。

首先新建一个项目和爬虫文件,终端依次输入以下命令

scrapy startproject taobao

cd taobao

scrapy genspider taobaospider taobao.com项目创建完成后首先更改爬虫文件的start_url,将其更改为需要爬取的网页。因为淘宝的网页是动态网页所以我们不能直接用xpath分析页面数据,我们要先用selenium和PhantomJS建立爬虫中间件。找到项目的middlewares.py文件。添加以下代码

from scrapy import signals

from scrapy.http.response.html import HtmlResponse

from selenium import webdriver

class SeleniumSpiderMiddleware(object):

def __init__(self):

self.driver = webdriver.PhantomJS(r'D:/Program Files (x86)/phantomjs-2.1.1-windows/bin/phantomjs.exe')

def process_request(self, request, spider):

"""当引擎从调度器中取出request进行请求发送给下载器之前

会先执行当前的的爬虫中间件,在中间件里面使用selenium

请求这个request,拿到动态网站的数据,然后将请求返回给爬虫对象"""

if spider.name == 'taobaospider':

# 使用爬虫文件的url地址

spider.driver.get(request.url)

for x in range(1, 12, 2):

i = float(x) / 11

js = 'document.body.scrollTop=document.body.scrollHeight * %f' % i

spider.driver.execute_script(js)

# 设置响应信息

# 响应的url为请求的url

# 响应的网页内容为请求网页的源码

# 响应的编码为utf-8

# 请求的信息为获取的请求信息

response = HtmlResponse(

url = request.url,

body=spider.driver.page_source,

encoding='utf-8',

request=request

)

# 只能返回response对象,如果返回了response对象那么可以直接跳过下载中间件

# 将response的值传递给引擎,引擎将值传递给spider进行处理

return response

这里就是我们所写的爬虫中间件,其中

for x in range(1, 12, 2):

i = float(x) / 11

js = 'document.body.scrollTop=document.body.scrollHeight * %f' % i

spider.driver.execute_script(js)是将整个网页分为六等分,每次滑动六分之一。

接下来我们在配置文件中启用中间件,打开settings.py,将以下代码解注释,并更该其中的代码

SPIDER_MIDDLEWARES = {

'taobao.middlewares.TaobaoSpiderMiddleware': 543,

}

DOWNLOADER_MIDDLEWARES = {

'taobao.middlewares.SeleniumSpiderMiddleware': 500,

}这样我们写的中间件就能正常工作了。

接下来到items.py加入以下代码,因为我们要保存title,price两个字段。

class TaobaoItem(scrapy.Item):

title = scrapy.Field()

price = scrapy.Field()接下来到爬虫文件即taobaospider.py加入以下代码来获取我们想要的数据。

import scrapy

from selenium import webdriver

from ..items import TaobaoItem

class TaobaospiderSpider(scrapy.Spider):

name = 'taobaospider'

allowed_domains = ['taobao.com']

start_urls = ['https://s.taobao.com/search?q=%E7%AC%94%E8%AE%B0%E6%9C%AC%E7%94%B5%E8%84%91&imgfile=&commend=all&ssid=s5-e&search_type=item&sourceId=tb.index&spm=a21bo.2017.201856-taobao-item.1&ie=utf8&initiative_id=tbindexz_20170306']

def __init__(self):

self.driver = webdriver.PhantomJS(r'D:/Program Files (x86)/phantomjs-2.1.1-windows/bin/phantomjs.exe')

def parse(self, response):

div_info = response.xpath('//div[@class="info-cont"]')

for div in div_info:

# title = self.dirver.find_element_by_class_name('title-row').text

title = div.xpath('.//div[@class="title-row "]/a/@title').extract_first()

price = div.xpath('.//div[@class="sale-row row"]/div/span[2]/strong/text()').extract_first()

item = TaobaoItem()

item['title'] = title

item['price'] = price

yield item接下来我们将数据保存到sqlite3数据库里。打开pipelines.py 加入以下代码。

import sqlite3

class TaobaoPipeline(object):

def __init__(self):

self.conn = sqlite3.connect('taobaoDb')

self.cursor = self.conn.cursor()

self.cursor.execute('create table if not exists taobaoTable (title text, price text)')

def process_item(self, item, spider):

sql = 'insert into taobaoTable (title, price) values ("{}", "{}")'

self.cursor.execute(sql.format(item['title'], item['price']))

self.conn.commit()

return item

def close_spider(self, spider):

self.cursor.close()

self.conn.close()然后到配置文件里启用管道文件就可以了

ITEM_PIPELINES = {

'taobao.pipelines.TaobaoPipeline': 300,

}最后运行以下命令

scrapy crawl taobaospider我们的爬虫就正常工作了。

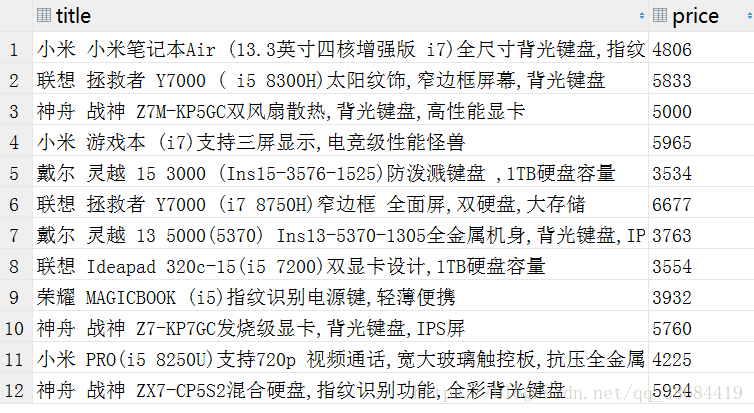

运行结果: