版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/vivizhangyan/article/details/81025305

概率论

条件概率和独立性

(1)条件概率是描述依赖性的,反映了一个事件是否独立

a.依赖性:P(AB)=P(A|B)P(B)

b.独立性:P(AB)-P(A)P(B)

(2)期望值,方差&协方差

a.期望值:变量值和其对应概率的乘积,即目标观测值的平均值

b.方差,衡量数据的离散程度,度量的是单个变量的离散程度

c协方差,两个变量离散程度的大小以及相互之间的趋势(统计相关性)

协方差矩阵可以描述方差,变量之间的趋势相关性。相比之下,相关系数矩阵(将数据做了方差归一化之后协方差矩阵的值)则更能衡量两个变量的相关性。

熵

(1)衡量一个分布的无序程度,无序程度越高,熵越大。熵就是对每个可能性编码需要长度的期望值

(2)定义:

最大似然估计(MLE)

KL散度

衡量相似度

H(P,Q)表示P和Q的交叉熵,用P的分布去Q的分布,KL散度不能作为距离的度量

KL散度表示的是两个分布的差异,所以最小化KL散度等效于MLE

维度

采样和维度的关系

要保持每一维度的采样间隔,则采样点数量会随着维度指数增加,所以在高维进行计算难以实现。中心极限定理用于近似高维样本距离分布

卷积

一维卷积

(1)定义:一个信号倒序之后在不同位置和另一个信号中一段同样大小的部分做点积。

(2)卷积计算和卷积的三种方式

a.valid,卷积核始终处于“信号内”,若卷积核为m,待卷积信号长度为n,则结构长度为n-m+1

b.same,卷积结果和待卷积信号长度一样,需要扩展信号长度,用零填充

c.full,若卷积信号结果为n+m-1,则为full模式

(3)卷积核不用倒序的方式叫做互相关

二维卷积

具体步骤可以参考链接卷积的三种模式

卷积的计算方式

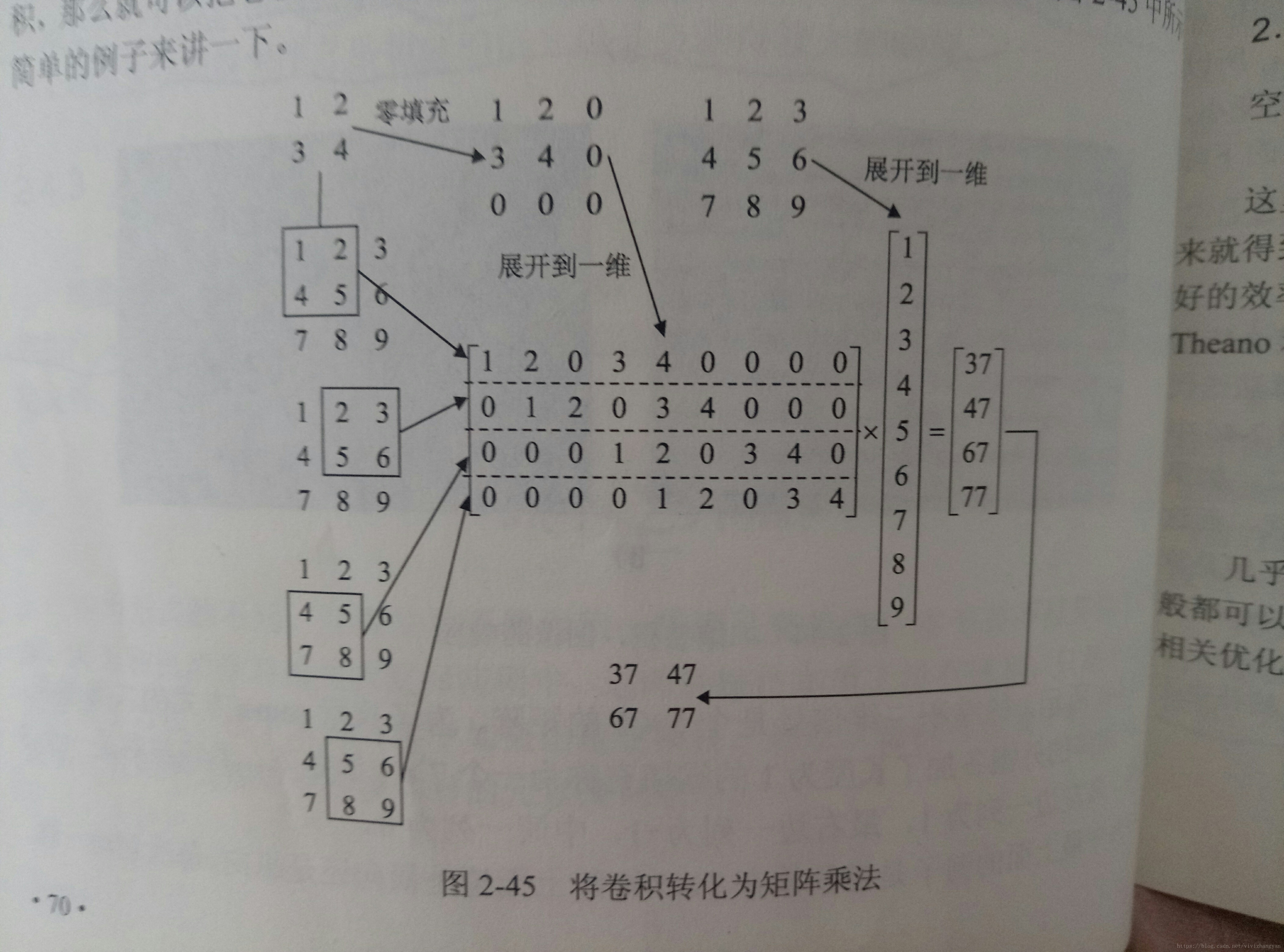

(1)将卷积操作转换为矩阵乘法

将卷积核扩展成和待卷积信号长度一样大的矩阵,待卷积信号展开为一维信号(按列展开),根据卷积核在不同位置可以用零进行填充,然后一行行展开,具体请参照图片1

也可以认为是对卷积核展开后,每次位置移动就是将所有的元素向右移动一个位置。

(2)利用卷积在频域的特性将卷积转换为频域的乘法