1.服务器准备

本案例使用虚拟机服务器来搭建HADOOP集群,所用软件及版本:

Vmware 14.0

Centos 6.7 64bit

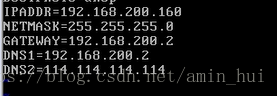

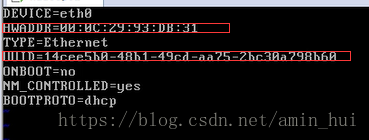

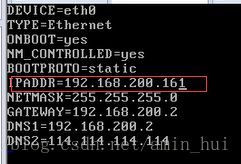

2.配置网卡

终端输入

vi /etc/sysconfig/neywork-scripts/ifcfg-eth0

输入IP地址,子网掩码,网卡,域名服务器

3.测试网卡配置是否正确

重启网络服务 输入

service network restart

输入 ping www.baidu.com 如果能ping通,则网卡配置成功

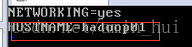

4.修改主机名

输入

vi /etc/sysconfig/network,修改主机名

5.关闭防火墙

service iptables stop仅仅关闭一次

chkconfig iptables off永久关闭

6.安装ssh客户端

执行

yum install -y openssh-clients

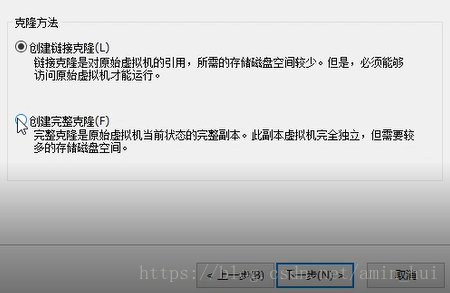

7.克隆服务器

关闭虚拟机,右键 > 管理 > 克隆,选择完整克隆

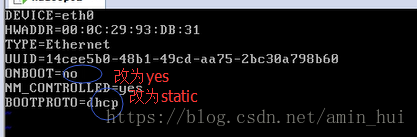

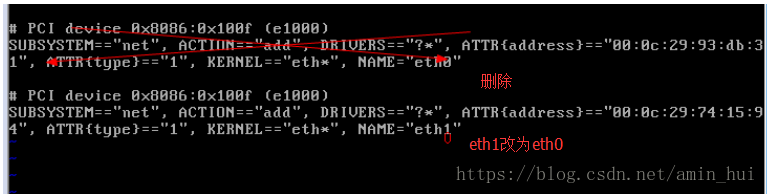

为克隆好的机子配置网卡,执行

vi /etc/udev/rules.d/70-persistent-net.rules

执行vi /etc/sysconfig/neywork-scripts/ifcfg-eth0,修改IP地址即可

执行vi /etc/sysconfig/network,修改主机名为hadoop02

重复上述步骤,建立hadoop03服务器

重启每部机子,使网卡生效

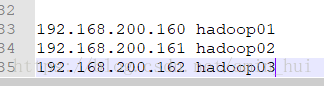

8.hosts映射

执行

vi /etc/hosts,输入以下内容,在Windows的 C:\Windows\System32\drivers\etc\hosts下也输入以下内容

9.ssh链接及免密登录

在hadoop01服务器上输入

ssh hadoop02,测试ssh连接是否成功,

在hadoop01服务器上新建 vi Auto.sh文件,文件中写入免密脚本

脚本连接:https://blog.csdn.net/HANLIPENGHANLIPENG/article/details/52791263

执行脚本即可实现免密登录(只是单项免密)

10.安装JDK

JDK安装包:链接:https://pan.baidu.com/s/1K0yMzOvavOzMLbnnY3Axwg 密码:oyee

1:把JDK安装包上传到linux

2 : 解压文件到安装目录tar -zxvf /root/jdk-8u102-linux-x64.tar.gz -C /usr/local/

3 : 配置环境变量vi /etc/profile,在末尾输入

export PATH=$PATH:$JAVA_HOME/bin```

4 : 执行`source /etc/profile` ,使JDK在当前窗口生效,输入java -version测试是否安装成功

#11.安装hadoop

hadoop安装包:链接:https://pan.baidu.com/s/1v9IBj2h0KPyW4U1BKsZS4Q 密码:y39k

>1 : 上传hadoop安装包

>2 : 解压文件到安装目录 `tar -zxvf /root/hadoop-2.8.3.tar.gz -C /usr/local/`

>3 : 进入hadoop安装目录下,`cd hadoop-2.8.3/etc/hadoop`下开始配置文件

4 : 执行`vi /etc/hadoop/hadoop-env.sh ` JAVA_HOME在哪里

```The java implementation to use.

export JAVA_HOME=/usr/local/jdk1.7.0_51```

export JAVAHOME改为绝对路径

5 : 执行`vi core-site.xml `

<div class="se-preview-section-delimiter"></div>

fs.defaultFS

hdfs://hadoop01:9000

hadoop.tmp.dir

/home/HADOOP/apps/hadoop-2.6.1/tmp

`

6 : vi hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop-2.8.3/data/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop-2.8.3/data/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<value>hadoop01:50090</value>

</property>

</configuration>

<div class="se-preview-section-delimiter"></div>

7 : 执行改名cp mapred-site.xml.tmp* mapred-site.xml

vi mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

<div class="se-preview-section-delimiter"></div>

8 : vi yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

<div class="se-preview-section-delimiter"></div>

9 : vi salves

Hadoop02

Hadoop0310 : 配置环境变量 vi /etc/profile

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/HADOOP/apps/hadoop-2.6.1/tmp</value>

</property>

</configuration>6 : vi hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop-2.8.3/data/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop-2.8.3/data/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<value>hadoop01:50090</value>

</property>

</configuration>7 : 执行改名cp mapred-site.xml.tmp* mapred-site.xml

vi mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>8 : vi yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>9 : vi salves

Hadoop02

Hadoop0310 : 配置环境变量 vi /etc/profile

12.另外两台服务器的JDK和hadoop安装

把第一台安装好的jdk和hadoop以及配置文件发送给另外两台

hosts文件scp -r /etc/hosts/ hadoop02:/etc/

jdk安装后的文件夹scp -r /usr/local/jdk1.8.0_102 hadoop02:/usr/local/

Hadoop安装后的文件夹scp -r /usr/local/hadoop-2.8.3 hadoop02:/usr/local/

/etc/profile 配置文件scp -r /etc/profile hadoop02:/etc/

hadoop03做同样操作

13.启动hadoop集群

初始化HDFS(在hadoop01进行操作)

bin/hadoop namenode -format

启动HDFS

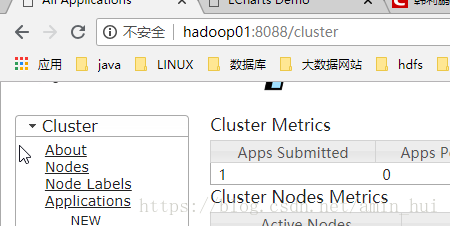

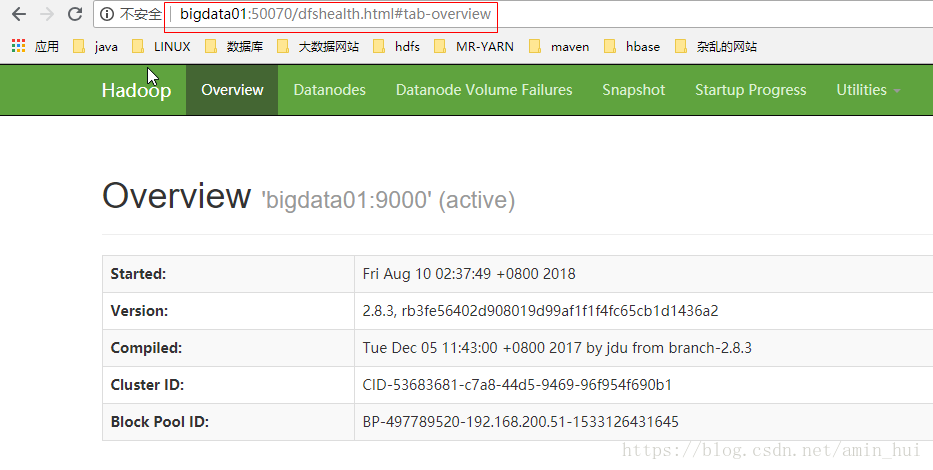

start-dfs.sh在网站中输入hadoop01:50070/ 出现以下网页则为启动成功

启动YARN

start-yarn.sh在网站中输入hadoop01:8088/ 出现以下网页则为启动成功

至此,hadoop集群搭建成功!