hadoop环境搭建

搭建步骤:

1、首先开启虚拟机,如果是第一次使用,需要配置静态ip地址,配置静态ip请看我的另一篇博文:虚拟机配置静态ip

2、hadoop需要jdk的支持,我们需要先安装jdk,安装jdk步骤很简单,下载安装包,解压安装即可,然后配置好jdk的环境变量就ok。linux系统jdk安装教程。

3、我们还要安装zookeeper,它是Hadoop的重要组件。它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等。zookeeper集群搭建教程。

4、安装hadoop(如果是搭建集群,还需要配置免密登录)。

前三步看我另外的几篇博文,有详细安装教程,现在我们主要进行第四步操作。

hadoop集群搭建

单台搭建

1、下载安装包上传到linux

去官网下载hadoop安装包,使用工具导入linux系统,放到安装目录下,解压安装。命令如下:

cd /usr/local/src #进入目录

mkdir hadoop #创建目录

tar -xvf hadoop-2.7.1.tar.gz #解压安装2、编辑hadoop-env.sh

vim etc/hadoop/hadoop-env.sh

#JDK安装目录,虽然系统配置了JAVA_HOME,但有时无法正确识别,最后进行配置

export JAVA_HOME=/usr/local/src/java/jdk1.7.0_51/

#指定hadoop的配置文件目录,不运行hadoop可以不指定

export HADOOP_CONF_DIR=/usr/local/src/hadoop/hadoop-2.7.1/etc/hadoop3、编辑core-site.xml

vim etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.163.129:9000</value>

</property>

<!--注意:用来指定临时存放目录,否则默认的系统的临时目录当重启hadoop时会被删除,影响HDFS下的文件 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/src/hadoop/hadoop-2.7.1/tmp</value>

</property>

<!--执行zookeeper地址-->

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

</configuration>4、编辑hdfs-site.xml

vim etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.rpc-address</name>

<value>hadoop01:9000</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>5、编辑mapred-site.xml

将mapred-site.xml.template复制一份并将名称修改为mapred-site.xml:

cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>6、编辑yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>7、编辑slaves

vim slaves

hadoop01 #将localhost改为hostname名

#如果是集群环境需要将集群里每个作为DataNode存放数据的节点都配置在这里

hadoop02

hadoop038、配置hadoop的环境变量

vim /etc/profile

#set hadoop env

HADOOP_HOME=/usr/local/src/hadoop/hadoop-2.7.1/

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin使配置立即生效

source /etc/profile以上内容为单台hadoop安装,如果搭建集群,只需要在其他节点安装好hadoop,然后将安装配置好的这台上的配置scp过去,然后修改每一个节点上需要修改的配置即可。下面一起来操作一波。

集群搭建

1、scp hadoop01配置文件到hadoop02节点

scp -r hadoop/ root@hadoop02:/usr/local/src/hadoop/hadoop-2.7.1/etc/ #hadoop配置文件2、scp hadoop01环境变量到hadoop02节点

scp -r /etc/profile root@hadoop02:/etc/profile #环境配置文件上面两个步骤每个节点都是相同操作 。

3、格式化文件系统

bin/hdfs namenode -format注意:在主节点格式化即可,出现如下界面,则成功。

4、启动hadoop

sbin/start-dfs.sh #停止服务 stop-dfs.sh需要先启动zookeeper,在启动hadoop,可以执行sbin/start-all.sh启动hadoop,其中就包括hdfs。它会多启动两个YARN服务:nodeManager和ResourceManager。执行jps就应该显示6个服务,就代表启动成功。

启动成功后查看进程:

出现上面这些进程(红色框内是hdfs的进程,QuorumPeerMain是zookeeper的进程),那么恭喜你集群启动成功。

5、测试

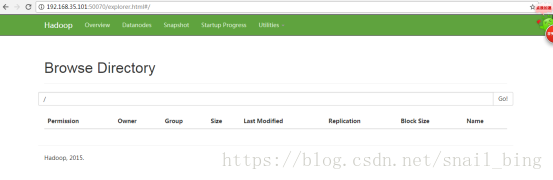

浏览器直接访问:http://192.168.35.101:50070/

创建文件夹上传文件

bin/hdfs dfs -mkdir /user #创建user目录

bin/hdfs dfs -put /home/wang/log /user #上传文件

bin/hdfs dfs -ls / #查看根目录

bin/hdfs dfs -ls /user #列目录浏览器查看

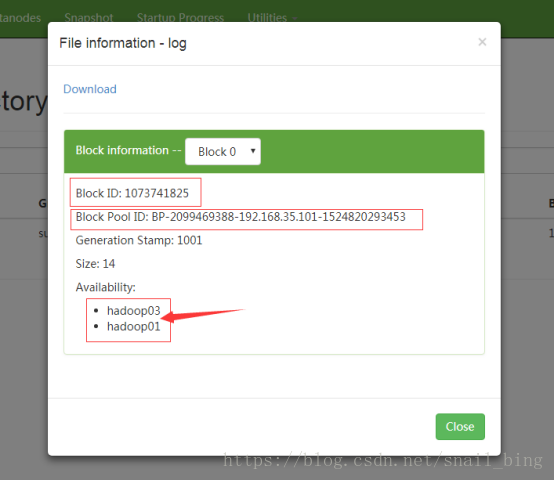

点开log查看

以上就是hadoop集群搭建的全部内容,后续还会更新搭建HAhadoop集群(高可用),如有疑问和建议欢迎留言。

版权所有,转载请说明转载地址。