定义:

首先来了解一下深度学习的定义:深度学习是以数据的原始形态作为算法输入,经过算法层层抽象将原始数据逐层抽象为自身任务所需的最终特征表示,最后以特征到任务目标的映射作为结束,从原始数据到最终任务目标,“一条龙服务” 并无夹杂任何人为操作。普通话说就是“省去了人为的特征工程,实现完全封闭。是一种‘端到端’的学习方式”,而传统机器学习的天花板是由特征工程决定的。

卷积神经网路:是一类特殊的人工神经网络,其最主要的特点是卷积运算操作。可以理解为是一种层次模型,其输入是原始数据,如图像、原始音频数据等。其中,不同类型操作在卷积神经网络中一般称作“层”:卷积操作对应“卷积层”,池化操作对应“池化层”。

准备知识:

- 卷积核:是一个函数,可以看作对某个局部的加权求和;它是对应局部感知,它的原理是在观察某个物体时我们既不能观察每个像素也不能一次观察整体,而是先从局部开始认识,这就对应了卷积。卷积核的大小一般有1x1,3x3和5x5的尺寸。

- 卷积步长:每做一个卷积所移动的距离

- 前馈运算:概括的说就是“预测和推理”,卷积神经网络通过卷积操作、池化操作和激活函数映射等一系列操作的层层堆叠,将高层语义信息逐层由原始数据输入层中抽取出来,逐层抽象,这一过程便是“前馈运算”。

- 反馈运算:“训练和学习”,卷积神经网络的最后一层将其目标任务形式化为目标函数。通过计算预测值与真实值之间的误差或损失(之前的文章讲过的最小二乘法),凭借反向传播算法(BP)将误差或损失由最后一层逐层向前反馈,更新每层参数。

- 池化:其实也就是把特征图像区域的一部分求个均值或者最大值,用来代表这部分区域。如果是求均值就是mean pooling,求最大值就是max pooling。

- 激活函数:是增加整个网络的表达能力(即非线性)。否则, 若干线性操作层的堆叠仍然只能起到线性映射的作用,无法形成复杂的函数。最常用的是sigmoid激活函数和ReLU激活函数 (目前主流是ReLU,因为ReLU避免了梯度饱和效应的发生)

卷积神经网络工作流程:

这次的准备知识点比较多,因为作者,也就是在下,熟悉的领域就是计算机视觉,图像处理,之前做ios的时候,滤镜,红眼,磨皮等等图片处理的功能都是自己写的,研究过GPUIImage的源码,还做过名片识别的app。虽然迫于生计,工作中遇到图像处理的场景少,但是从2011年到现在从来没有停止对图像处理技术的研究,从去年开始做机器学习的时候就选定计算机视觉为主要方向,让自己的长板更长。

好,收,废话一说就停不下来了,下面来介绍一下卷机神经网络的工作流程:

首先介绍一下卷积神经网络的基本部件:

- 卷积操作

- 池化操作

- 激活函数

- 全连接层

- 目标函数

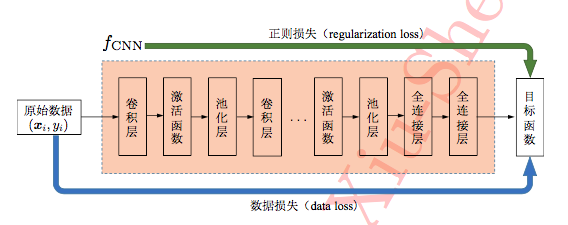

整个卷积神经网络通过这些基本部件的 “有机组合”即可实现将原始数据映射到高层语义、进而得到样本预测标记的功能。用一张图片来展示一下通用的深度模型:

对深度模型而言,其输入数据是未经任何人为加工的原始样 本形式,后续则是堆叠在输入层上的众多操作层。这些操作层整体可看作一个复杂的函数 fcnn,最终损失函数由数据损失和模型参数的正则化损失共同组成,深度模型的训练过程可以简单抽象为从原始数据向最终目标的直接‘拟合’,而中间的这些部件正起到了将原始数据映射为特征随后在映射为样本标记的作用。

卷积操作:

卷积是一种局部操作,通过一定大小的卷积核作用于局部图像区域获 得图像的局部信息。卷积操作中有两个重要的超参数:卷积核大小和卷积步长。

假设输入图像为如图 中右侧的 5 × 5 矩阵,其对应的卷积核为一个 3 × 3 的矩阵。同时,假定卷积操作时每做一次卷积,卷积核移动一个像素位置,即卷积步长 为1。第一次卷积操作从图像 (0, 0) 像素开始,由卷积核中参数与对应位置图像像 素逐位相乘后累加作为一次卷积操作结果,即 1×1+2×0+3×1+6×0+ 7 × 1 + 8 × 0 + 9 × 1 + 8 × 0 + 7 × 1 = 1 + 3 + 7 + 9 + 7 = 27,如图 所示:

类似地,在步长为1时,如上图所示,卷积核按照步长大小在输入图像上从左至右自上而下依次将卷积操作进行下去,最终输出 3 × 3 大小的卷 积特征,同时该结果将作为下一层操作的输入。之后再进行上文讲的‘有机组合’中去,进行反复的前后反馈计算,直到出最后结果。

总结:

本篇介绍了深度学习的关键思想‘端到端’的关键思想,了解了深度学习的工作流程以及卷积操作,基本知识:卷积核,卷积步长,前馈运算,反馈运算,

池化,

激活函数

。下篇文章会讲:池化操作和激活函数。

鸣谢:本文中的图片来源于南京大学计算机系机器学习在读博士魏秀参的开源贡献:http://lamda.nju.edu.cn/weixs 。