之前提到了用urllib使用代理ip的方式,详见:https://blog.csdn.net/zhouchen1998/article/details/81318300

这里使用另外一个框架-requests,其设计哲学为“献给人类”。它继承了urllib的所有特性,底层是urllib3。

不同于urllib是python标准库的内容,他是第三方的,所以需要下载安装(conda或者pip都可以)。安装conda和包的方法见我的博客:https://blog.csdn.net/zhouchen1998/article/details/81382006

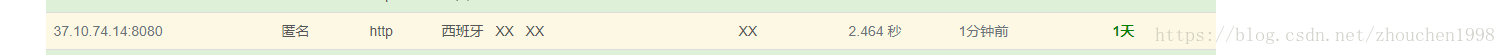

这里我从goubanjia获取了一个代理ip地址。

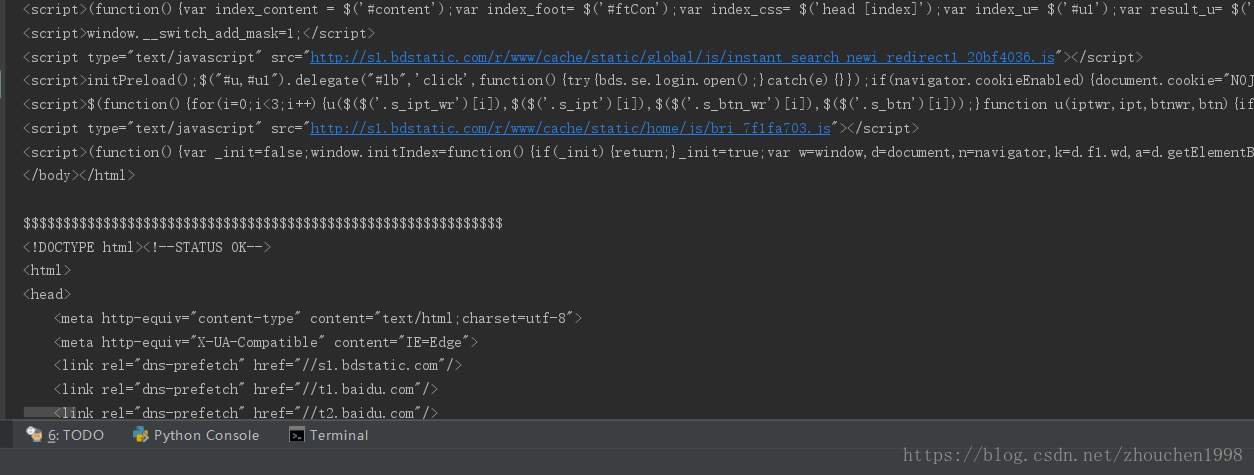

import requests

# 访问的网页

url = "http://www.baidu.com"

# 使用的代理ip地址

proxy = {"http": '37.10.74.14:8080'}

# 使用方法一

rsp = requests.get(url=url, proxies=proxy)

print(rsp.text)

print("$"*60)

# 使用方法二

rsp = requests.request("get", url, proxies=proxy)

print(rsp.text)可以看到运行成功,我获得了我想要的网页数据供后续处理,当然由于使用代理的国外ip访问速度稍慢。