查全率、查准率与F1

| 预测结果 | ||

| 真实结果 | 正例 | 反例 |

| 正例 | True Positive | False Negative |

| 反例 | False Positive | True Negative |

差准率:判断为正例的样本有多少真的为正例

查全率:真的为正例的样本有多少被找出来了

PR曲线

查全率和查准率是相互矛盾的度量。

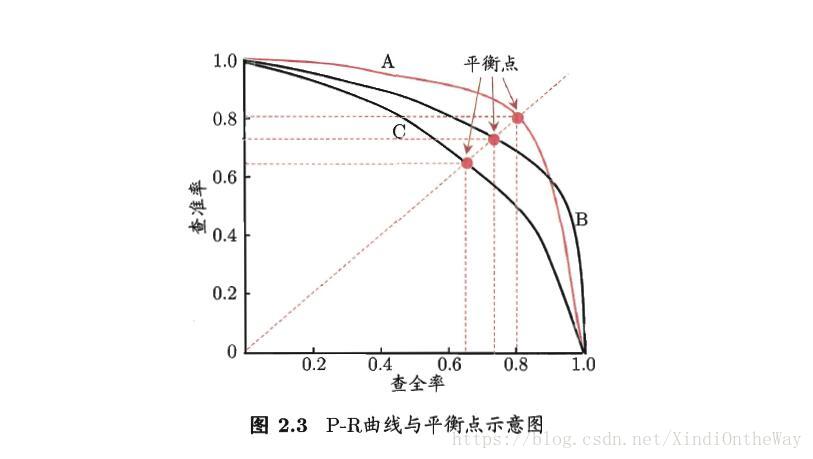

在很多情况下,我们可以根据学习器的预测结果进行排序,排在前面是学习器认为最有可能为正例的样本,排在后面的是最不可能为正例的样本。按此顺序将样本逐个判断为正例,每次计算出当前的查全率和查准率,以查全率为横轴,查准率为纵轴作图,得到P-R曲线:

当一个学习器的P-R曲线完全被另外一个学习器包住时,比如图中B包住了C,则可判断B优于C。还可以利用P-R曲线下的面积判断,但面积一般不容易估算。

也可以用平衡点,即查全率=查准率的值。

更多的用F值,即查全率和查准率的调和平均:

ROC和AUC

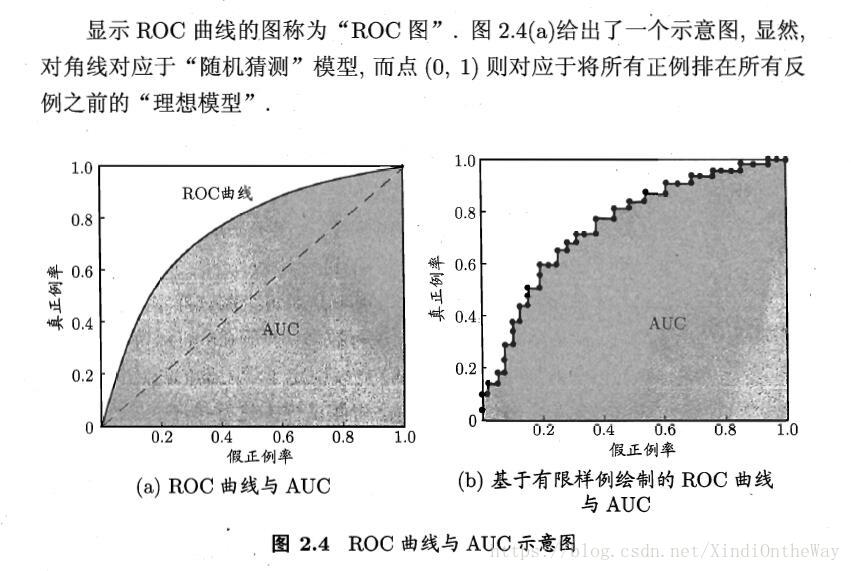

ROC全称是“受试者工作特征”(Receiver Operating Characteristic)。与P-R曲线类似,将样本按预测结果排序,并逐个把样本作为正例预测,以TPR(True Positive Rate)为纵轴,FPR(False Positive Rate)为横轴:

ROC曲线下的面积称为AUC(Area Under ROC Curve)。

参考资料

机器学习 周志华