多项式回归

概念:与选择特征的想法密切相关的一个概念被称为多项式回归。

在课程中还是用的房价预测的例子,假设函数中本来有两个特征:x1:房屋的宽度,x2:房屋的深度(即长宽),这时候创造一个新的特征房屋面积x:宽度与深度的乘积,然后对这个新的特征x选择合适的模型拟合。

二次模型size很大时price将会下降不太符合现实,选用三次模型,这里要注意的是这样做的话,特征的归一化就很重要,使它们的值的范围变得具有可比性。但同样的用平方根函数依然ok(),模型的选择是活的。

如果自变量只有一个时,称为一元多项式回归;如果自变量有多个时,称为多元多项式回归。多项式回归的最大优点就是可以通过增加x的高次项对实测点进行逼近,直至满意为止。

标准方程法

一种求θ的解析解法,与之前使用迭代算法相比,可以一次性求解θ的最优值。

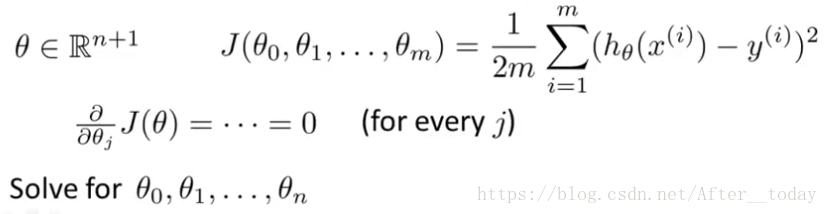

θ在这里指向量,m是特征向量的维度,n是特征向量的个数,所以代价函数中θ下标应该是从0到n(有错请指正),对每个参数θ求代价函数J的偏导数,然后把它们全部置0,求出θ0……θn的值,就能得到能够最小化函数J的θ值

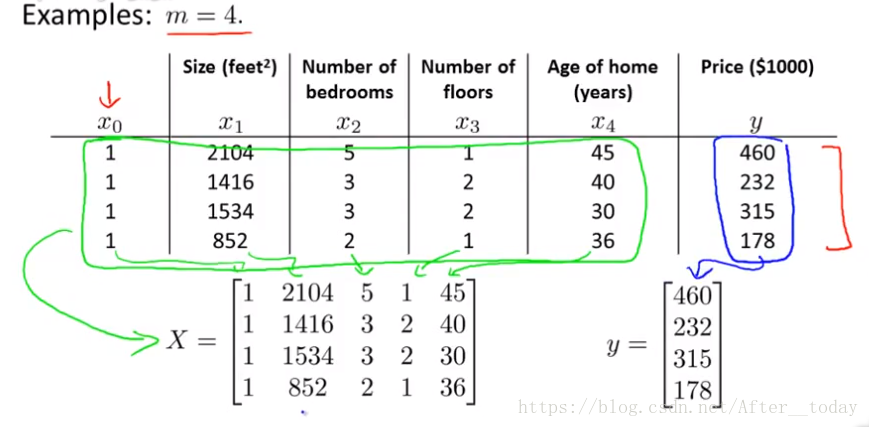

如下例子:维度为4,特征数为4(这里矩阵X前面补全1向量x0是因为在假设函数中有个常数项θ0)

这种情况下时,代价函数J最小,这个是怎么推导的呢?

首先,可以根据这个求出

,但是我们知道这是x是矩阵,而只有方阵才可以求逆,所以现在式子的两边同时乘个

构成方阵,即

,然后就得到了

这个公式。

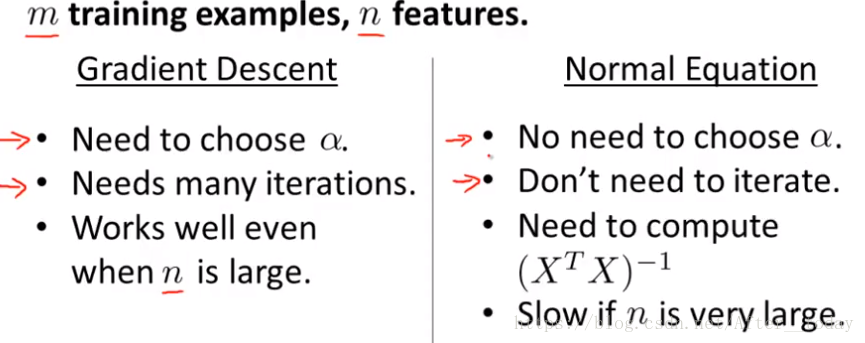

梯度下降法和标准方程法的比较:

在线性回归模型中,特征向量的数目不大的情况下,标准方程法是一个很好的计算θ的替代方法,特征向量的数量达到一万左右,求转置和逆运算的计算量很大,速度会很慢,开始考虑使用梯度下降法或者后面讲到的其他算法。

ps:回归问题貌似在这一节结束了,后面开始讲分类问题了