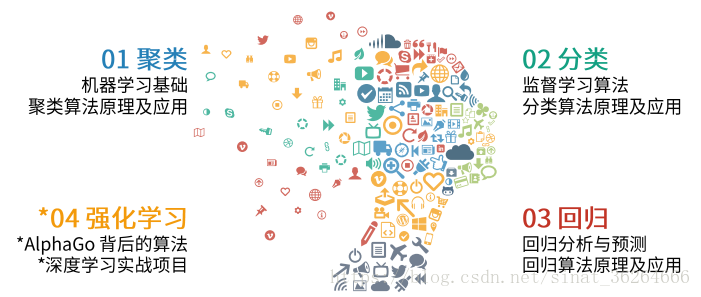

根据面临的不同问题,机器学习可以分为如下几类:

- 聚类问题

- 分类问题

- 回归问题

- 强化学习

=====================分割线===============

1.聚类问题 (无监督学习)

- 聚类算法属于非监督式学习,通常被用于探索性的分析,是根据“物以类聚”的原理,将本身没有类别的样本聚集成不同的组,这样的一组数据对象的集合叫做簇,并且对每一个这样的簇进行描述的过程。

- 它的目的是使得属于同一簇的样本之间应该彼此相似,而不同簇的样本应该足够不相似。主要是根据数据样本上抽取的特征,挖掘数据的关联模式。

- 常见的典型应用场景有用户挖掘、客户细分、客户研究、市场细分、价值评估、新闻聚类等。 MLlib 目前支持广泛使用的 KMmeans 聚类算法。

=================分割线=================

2.分类问题(监督学习)

- 分类算法属于监督式学习,使用类标签已知的样本建立一个分类函数或分类模型,应用分类模型,能把数据库中的类标签未知的数据进行归类。主要是根据数据样本上抽取出的特征,判定属于有限个类别中的哪一个。

- 分类在数据挖掘中是一项重要的任务,目前在商业上应用最多,常见的典型应用场景有垃圾邮件识别、图像内容识别、流失预测、精确营销、客户获取、个性偏好等。 MLlib 目前支持分类算法有:逻辑回归、支持向量机、朴素贝叶斯和决策树。

==================分割线=================

3.回归问题(监督学习)

回归算法属于监督式学习,每个个体都有一个与之相关联的实数标签,并且我们希望在给出用于表示这些实体的数值特征后,所预测出的标签值可以尽可能接近实际值。主要是根据数据样本上抽取出的特征,预测连续值结果。 MLlib 目前支持回归算法有:线性回归、岭回归、 Lasso 和决策树。

=================分割线============

4.强化学习

- 主要是研究如何基于环境而行动,以取得最大化的预期利益。可以这么理解,举个栗子,在没有老师提示的情况下,自己对预测的结果进行评估的方法。通过这样的自我评估,学生为了获得老师的最高价将而不断的进行学习。

- 最终目标:使计算机获得对没学习过的问题也可以做出正确解答的泛化能力。

- 与监督学习不同的是,强化学习没有正确输出的引导,也就是没有正确的答案;与无监督学习不同的是,强化学习需要对获取到的信息进行自我评估。强化学习被认为使人类主要的学习模式之一。

- 应用:机器人的自动控制、计算机游戏中的人工智能、市场战略的最优化等。

======================分割线===============

5.监督学习与无监督学习

根据上面,我们可以了解机器学习中还可以分为监督学习与无监督,那么什么是监督学习与无监督学习呢。

监督学习

- 定义:指有求知欲的学生从老师那里获取知识、信息,老师提供对错指示、告知最终答案的学习过程。 在机器学习中,计算机 = 学生,周围的环境 = 老师。

- 最终目标:根据在学习过程中获得的经验技能,对没学习过的问题也可以做出正确解答,使计算机获得这种泛化能力。

- 应用:手写文字识别、声音处理、图像处理、垃圾邮件分类与拦截、网页检索、基因诊断、股票预测等。

- 典型任务:预测数值型数据的回归、预测分类标签的分类、预测顺序的排列 。

- 我的理解:计算机在正确输出的不断更正和指引下,不断提高自己分析和解决问题的正确性。也就是说在监督学习中,我们的训练样本中要有正确的结果供我们参考。

无监督学习

- 定义:指在没有老师的情况下,学生自学的过程。 在机器学习中,计算机从互联网中自动收集信息,并获取有用信息。

- 最终目标:无监督学习不局限于解决有正确答案的问题,所以目标可以不必十分明确。

- 应用:人造卫星故障诊断、视频分析、社交网站解析、声音信号解析、数据可视化、监督学习的前处理工具等。

- 典型任务:聚类、异常检测。

- 我的理解:计算机从网络中获取有用的信息。

=======================分割线========================

6.基本术语概念

- 模型:模型也称为学习器,可看作学习算法在给定数据集和参数空间的实例化,泛指从数据中学到的结果。

- 数据集:一组记录的集合。

(色泽:青绿; 根蒂:蜷缩; 敲声:浊响)

(色泽:乌黑; 根蒂:稍蜷; 敲声:沉闷)

(色泽:浅白; 根蒂:硬挺; 敲声:清脆)

- 示例/样例/样本:数据集中的每个记录称之为样本或者示例。例如上面一条数据集中的一条数据。

- 属性/特征:对象的某方便表现或特征。例如“色泽” , “根蒂”等。

- 属性值:属性上的取值。例如“青绿”等

- 属性空间/样本空间/输入空间:样本属性张成的空间称为属性空间(样本空间、输入空间),每个样本对应空间中的一个点,故而一个示例也称为一个“特征向量”。如:把“色泽”, “根蒂”, “敲声”作为3个坐标轴,则他们一起张成一个用于描述西瓜的三维空间,每个西瓜都可在这个空间找到自己的坐标位置。

- 特征向量:空间中每个点对应的一个坐标向量。

xi=(xi1, xi2, xi3, ... xin)表示n维样本空间中的一个向量。

- 学习/训练:从数据中学得模型的过程称为“学习”或“训练”,这个过程通过执行某个学习算法来完成。

- 训练数据/训练集:训练过程中使用的数据称为训练数据,训练样本组成的集合称为训练集。学得的模型对应了关于数据的某种潜在的规律,因此称为“假设”。这种潜在规律自身,则是称为真相或真实,学习过程就是为了找出或逼近真相。训练集通常是样本空间中很小的一个采样。

- 训练样本:数据集中的一个样本。

- 假设:学得模型对应了关于数据的某种潜在规律。

- 真相:真正存在的潜在规律。学习过程是为了找出或逼近真相。

- 标记:关于示例结果的信息,如((色泽=青绿,根蒂=蜷缩,敲声=浊响),好瓜),其中”好瓜“称为标记。

- 分类:若要预测的是离散值,如”好瓜“,”坏瓜“,此类学习任务称为分类。

- 回归:若要预测的是连续值,如西瓜的成熟度为0.95,0.37,此类学习任务称为回归。

- 测试:学得模型后,使用其进行预测的过程。

- 测试样本:被预测的样本。

- 聚类:将训练集中的数据分成若干组,每组称为一个”簇“。

- 监督学习:训练集有标记信息,学习方式有分类和回归。

- 无监督学习:训练集没有标记信息,学习方式有聚类。

- 泛化能力:学得模型适用于新样本的能力。一般来说,训练样本越大,越有可能通过学习来获得具有强泛化能力的模型。

- 无监督逐层训练是多隐层网络训练的有效手段。其基本思想是每次训练一层隐节点,训练时将上一层隐节点的输出作为输入,而本层隐节点的输出作为下一层阴界点的输入,在预训练全部完成后,再对整个网络进行微调。

- 概念学习:概念学习(归纳学习)的目标就是泛化,即是通过对训练集中的训练样本进行学习以获得对测试集进行判断的能力。

- 归纳偏好:机器学习算法在学习过程中对某种类型假设的偏好我们称之为“归纳偏好”,简称“偏好”。归纳偏好对应了学习算法本身所作出的关于什么样的模型更好的假设,在具体的现实问题中,这个假设是否成立,即算法的归纳偏好是否与问题本身匹配,大多数时候直接决定了算法能否取得好的性能。

===================分割线======================

参考文献:

===================END======================