转自知乎:深度学习领域有哪些瓶颈? - PENG Bo的回答 - 知乎 https://www.zhihu.com/question/40577663/answer/413331053

作者:PENG Bo

链接:https://www.zhihu.com/question/40577663/answer/413331053

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

个人认为,当前深度学习的瓶颈,可能在于 scaling。是的,你没有听错。

我们已经有海量的数据,海量的算力,但我们却难以训练大型的深度网络模型(GB 到 TB 级别的模型),因为 BP 难以大规模并行化。数据并行不够,用模型并行后加速比就会大打折扣。即使在加入诸多改进后,训练过程对带宽的要求仍然太高。

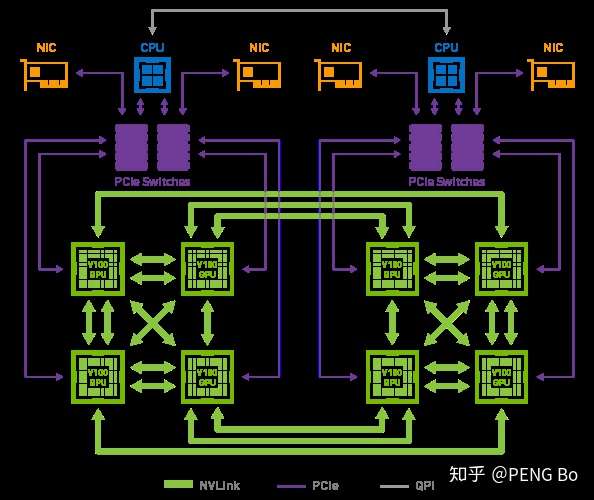

这就是为什么 nVidia 的 DGX-2 只有 16 块 V100,但就是要卖到 250 万。因为虽然用少得多的钱就可以凑出相同的总算力,但很难搭出能高效运用如此多张显卡的机器。

而且 DGX-2 内部的 GPU 也没有完全互联:

又例如 AlphaGo Zero 的训练,实际用于训练的只是很少的 TPU。即使有几千几万张 TPU,也并没有办法将他们高效地用于训练网络。

如果什么时候深度学习可以无脑堆机器就能不断提高训练速度(就像挖矿可以堆矿机),从而可以用超大规模的多任务网络,学会 PB EB 级别的各类数据,那么所能实现的效果很可能会是令人惊讶的。

那么我们看现在的带宽:

List of interface bit ratesen.wikipedia.org

2011年出了PCI-E 3.0 x16,是 15.75 GB/s,现在消费级电脑还是这水平,4.0还是没出来,不过可能是因为大家没动力(游戏对带宽要求没那么高)。

NVLink 2.0是 150 GB/s,对于大型并行化还是完全不够的。

大家可能会说,带宽会慢慢提上来的。

很好,那么,这就来到了最奇怪的问题,我想这个问题值得思考:

AI芯片花了这么大力气还是带宽受限,那么人脑为何没有受限于带宽?

我的想法是:

- 人脑的并行化做得太好了,因此神经元之间只需要kB级的带宽。值得AI芯片和算法研究者学习。

- 人脑的学习方法比BP粗糙得多,所以才能这样大规模并行化。

- 人脑的学习方法是去中心化的,个人认为,更接近 energy-based 的方法。

- 人脑的其它特点,用现在的迁移学习+多任务学习+持续学习已经可以模仿。

- 人脑还会用语言辅助思考。如果没有语言,人脑也很难快速学会复杂的事情

remark:最后对人脑学习的总结值得学习!