目前正在学习使用TensorFlow,看到TensorFlow官方API上有一个调用layer层来搭建卷积神经网络(CNN)的例子,和我们之前调用的nn层的搭建卷积神经网络稍微有点不同。感觉layer层封装性更强,直接输入参数就可以是实现。

TensorFlow官方API: TensorFlow官方API

参考博客地址:Tensorflow and CNNs 使用tensorflow构建卷积神经网络 ,这篇博客是翻译的官方API。

代码如下:

#-*- coding: UTF-8 -*-

import numpy as np

import tensorflow as tf

tf.logging.set_verbosity(tf.logging.INFO)

def cnn_model(features,labels,mode):

#输入层:

input_layer = tf.reshape(features["x"], [-1, 28, 28, 1])

#第一层卷积:

conv1 = tf.layers.conv2d(inputs=input_layer, #输入的张量

filters=32, #卷积核(过滤器)的数量

kernel_size=[5, 5], #卷积核的size

padding='same', #是否加padding,same和valid

activation=tf.nn.relu) #激活函数

#第一层池化:

pool1 = tf.layers.max_pooling2d(inputs=conv1, #输入的张量

pool_size=[2, 2], #池化层过滤器的size

strides=2) #池化的步长

#第二层卷积:

conv2 = tf.layers.conv2d(inputs=pool1,

filters=64,

kernel_size=[5,5],

padding='same',

activation=tf.nn.relu)

#第二层池化:

pool2 = tf.layers.max_pooling2d(inputs=conv2,

pool_size=[2,2],

strides=2)

#扁平化pool2:

pool2_flat = tf.reshape(pool2, [-1, 7 * 7 * 64])

#全连接层:

dense = tf.layers.dense(inputs=pool2_flat,

units=1024, #神经元的个数

activation=tf.nn.relu) #激活函数

dropout = tf.layers.dropout(inputs=dense, #为了改进模型,在全连接层使用dropout正则化

rate=0.4, #这里设置为0.4,表示每个神经元都有0.4的概率会在训练的过程中被舍弃.

training=mode == tf.estimator.ModeKeys.TRAIN) #采用布尔值来指定模型当前是否在训练模式下运行,只有在训练模式下,才会进行dropout

#回归层/输出层

logist = tf.layers.dense(inputs=dropout,

units=10,)

#tf.argmax(input=logist,axis=1) #输出预测的值

#tf.nn.softmax(logist,name="softmax_tensor") #属于每个类别的概率

#预测:

prediction = {

"classes":tf.argmax(input=logist, axis=1), #预测的类别(预测的值,比如值为7)

"probabilities":tf.nn.softmax(logist,name="softmax_tensor") #预测的概率,比如值为7的概率

}

if mode == tf.estimator.ModeKeys.PREDICT:

return tf.estimator.EstimatorSpec(mode=mode,predictions=prediction)

#损失函数:

onehot_labels = tf.one_hot(indices=tf.cast(labels, tf.int32), depth=10) #对lable进行 one_hot编码

loss = tf.losses.sparse_softmax_cross_entropy(labels=labels, logits=logist)

#loss = tf.losses.sparse_softmax_cross_entropy(labels=onehot_labels, logits=logist)

#训练模型

if mode == tf.estimator.ModeKeys.TRAIN:

optimizer = tf.train.GradientDescentOptimizer(learning_rate=0.001)

train_op = optimizer.minimize(loss=loss,

global_step=tf.train.get_global_step())

return tf.estimator.EstimatorSpec(mode=mode, loss=loss, train_op=train_op)

#评估

eval_metric_ops = {

"accuarcy:": tf.metrics.accuracy(labels=labels,

predictions=prediction["classes"])

}

return tf.estimator.EstimatorSpec(mode=mode,

loss=loss,

eval_metric_ops=eval_metric_ops)

def main():

#加载数据:

mnist = tf.contrib.learn.datasets.load_dataset("mnist")

train_data = mnist.train.images

train_labels = np.asarray(mnist.train.labels,dtype=np.int32)

eval_data = mnist.test.images

eval_labels = np.asarray(mnist.test.labels, dtype=np.int32)

#评价模型/保存模型

#model_fn:指定用于训练、评估和预测的模型函数;我们将之前创建的cnn_model作为参数

#model_dir:指定用于保存模型数据(检查点)的目录(这里,我们指定临时目录G:\PythonCode\DLself\\temp\mnist_convnet_model,

# 但可以随意更改为您选择的另一个目录)。

mnist_classifier = tf.estimator.Estimator(model_fn=cnn_model,

model_dir="G:\PythonCode\DLself\\temp\mnist_convnet_model")

#记录日志:

tensor_to_log = {"probabilities": "softmax_tensor"}

logging_hook = tf.train.LoggingTensorHook(

tensors=tensor_to_log, every_n_iter=50)

#训练模型:

train_input_fun = tf.estimator.inputs.numpy_input_fn(

x={"x":train_data},

y=train_labels,

batch_size=100, #每次训练100张图片

num_epochs=None, #模型将一直训练,直到达到指定的步数

shuffle=True #每次训练前打乱数据

)

mnist_classifier.train(input_fn=train_input_fun,

steps=20000, #训练20000次

hooks=[logging_hook])

eval_input_fun = tf.estimator.inputs.numpy_input_fn(

x={"x":eval_data},

y=eval_labels,

num_epochs=1,

shuffle=False

)

eval_results = mnist_classifier.evaluate(input_fn=eval_input_fun)

print(eval_results)

if __name__ == "__main__":

main()

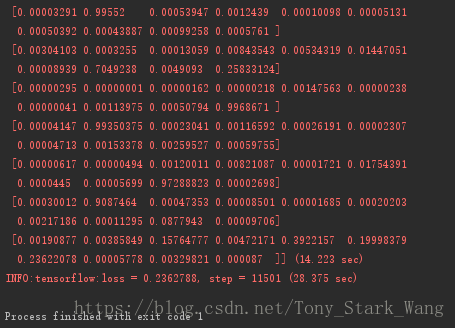

tf.app.run()代码运行结果如下:

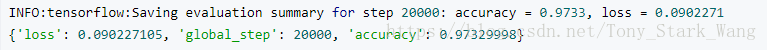

因为训练CNN是非常耗时的,因为笔记本性能和时间关系我没有运行完程序。但是根据官方API的说法:测试数据集已经达到了97.3%的准确率。

参考博客中的程序运行结果: