系列目录:

神经网络通俗讲,麻瓜变大神(一)-初识神经网络

神经网络通俗讲,麻瓜变大神(二)-解释非线性

神经网络通俗讲,麻瓜变大神(三)-卷积神经网络

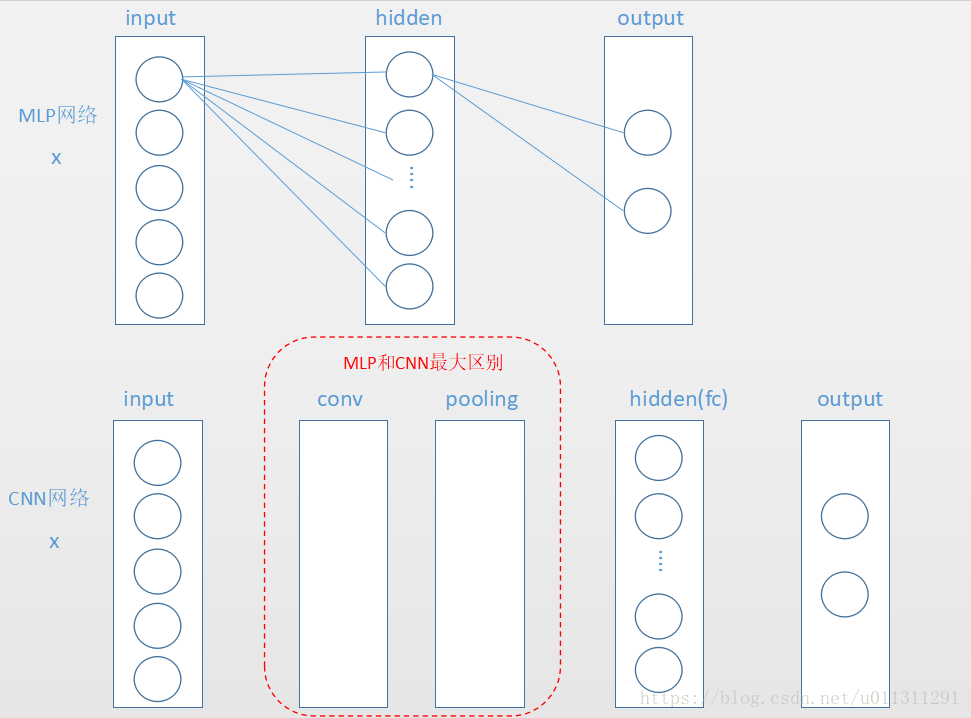

其实CNN(网络)很简单,先上图:

可以看到,MLP和CNN之间的差别其实就是CNN多了一层CONV(卷积层)和一层POOLING(池化层)。

那么这两层有什么作用呢?

其实卷积池化完全可以是看作网络自动帮你提取特征的过程,那么如何理解这个特征提取呢?

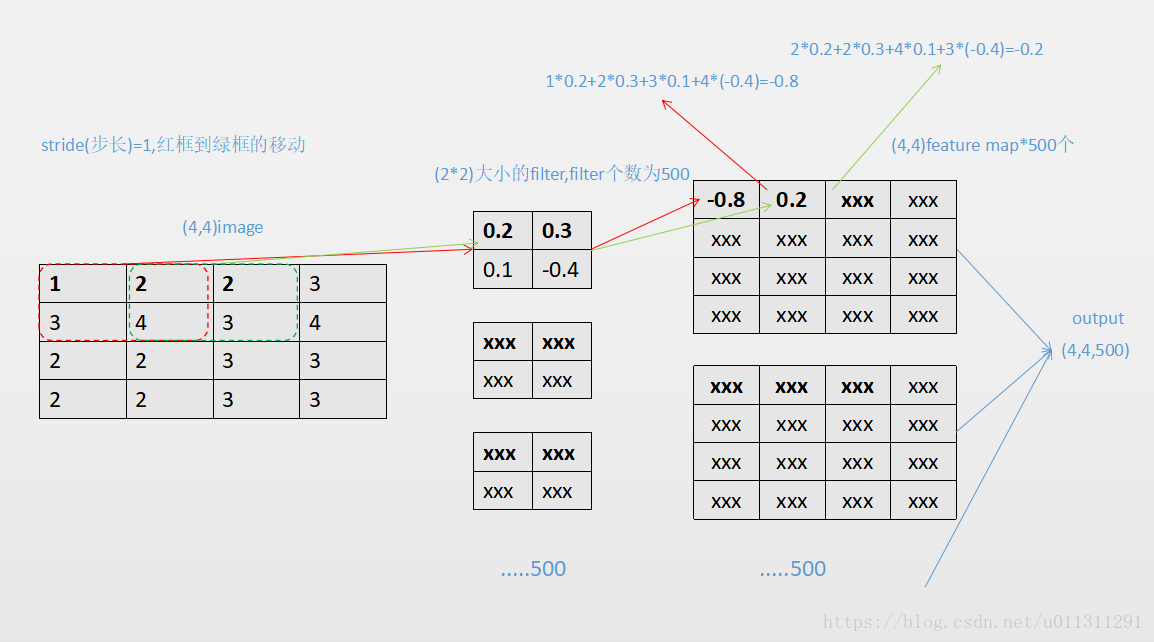

CONV卷积的计算,其实很简单:

有几个元素:

1.filter,可以理解为对一张图像提取特征的助手,这里为(2*2)大小,500个filter助手,然后每一次fliter和

2.stride=1,可以理解为filter在(4*4)image上滑动步伐的大小,这样一步一步的滑动,就像落叶一卷而过,所以才叫卷积神经网络

3.featrue map(特征图),即每一次filter和image上的框进行计算,都会计算出一个值,然后这个值就是featrue map上的一个点,这里每个filter计算完后都得到(4*4)大小的特征图,

这里的特征图总共有500个,可以理解为对原始图像image,提取出了500张不同的特征图。

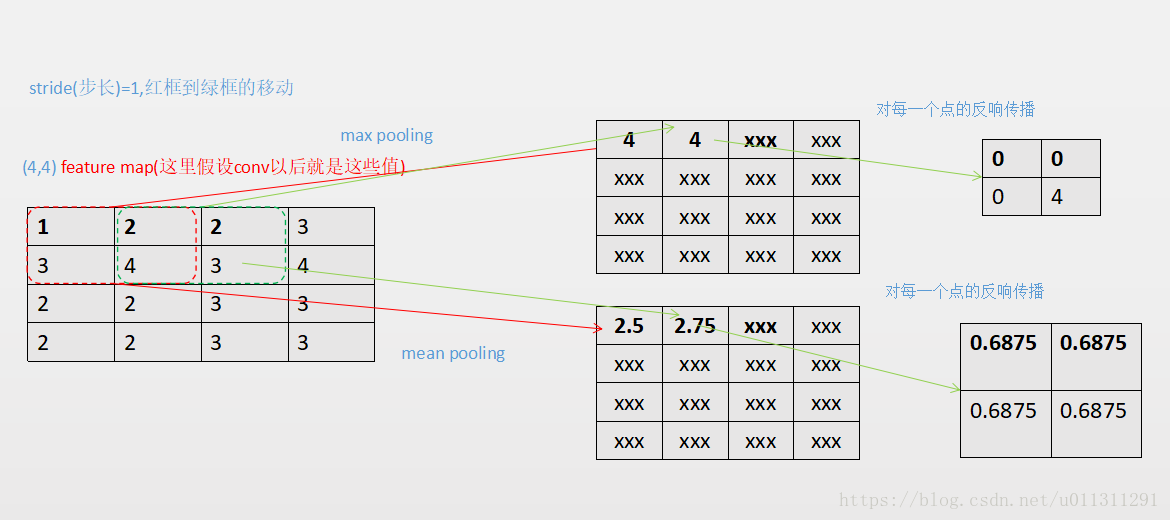

POOLING的计算,比conv更简单,可以看作是对特征图进行压缩的过程:

有几个元素

1.bins,相当于conv中没有w权重的filter,只是一个框。

2.stride=1,步长

3.有Max pooling,mean pooling两种

4.如何反响传播

Max pooling 之前最大值的位置保留,其它全为0

mean pooling 平均到每一个点

这里可以看看原始图像和经过卷积以后图像对比,keras 模型参数,模型保存,中间结果输出