损失函数

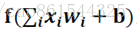

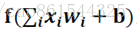

神经元模型:用数学公式表示为:

神经网络:是以神经元为基本单元构成的。

激活函数:引入非线性激活因素,提高模型的表达力。

常用的激活函数有relu、sigmoid、tanh等。

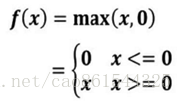

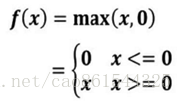

① 激活函数relu: 在Tensorflow中,用tf.nn.relu()表示

relu()数学表达式 relu()数学图形

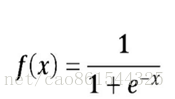

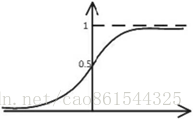

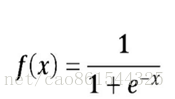

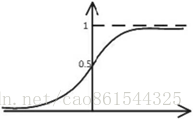

② 激活函数sigmoid:在Tensorflow中,用tf.nn.sigmoid()表示

sigmoid ()数学表达式 sigmoid()数学图形

神经元模型:用数学公式表示为:

神经网络:是以神经元为基本单元构成的。

激活函数:引入非线性激活因素,提高模型的表达力。

常用的激活函数有relu、sigmoid、tanh等。

① 激活函数relu: 在Tensorflow中,用tf.nn.relu()表示

relu()数学表达式 relu()数学图形

② 激活函数sigmoid:在Tensorflow中,用tf.nn.sigmoid()表示

sigmoid ()数学表达式 sigmoid()数学图形