第四周

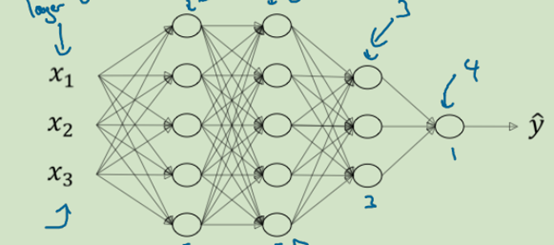

4.1深度神经网络符号约定

L=4______(神经网络层数)

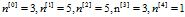

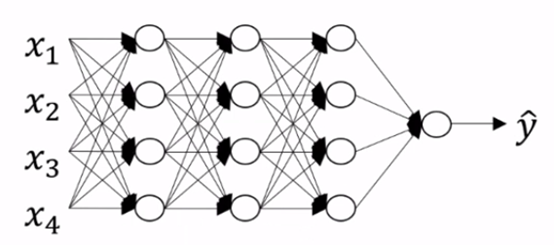

4.2 校正矩阵的维数

校正要点: ,

, ,

,

dZ,dA,dW,db都与它们被导数(Z,A,W,b)的维数相同

4.3 为什么使用深层表示

按神经网络的概念(仿人脑):有浅层的简单识别出一些特征,然后再通过深层的组合,最终,整个网络实现一个复杂的问题

按电路来说:一个巨大的计算问题,分几路出去(特征,隐藏层),最后在慢慢整合,节约计算成本

吴推荐思路:从logistic回归开始建立,然后,由1层隐藏层,2层,慢慢尝试,找出一个适合的结构,将隐藏层作为超参数调整。不要一上来就要什么10+隐藏层怼

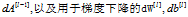

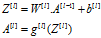

4.4 反向传播

反向传播:输入  ,

,

输出

注意:

计算 是,那个*,代表対应为元素相乘,不累加

是,那个*,代表対应为元素相乘,不累加

是根据成本函数来决定出来的

是根据成本函数来决定出来的

这样看,实际上反向传播的算法公式也很简单,很固定。需要计算的也就是

-

每一层激活函数的

的导数,如果选用relu函数,更简单了,导数=1。当然,要记住在Z=0时是没有导数的,需要自定义一下。Z为负数的时候,你可以选择maximum(0.01Z,Z)这样倒是就是0.01了, 通常是规避出现负数。激活函数设的简单,或许那些研究深度学习算法的大佬,微积分要补下课

的导数,如果选用relu函数,更简单了,导数=1。当然,要记住在Z=0时是没有导数的,需要自定义一下。Z为负数的时候,你可以选择maximum(0.01Z,Z)这样倒是就是0.01了, 通常是规避出现负数。激活函数设的简单,或许那些研究深度学习算法的大佬,微积分要补下课

-

另一个需要计算的就是

了,看成本函数取什么

了,看成本函数取什么

4.5 参数VS 超参数

超参数可以控制参数的输出结果。超参数的最优值是不断尝试,找出来的。但最优值会随着时间发生变化。造成这些原因有可能是你训练的数据增加了,CPU/GPU算例增加了,你训练的数据发送了变化。最优值只是这个时间段的最优值,并不是永恒的最优值。