前言

目前人工智能和大数据火热,使用的场景也越来越广,日常开发中前端同学也逐渐接触了更多与大数据相关的开发需求。因此对大数据知识也有必要进行一些学习理解

基础概念

大数据的本质

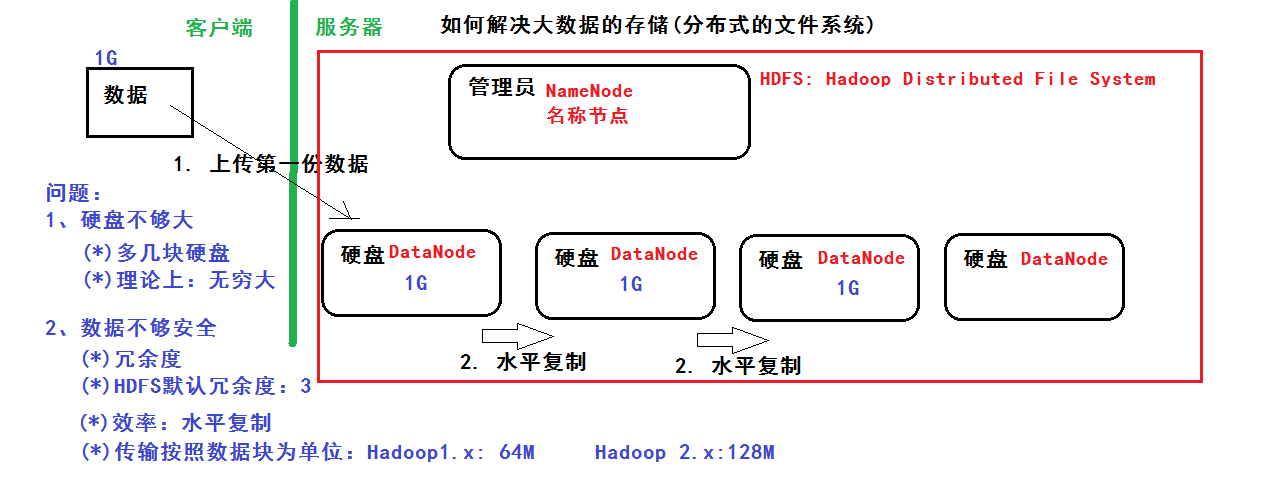

一、数据的存储:分布式文件系统(分布式存储)

二、数据的计算:分部署计算

基础知识

学习大数据需要具备Java知识基础及Linux知识基础

学习路线

(1)Java基础和Linux基础

(2)Hadoop的学习:体系结构、原理、编程

第一阶段:HDFS、MapReduce、HBase(NoSQL数据库)

第二阶段:数据分析引擎 -> Hive、Pig

数据采集引擎 -> Sqoop、Flume第三阶段:HUE:Web管理工具

ZooKeeper:实现Hadoop的HA

Oozie:工作流引擎(3)Spark的学习

第一阶段:Scala编程语言

第二阶段:Spark Core -> 基于内存、数据的计算

第三阶段:Spark SQL -> 类似于mysql 的sql语句

第四阶段:Spark Streaming ->进行流式计算:比如:自来水厂(4)Apache Storm 类似:Spark Streaming ->进行流式计算

NoSQL:Redis基于内存的数据库

HDFS

分布式文件系统 解决以下问题:

1、硬盘不够大:多几块硬盘,理论上可以无限大

2、数据不够安全:冗余度,hdfs默认冗余为3 ,用水平复制提高效率,传输按照数据库为单位:Hadoop1.x 64M,Hadoop2.x 128M

管理员:NameNode 硬盘:DataNode

MapReduce