Abstract:提取函数aquisition function,熵,

一、贝叶斯优化的适用条件

不知道函数的具体形态即表达式

但是如果给定一个x,可以计算y。这里的计算方法可以使用之前的GPR,如果(x,y)够多了,那么就基本知道函数图像的走势了。

二、目的

找出函数的最值,这是最主要的目的。因为很多时候数据科学的一大部分问题都是做非线性函数f(x)的在范围A内的优化,或者简单的说,求最大值/最小值。

大致知道函数长什么样子

三、思路

1.因为GP可以得到在一个新的点x的后验概率P(f(x)|x,D),这里的D为数据集,所以如果想求得极值,可以从GP计算出的x点的均值和方差考虑。可以根据该后验概率的一些指标确定下一个我应该取哪一个点,才有较大的概率尽快的达到极值。

2.如何选取下一个点:求提取函数u达到极值对应的x。这就是上一条的所谓指标。

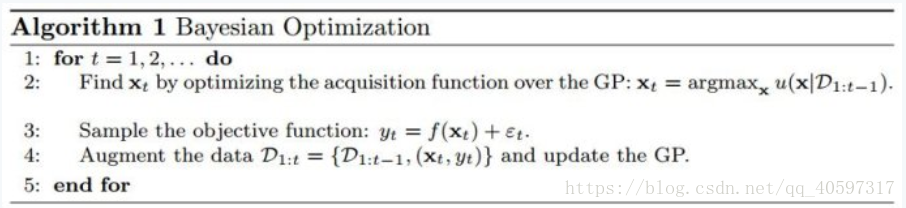

3.基本算法

可以看出,这里就是不断的求max(AF)对应的点Xt,计算Xt的Yt,即取样,加到数据集。周而复始的循环。

原谅我写的X,Y都是大写,否则x和t一样大了,强迫症发作

4.Xt的选取

5.优化方向

explore 探索未知的空间,尽可能的探索未知的空间,这样对f(x)的后验概率才会更接近f(x)

exploit exploit,强化已有的结果,在现有最大值的附近进行探索,保证找到的f(x)会更大

6.常用的AF

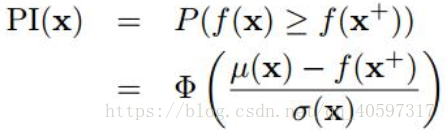

6.1 probability of improvement(POI)

目的:新的采样能提升最大值的概率最大

表达式为:MPI(maximum probability of improvement),或P算法

Φ(·) 表示的是正态累计分布函数

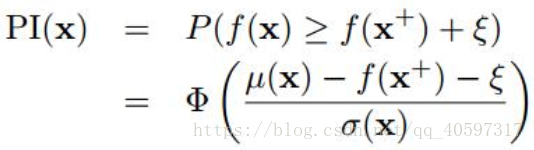

改进:这里的参数为trade-off系数,可以控制倾向explore还是exploit

这里倾向于局部搜索

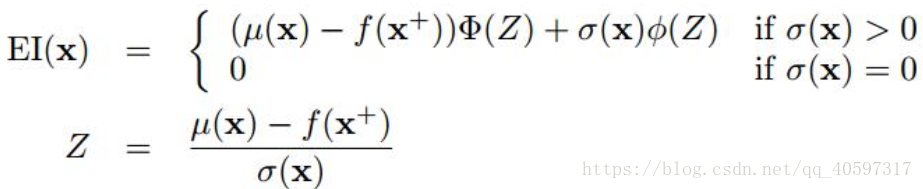

6.2 Expected improvement(EI)

可以在explore和explot之间平衡,explore时选择均值大的点,exploit选择方差大的点

参数通常选0.01

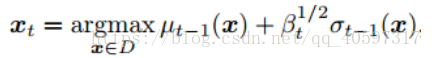

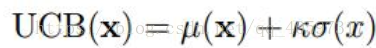

6.3 Upper confidence bound

直接比较置信区间的最大值,效果非常好

参考:http://blog.sina.com.cn/s/blog_76d02ce90102xqs6.html