Recursive Deep Models for Semantic Compositionality Over a Sentiment Treebank

递归的深度模型在情感语料库的语义组合上的应用

本文主要提出了一个递归神经张量网络(Recursive Neural Tensor Network)模型,为了在情感语料库(Sentiment Treebank,包含着从11,855个句子解析树中的215,154个细粒度情感标签词语。给情感组合的标注带来了新挑战)上标注情感,训练出了这个模型,它的表现比之前的模型有了提高,它把单句的正/负分类从80%提高到85.4%,预测所有句子的细粒度情感标签准确率提高到80.7%,这是唯一可以准确捕捉负面影响和各种正负面句子的树层次的范围 的模型。

1.Introduction

单个词的语义向量空间广泛被用作特征,因为它不能很好表示长句子的意义,所以语义向量空间的组合性最近得到广泛关注。然而,进展因为缺乏大量已经有标签的组合性的模型资源,为了解决这个需求,我们介绍Stanford Sentiment Treebank 和 Recursive Neural Tensor Network ,这个Recursive神经张量网络可以准确预测 新的语料库的组合性的语义的影响。

Stanford Sentiment Treebank是首个有全部标注的解析树的语料库,可以对 语言中的情感的组合性的影响 提供完整的分析。这个语料库是基于2005年Pang和Lee的数据集的工作,包括11855个从影评中找的单句 。该数据集可以用来在训练 监督性机器学习的组合性模型,虽然数据集有文档级标签,但是仍然需要更好地从短评中获取正面或负面情感。为了减小粒度,我们推荐Recursive Neural Tensor Network (RNTN),RNTN把任意长度的短语作为输入,把短语表示成词向量和解析树,然后用相同的张量组合函数计算高层节点的向量,对比其他一些模型,RNTN有最好的表现:预测细粒度的所有节点的正负情感达到80.7%准确率。

完整的训练和测试代码,demo和Stanford Sentiment Treebank 数据集在http://nlp.stanford.edu/sentiment

2.Related Work

工作涉及5个不同的NLP领域的研究,在有限的空间下,每个都涉及大量相关工作,很难裁决优劣。

语义向量空间(Semantic Vector Spaces)

语义向量空间的主要是利用了单个词汇的分布相似性,通常, 一个单词 和 这个单词的语境 一起统计上出现 ,是用来描述每个单词的方法。 然而分布向量不能相似的内容中很好的捕捉它们不同的反义词,补救的方法是使用神经单词向量。这篇论文里的模型可以用纯粹的监督字代表典型学习完全新的语料库。

向量空间中的组合(Compositionality in Vector Spaces)

大多数的组合规则和相关数据集是两个单词的组合。

逻辑形式(Logical Form)

相关的工作是解决从不同的角度将句子映射到逻辑形式的组合。

深度学习(Deep Learning)

除了提到的上述相关RNNs的工作,一些相关于神经网络的组合想法也被讨论。提出了相关的输入通过三路相互作用参数化的张量来进行相关的分类。

情感分析(Sentiment Analysis)

除了以上提到的工作,情感分析的方法大都使用词语标示袋。

3.Stanford Sentiment Treebank

词袋分类能很好的工作在较长的文档依靠几个少数的强烈情感单词,如可怕的,兴奋的。然而,情感的精确度甚至是一个单句正负二分类的问题很多年来都没有超过80%。

分为五类(5-class classification):negative、somewhat negative,neutral,positive or somewhat positive

4.Recursive Neural Models

本节的模型计算代表短语的组合向量的可变长度和句法类型。这些代表分类词语的特征。

4.1 RNN:Recursive Neural Network

递归神经网络中最简单的成员,它父节点是由已计算好的孩子节点决定的

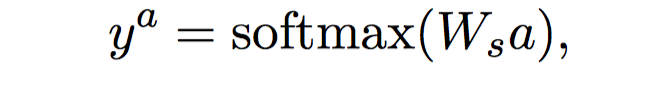

父节点的P计算表达式如下:

4.2 MV-RNN:Matrix-Vector RNN

其主要思想是将解析树中每个单词和较长短语表示为向量和矩阵。

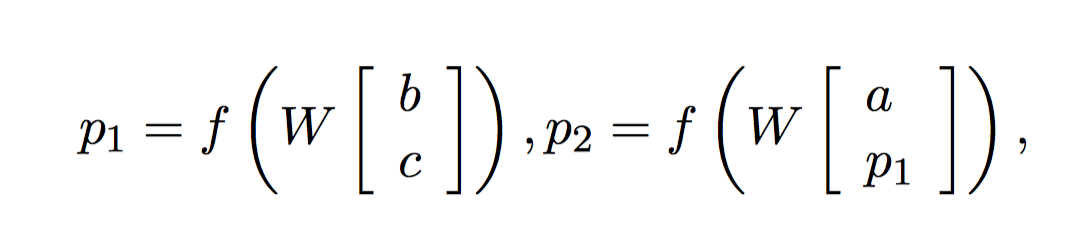

其表达式如下:

4.3 RNTN:Reucrsive Neural Tensor Network

MV-RNN面临的一个难题是参数会变得非常大并且取决于词汇量的大小。

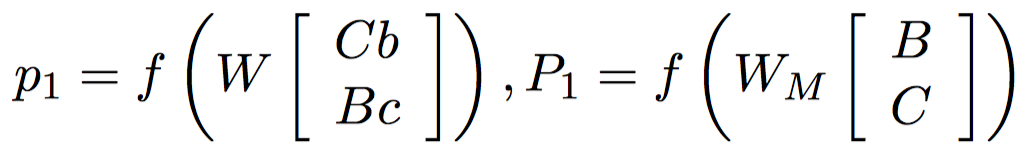

提出RNTN模型,其主要思想是对所有节点使用相同的,基于张量的组合功能。

RNTN模型相对于以往RNN的优势在于,当V设置为0的时候,即张量可以直接联系在输入向量。直观地说我们可以把每一片的张量作为捕获组合的特定类型。

4.4 Tensor Backprop through Structure

5. Exeperiments

5.1 Fine-grained Sentiment For All Phrases

5.2 Full Sentence Binary Sentiment

5.3 Model Analysis:Contrastive Conjunction

5.4 Model Analysis:High Level Negation

5.5 Model Analysis: Most Positive and NegativePhrases

6.Conclusion