Title: Rethinking Boundary Detection in Deep Learning Models for Medical Image Segmentation

Paper: https://arxiv.org/pdf/2305.00678.pdf

Code: https://github.com/xiaofang007/CTO

单位:港科大

期刊:IPMI

Introduction

作者说近年来很多医学图像分割 方法基于ViT,但是ViT有两个固有的缺点:缺乏平移不变性和局部特征较弱

lack of translation invariance and weakness in local features .

为了解决这两个问题,最近提出了很多CNNs-ViT架构,如

TransUNet TransUnet: Transformers make strong encoders for medical image segmentation.

UNETR UNETR: Transformers for 3D medical image segmentation.

Swin UNETR Swin UNETR: Swin transformers for semantic segmentation of brain tumors in MRI images.

本文也是采用CNN ViT相结合的形式,不过本文还强调了边界信息对于分割的作用

所以本文提出了一种新的网络架构,称为CTO(Convolution, Transformer, and Operator),结合了CNN、ViT和边界检测算子。

CTO遵循规范的编码器-解码器分割范式,其中编码器网络由CNNs主干和辅助轻量级ViT分支组成。为了增强边界学习能力,我们引入了一种边界引导解码器网络,该网络使用边界检测算子提取的自生成边界掩码作为显式监督来指导解码学习过程。与先进的MISeg架构相比,我们的CTO架构具有更高的识别精度,并在准确性和效率之间实现了更好的折衷。

Related work

目前的分割方法主要是三类:

- CNNs-based methods ----V-Net , U-Net , Attention-UNet

- ViT-based methods ---- Swin-UNet,MissFormer

- CNNs-ViT hybrid methods ---- TransUNet, UNETR, Swin UNETR

第一类方法缺点是CNN关注局部信息,难以完整分割

第二类方法缺点:由于医学图像的数量有限和固有的小可变性,这种方法很难优化,并且具有过高的计算成本。

第三类方法结合二者优势,缺点是计算量大,计算密集

方法总述

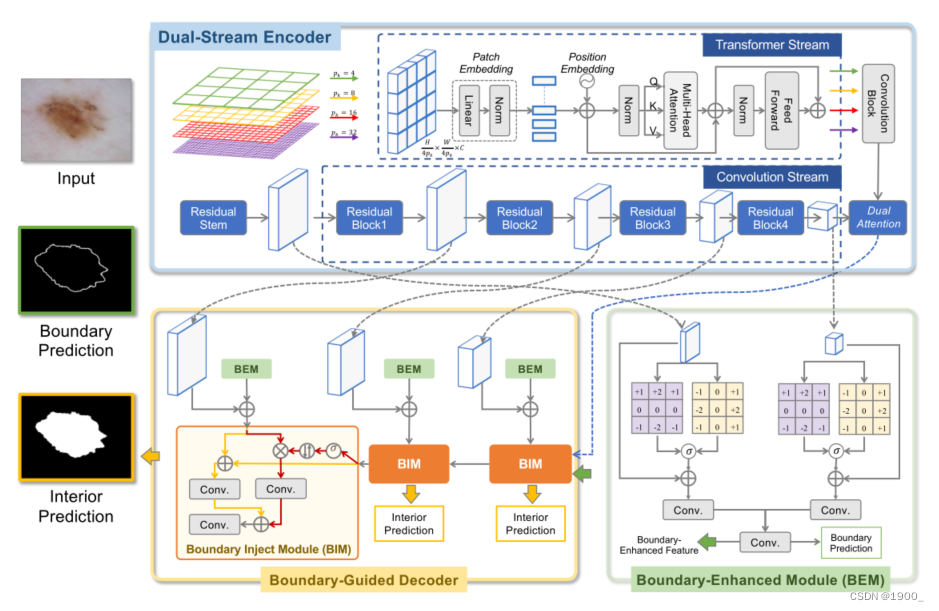

CTO的总体架构如图所示。

编码器部分:作者设计了一个双流编码器,将CNN与ViT结合,CNN作为主要,ViT作为辅助

分别使用的是:Res2Net和Light ViT

解码器:operator-guided decoder (边界引导解码器)

简单来说就是采用双分支编码器

对于输入图像,分别送入Res2Net和Light ViT

送入Res2Net得到四个输出特征x1,x2,x3,x4

送入Light ViT最终得到特征记作trans

解码器部分就是先生成一个边界,用这个边界信息作为指导,层层解码

具体来说x1和x4拿出来做一个边界检测(使用边界算子去卷积,然后再融合)生成边界预测edge

然后用ViT的输出trans与x4做一个融合

融合后,正常来将,一般的做法这里就是逐级往上解码,x3,x2,x1最后生成结果

但是本文还引入了边界信息,所以融合后的特征与边界一起和x3再做融合,然后得到的结果与x2和边界再融合,以此类推,最终生成结果图。具体的融合细节可以去看代码。

加边界这个操作还是比较常规的,这里用了一个边界消除的方法,具体可以去看代码。

另外这里是用的边界算子来生成边界的,其实我感觉跟普通卷积没什么区别(个人看法)

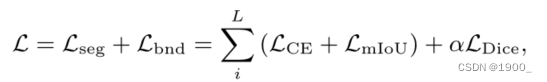

Loss

这个loss的比较常规,用的就是wBCE和wIoU

对边界的监督用的是Dice,这个也是边界常用的

实验部分

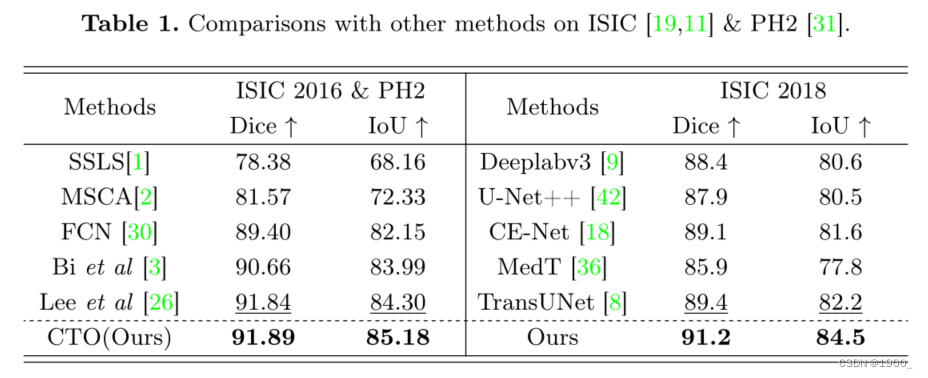

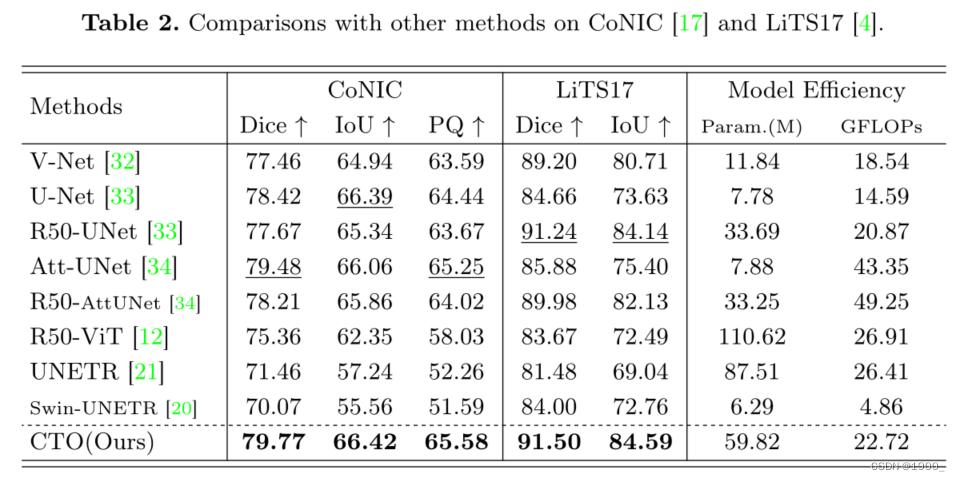

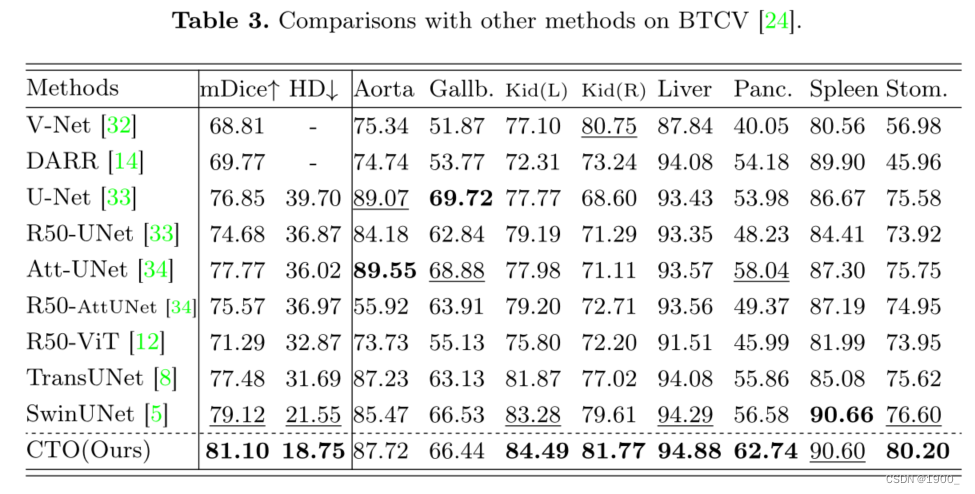

我们在六个公共MISeg数据集上评估了我们的CTO,包括三个皮肤病变分割数据集,即ISIC[19,11]和PH2[31]、结肠细胞核识别和计数(CoNIC)数据集[17]、肝肿瘤分割(LiTS17)数据集中[4]和the Beyond the Cranial Vault (BTCV)数据集[37]。

我们对ISIC 2018进行了5倍的交叉验证,并在ISIC 2016上训练了模型,并在PH2[31]上进行了测试。

BTCV分为18例用于训练和12例用于测试[5,8]。

CoNIC和LiTS17被随机分为训练、验证和测试集比例为7:1:2

评估指标:

-

Dice Coefficient (Dice)

-

Intersection over Union(IoU)

-

average Hausdorff Distance (HD)

-

Panoptic Quality (PQ)

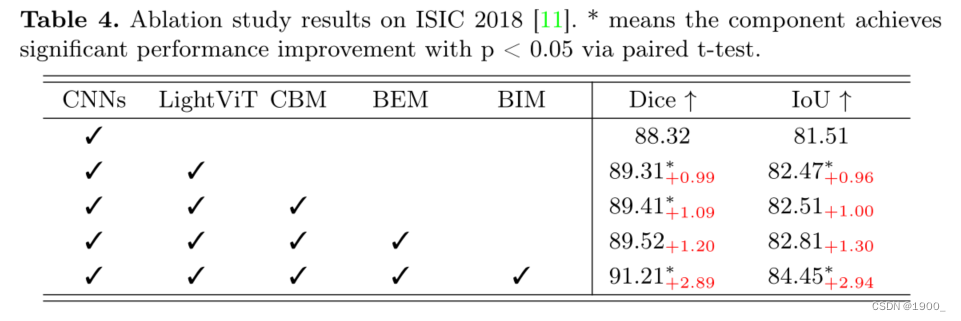

消融实验