(前提:自己的linux系统中的集群已搭建完毕 )

1 . 首先在电脑中安装 hadoop

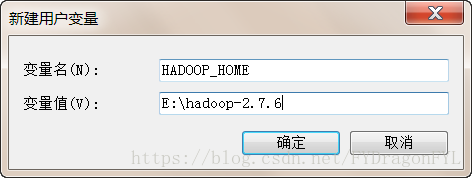

配置环境变量:

右键点击“计算机”--> 属性 --> 高级系统设置 --> 环境变量

创建一个 “HADOOP_HOME”,值为hadoop安装包的路径

在“Path”的变量值的最前面,追加{ hadoop-2.7.6\bin } 的路径。(如果没有Path,创建一个Path,添加以下内容)

Path=%HADOOP_HOME%\bin;2 . 查找 hadoop 所需要的jar包

在 { hadoop\share } 目录下 ,搜索 <.jar>, 复制后拷贝至{ hadoop-2.7.6 }/_ jar 文件夹备用

在{hadoop_home}/_jar/目录下查找<sources>文件,剪切后拷贝至{hadoop-2.7.6}/_sources/ 备用

在{hadoop_home}/_sources/目录下查找<test>文件,剪切后拷贝至{hadoop-2.7.6}/_test/ 备用

( _jar : jar包 、 _source : 源码包 、 _test : 测试包 )

3 . 集成eclipse环境

上网下载 hadoop-eclipse-plugin 的jar包,将此jar包拷贝至{ eclipse_home }/plugin 下。

(eclipse_home 为eclipse所安装的路径)

4 . 重启eclipse

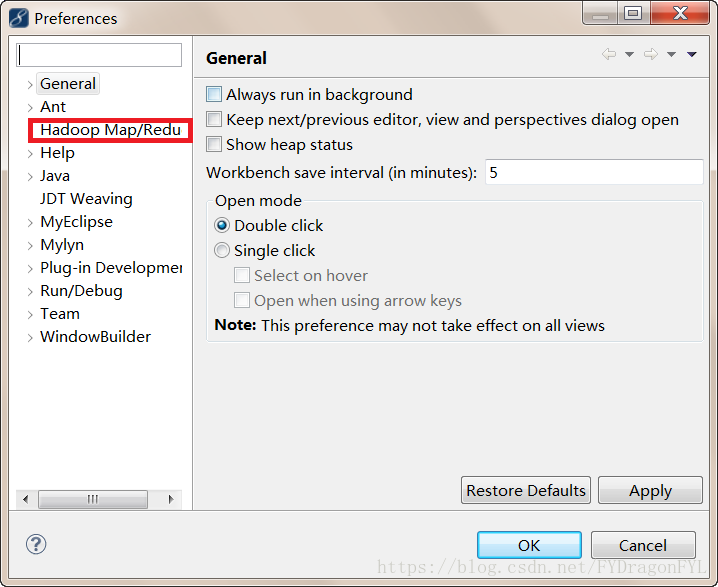

5 . 校验安装是否成功

查看windows-->perferences 是否出现 Hadoop Map/Reduce

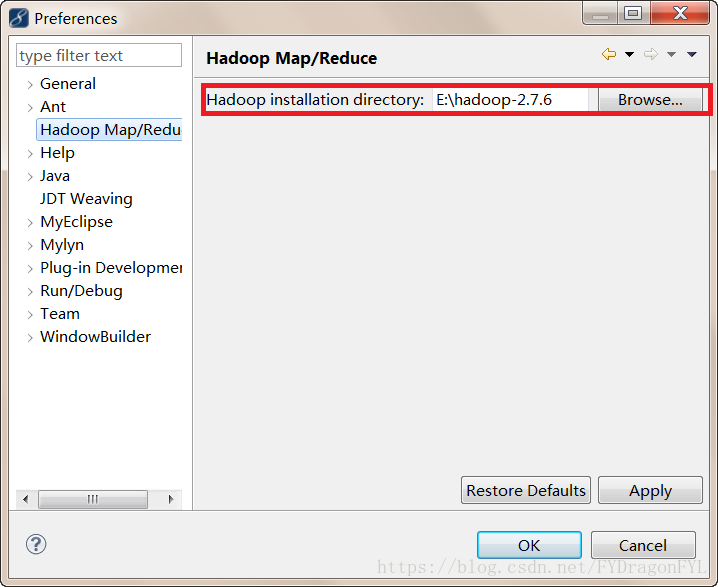

6 . 在【hadoop Mapreduce】视图下,添加hadoop的安装路径

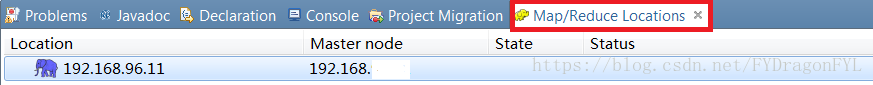

7 . 创建hadoop的链接

a>.打开【MapReduce Locations】视图-->右键【新建hadoop Location...】-->弹出编辑窗口

b>.dfs RPC 协议端口号为:9000 【注:默认为8020】

mapreduce RPC协议端口号为:9001 【注:默认为8021】

user name:XXXX 【注:集群名字】

host :主节点的 IP

8 . 配置windows Hadoop工具包

上网下载 hadoop.dll和winutils.exe 两个文件,并将其拷贝至{hadoop-2.7.6}\bin;

恭喜你。配置成功~