LeNet-5模型

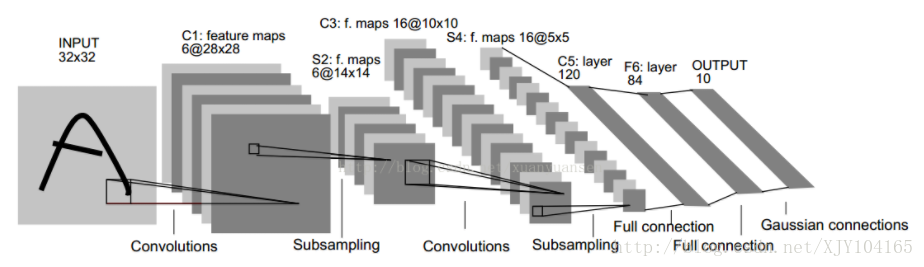

LeNet-5模型是Yann LeCun教授于1998年在论文Gradient-based learning applied to document recognition中提出的,它是第一个成功应用于数字识别问题的卷积神经网络。LeNet-5模型一共有7层,下图展示了LeNet-5模型的架构:

第一层,卷积层

这一层的输入就是原始的图像像素32*32*1。第一个卷积层过滤器尺寸为5*5,深度为6,不使用全0填充,步长为1。所以这一层的输出:28*28*6,卷积层共有5*5*1*6+6=156个参数

第二层,池化层

这一层的输入为第一层的输出,是一个28*28*6的节点矩阵。本层采用的过滤器大小为2*2,长和宽的步长均为2,所以本层的输出矩阵大小为14*14*6。

第三层,卷积层

本层的输入矩阵大小为14*14*6,使用的过滤器大小为5*5,深度为16.本层不使用全0填充,步长为1。本层的输出矩阵大小为10*10*16。本层有5*5*6*16+16=2416个参数。

第四层,池化层

本层的输入矩阵大小10*10*16。本层采用的过滤器大小为2*2,长和宽的步长均为2,所以本层的输出矩阵大小为5*5*16。

第五层,全连接层

本层的输入矩阵大小为5*5*16,在LeNet-5论文中将这一层成为卷积层,但是因为过滤器的大小就是5*5,所以和全连接层没有区别。如果将5*5*16矩阵中的节点拉成一个向量,那么这一层和全连接层就一样了。本层的输出节点个数为120,总共有5*5*16*120+120=48120个参数。

第六层,全连接层

本层的输入节点个数为120个,输出节点个数为84个,总共参数为120*84+84=10164个。

第七层,全连接层

本层的输入节点个数为84个,输出节点个数为10个,总共参数为84*10+10=850

如何设计卷积神经网络架构

下面的正则化公式总结了一些经典的用于图片分类问题的卷积神经网络架构:

“+”表示一层或多层,“?”表示有或者没有

除了LeNet-5模型,2012年ImageNet ILSVRC图像分类挑战的第一名AlexNet模型、2013年ILSVRC第一名ZF Net模型已经2014年第二名VGGNet模型的架构都满足上面的正则表达式。

如何设置卷积层或池化层配置

- 过滤器的尺寸:1或3或5,有些网络中有过7甚至11

- 过滤器的深度:逐层递增。每经过一次池化层之后,卷积层深度*2

- 卷积层的步长:一般为1,有些也会使用2甚至3

- 池化层:最多的是max_pooling,过滤器边长一般为2或者3,步长一般为2或3