最近也是抽点时间来看了李宏毅老师的机器学习课程,发现自己基础掌握的不太好。做一点笔记方便自己以后回顾~

这个是李宏毅机器学习- Logistic Regression

这个视频首先讲了机器学习最基本的一个问题——分类问题

针对二分类问题,用了机器学习中的生成模型。

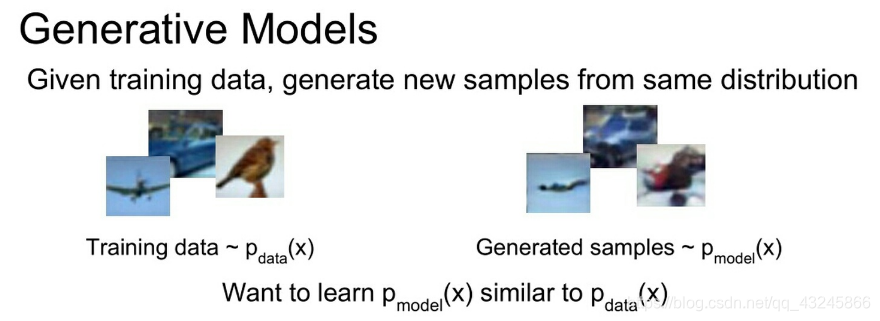

可以先来简单介绍下生成模型和判别模型,目前大多数人工智能用的方法都是一些利用数据的监督学习,但是半监督和无监督在逐渐火热。

监督学习就是从数据中学习一个模型,对给定的输入X 预测相应的输出Y ,这个模型一班形式为决策函数, 和条件概率分布P(Y|X)

生成模型和判别模型的区别:

生成模型:就是由数据学习到整体的联合概率分布P(X,Y),求出条件概率分布P(Y|X)作为预测的模型,典型的生成模型: 贝叶斯(NB),隐马尔科夫模型(HMM)等

判别模型:由数据学习到决策函数Y=f(X) 或者条件概率分布P(Y|X) 作为预测模型

典型的判别模型: KNN ,逻辑回归 ,SVM ,决策树, CRF

(转自https://zhuanlan.zhihu.com/p/45494891)

生成模型:

引用宝可梦的例子

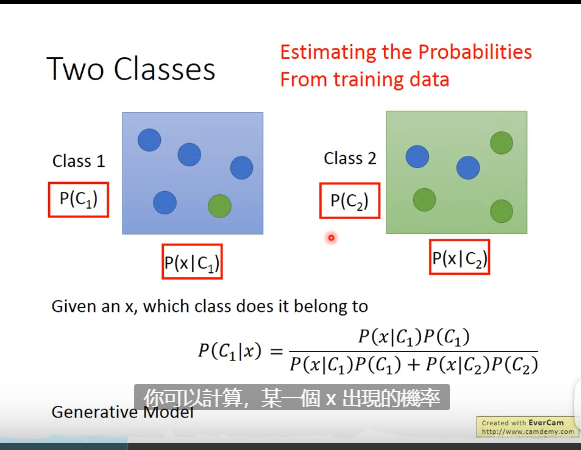

来介绍一个二分类的问题如何用generative model 解决

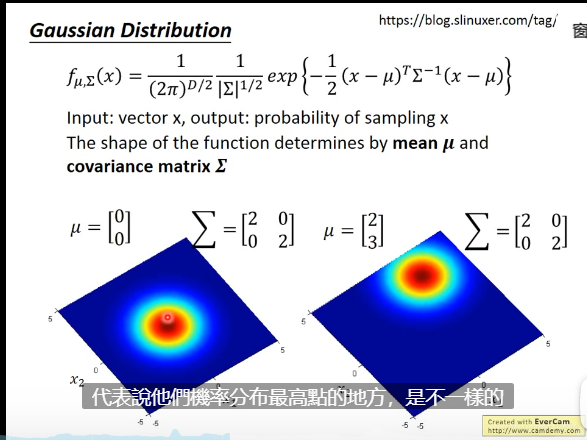

79只水系的神奇宝贝只是从大量数据中抽出来的一堆样本数据,大量数据是符合高斯分布

Gaussian Distribution

生成模型在这里就是要寻找与给定的数据相似的高斯分布的两个参数μ和Σ ,

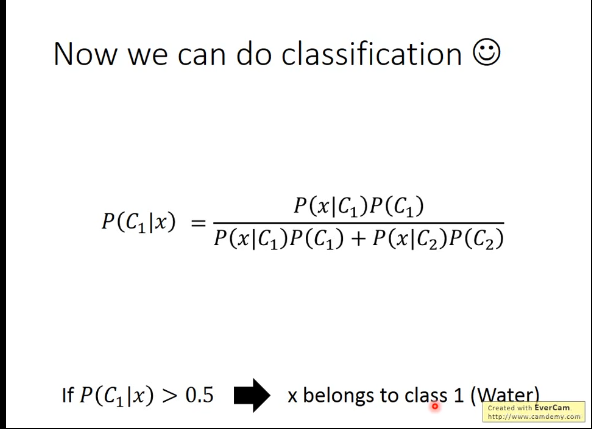

然后就可以利用公式计算,某一个物体属于某一类别的概率:

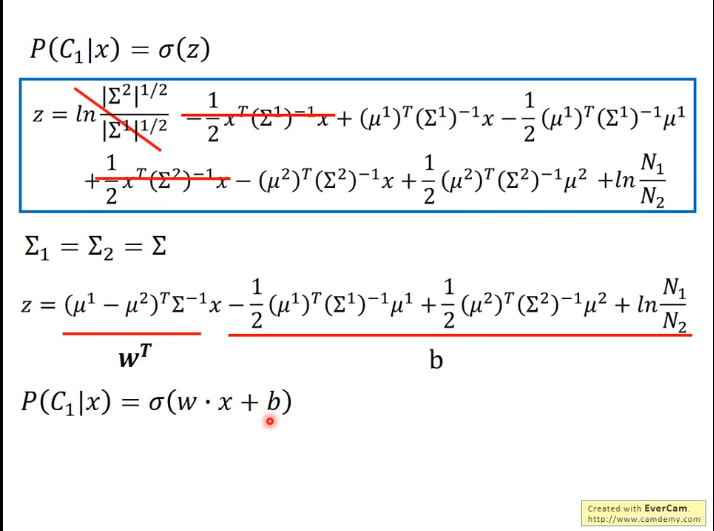

将上面的公式进行简单的推导:

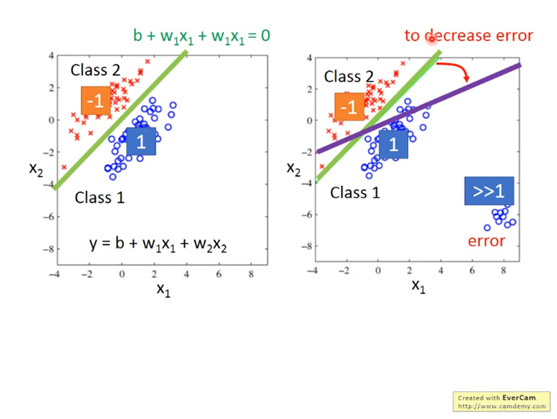

题就变成了 寻找一个W和b ,

然后我们可以比较逻辑斯蒂回归和线性回归的区别:

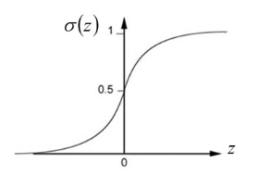

李宏毅老师讲机器学习包括后面的deep learning 都用三步介绍,从第一步的比较i我们可以看出,两者其实就是差了一个激活函数, 逻辑回归通过激活函数(比较常用的是 softmax等)将最终的值映射倒0-1的区间上:

而线性回归的值可以是任何值 any value.

后面就是关于第二步和第三步的公式推导,这个视频重点是从逻辑斯蒂回归引出了深度学习的基本概念。

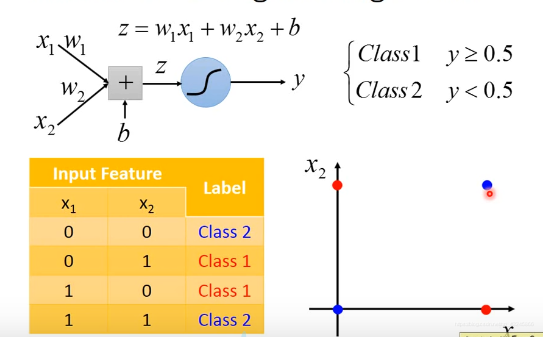

首先针对Logistic Regression提出一个简单但是难以解决的问题——:

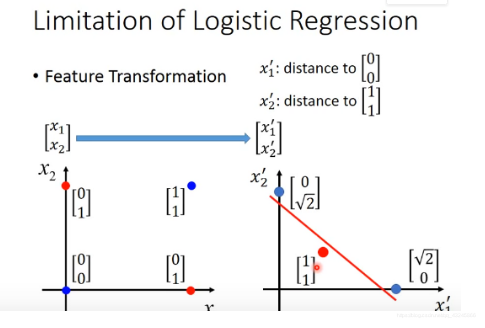

对这四个点进行分类,我们知道Logistic Regression是无法出理这样的问题,于是可以采用一种Feature Transformation(基础不行,一开始有点懵,后来反应过来其实就是类似深度学习中的特征提取,或者是不是可以说转换到另一维的特征在进行分类?)

视频中将 X1,X2 变成 X1‘ :与 [0,0]T的距离, X2‘:与[1,1]T的距离:

这样原先的分类也可以很好的解决。

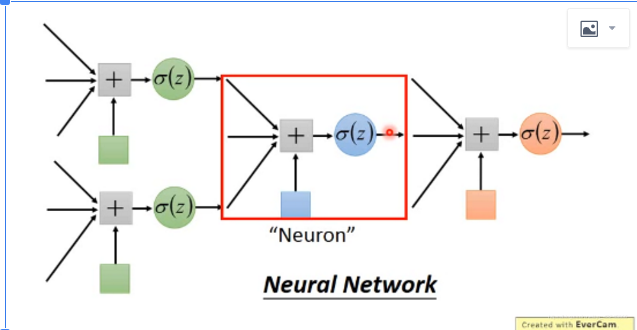

这样的feature transformation 是人工找的,如果我们想机器自己寻找呢?

方法:Cascading logistic regression models

很好的引出了 deeplearning

简单的记录下看视频的心得,方便自己以后回顾,有不对的地方欢迎批评指正~