摘要:

HDFS(Hadoop Distributed File System)是Apache Hadoop框架中的一部分,用于存储和处理大规模数据集。HDFS提供了高容错性、高可靠性和高吞吐量的分布式文件系统服务[1]。HDFS Java API是用于与HDFS进行交互的Java编程接口,它提供了一组类和方法,用于实现对HDFS文件的读取、写入、删除和修改等操作。它提供了丰富的功能和方法,使开发人员能够方便地管理和操作HDFS上的文件和目录。通过使用HDFS Java API,开发人员可以轻松地实现对大规模数据集的读取、写入和处理,从而充分发挥HDFS在分布式数据存储和处理中的优势。

一、主题概述

HDFS Java API是指用于与Hadoop Distributed File System(HDFS)进行交互的Java编程接口。HDFS是Apache Hadoop框架中的一部分,用于存储和处理大规模数据集。HDFS Java API提供了一组类和方法,使开发人员能够管理和操作HDFS文件系统。

HDFS Java API适用于需要处理大规模数据集的场景,如大数据分析、机器学习、日志处理等。它可以有效地处理大量的数据,并且具有容错性和高可用性。HDFS采用分布式存储方式,将数据分散存储在多个节点上,提供了高吞吐量和可扩展性,因此非常适合处理大规模数据。

HDFS Java API的发展历史可以追溯到Hadoop项目的早期阶段。随着Hadoop项目的不断发展和完善,HDFS Java API也得到了不断的改进和扩展。最初的版本提供了基本的文件操作功能,如创建、读取和写入文件。随着时间的推移,API逐渐增加了更多的功能,包括目录操作、块操作、权限管理等。同时,API的性能和稳定性也得到了改进,以满足不断增长的大数据处理需求[2]。

未来,HDFS Java API的发展趋势将主要集中在以下几个方面。首先,随着大数据技术的不断发展,HDFS Java API将继续优化性能和可扩展性,以更好地处理大规模数据。其次,随着云计算和容器技术的普及,API将逐渐向云原生方向发展,以更好地支持在云环境下的大数据处理。此外,随着人工智能和机器学习的快速发展,API可能会增加更多与这些领域相关的功能和方法。

总之,HDFS Java API是用于与Hadoop Distributed File System进行交互的Java编程接口,适用于大规模数据处理场景。它具有丰富的功能和方法,提供了高性能、可靠性和可扩展性。随着大数据技术的发展,HDFS Java API将继续改进和完善,以满足不断变化的大数据处理需求。

- 应用情况

HDFS Java API的应用情况如下:

1. 应用领域:

HDFS Java API广泛应用于大数据处理领域,特别是与Hadoop生态系统相关的应用。它适用于以下场景:

- 大数据分析:通过HDFS Java API,可以读取和处理存储在HDFS上的大规模数据集,进行数据分析、挖掘和统计等操作。

- 机器学习:HDFS Java API提供了对HDFS文件的读取和写入功能,可以用于机器学习算法的训练和模型的存储。

- 日志处理:通过HDFS Java API,可以将大量的日志数据存储到HDFS上,并进行实时或批量处理。

2. 基本内容和使用方法:

HDFS Java API提供了丰富的功能和方法,用于管理和操作HDFS文件系统。以下是一些常用的方法和其使用示例:

- 创建文件:

```java

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path filePath = new Path("/user/data/file.txt");

FSDataOutputStream outputStream = fs.create(filePath);

```

- 写入数据:

```java

String data = "Hello, world!";

byte[] bytes = data.getBytes();

outputStream.write(bytes);

```

- 读取文件:

```java

FSDataInputStream inputStream = fs.open(filePath);

byte[] buffer = new byte[1024];

int bytesRead = inputStream.read(buffer);

String content = new String(buffer, 0, bytesRead);

System.out.println(content);

```

- 创建目录:

```java

Path dirPath = new Path("/user/data");

fs.mkdirs(dirPath);

```

- 删除文件或目录:

```java

Path deletePath = new Path("/user/data/file.txt");

fs.delete(deletePath, true);

```

以上只是HDFS Java API的一小部分功能和使用示例,API还提供了许多其他方法,如重命名文件、设置副本数量、获取文件块信息等。

3. 与相关相似主题的异同点:

与HDFS Java API相关的相似主题包括其他与HDFS交互的编程接口,如HDFS Shell、WebHDFS等。这些主题在与HDFS的交互方式、功能和使用方法上存在一些异同点。

- 异同点:

- HDFS Java API是基于Java编程语言的接口,而HDFS Shell是基于命令行的接口,WebHDFS是通过HTTP协议进行交互的RESTful接口。

- HDFS Java API提供了更丰富的功能和灵活性,可以更好地满足复杂的数据处理需求,而HDFS Shell和WebHDFS通常用于简单的文件操作。

- HDFS Java API需要开发人员编写代码进行调用,而HDFS Shell和WebHDFS可以直接在命令行或通过HTTP请求进行操作。

- 相同点:

- HDFS Java API、HDFS Shell和WebHDFS都是与HDFS进行交互的方式,它们都可以用于文件的读取、写入、删除等操作。

- 无论是HDFS Java API、HDFS Shell还是WebHDFS,它们都遵循HDFS的设计原则和架构,提供了对HDFS文件系统的访问能力。

总之,HDFS Java API在大数据处理领域有广泛的应用,适用于大规模数据分析、机器学习和日志处理等场景。它提供了丰富的功能和方法,可以进行文件的创建、读取、写入、删除等操作。与其他与HDFS交互的编程接口相比,HDFS Java API在功能和灵活性上更为强大,但需要开发人员编写代码进行调用。

- 实验情况

1)实验环境描述:

1. 安装Java开发环境:Java Development Kit (JDK)是Java开发的基础环境。可以从Oracle官方网站下载并安装适合操作系统的JDK版本。安装完成后,确保已经设置了JAVA_HOME环境变量,并将其添加到PATH环境变量中。

2. 下载Hadoop:前往Apache Hadoop官方网站,下载最新的稳定版本的Hadoop。选择合适的二进制版本(例如.tar.gz格式),并解压到选择的目录中。解压后的文件夹包含了Hadoop的所有必要文件和目录。

3. 配置Hadoop:Hadoop需要使用Java运行时环境来执行,因此需要设置JAVA_HOME环境变量以便Hadoop能够找到Java。进入Hadoop解压后的目录,并编辑`etc/hadoop/hadoop-env.sh`文件,设置JAVA_HOME变量为JDK安装路径。

4. 引入Hadoop依赖库:Hadoop提供了Java API用于访问HDFS文件系统。在Java项目中引入Hadoop的依赖库。可以手动将Hadoop的JAR文件添加到项目中,或者使用构建工具(如Maven或Gradle)来管理依赖关系。

- 编写Java代码:使用HDFS Java API进行文件系统操作。可以使用`org.apache.hadoop.fs.FileSystem`类来获取HDFS文件系统对象,并使用其提供的方法进行文件的读写、创建、删除等操作。

- 运行代码:编译并运行Java代码,确保HDFS Java API正常工作。可以使用命令行工具或集成开发环境(IDE)来运行代码。如果一切正常,能够在控制台上看到输出结果。

- 实验过程:

以下是使用HDFS Java API上传文件过程:

package com.atguigu.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import java.util.Arrays;

/**

* 客户端代码中设置的值 > ClassPath 下的用户自定义配置文件 > 然后是服务器的自定义配置(xxx-site.xml)> 服务器的默认配置(xxx-default.xml)

*/

public class HdfsClient {

FileSystem fileSystem;

@Before

public void init() throws URISyntaxException, IOException, InterruptedException {

// 连接集群地址

URI uri = new URI("hdfs://hadoop102:8020");

// 创建配置文件

Configuration configuration = new Configuration();

// 用户

String user = "atguigu";

// 获取客户端对象

fileSystem = FileSystem.get(uri, configuration, user);

}

@After

public void close() throws IOException {

// 关闭资源

fileSystem.close();

}

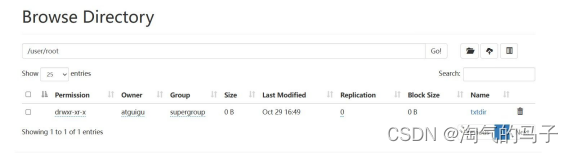

// 创建目录

@Test

public void testmkdir() throws URISyntaxException, IOException, InterruptedException {

// 创建文件夹

fileSystem.mkdirs(new Path("/user/root/txtdir"));

}

//上传

@Test

public void testPut() throws IOException {

// 参数一:表示删除原数据;参数二:是否允许覆盖;参数三:原数据路径;参数四:目的地路径

fileSystem.copyFromLocalFile(true, true, new Path("train.csv"),

new Path("/user/hive/warehouse/tidanic"));

}

//下载

@Test

public void testGet() throws IOException {

// 参数一:是否删除原文件;参数二:原文件路径;参数三:目的地路径;参数四:是否开启本地校验

fileSystem.copyToLocalFile(false, new Path("/xiyou/hua/sun.txt"),

new Path("D:\\sun.txt"), true);

}

//删除

@Test

public void testRm() throws IOException {

// 参数一:要删除的路径;参数二:是否递归删除,空目录需要递归删除

fileSystem.delete(new Path("/xiyou"), true);

}

//文件更名和移动

@Test

public void testMv() throws IOException {

// 参数一:源文件路径;参数二:目标文件路径;

// 对文件名称的修改

// fileSystem.rename(new Path("/input/word.txt") ,new Path("input/66.txt"));

// 文件的移动和更名

// fileSystem.rename(new Path("/input/66.txt") ,new Path("/77.txt"));

// 目录更名

fileSystem.rename(new Path("/input") ,new Path("/output.txt"));

}

//文件详情查看

@Test

public void testListFiles() throws IOException {

// 获取所有文件信息

RemoteIterator<LocatedFileStatus> listFiles = fileSystem.listFiles(new Path("/"), true);

// 遍历文件

while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

System.out.println("==========" + fileStatus.getPath() + "==========");

System.out.println(fileStatus.getPermission());

System.out.println(fileStatus.getOwner());

System.out.println(fileStatus.getGroup());

System.out.println(fileStatus.getLen());

System.out.println(fileStatus.getModificationTime());

System.out.println(fileStatus.getReplication());

System.out.println(fileStatus.getBlockSize());

System.out.println(fileStatus.getPath().getName());

// 获取块信息

BlockLocation[] blockLocations = fileStatus.getBlockLocations();

System.out.println(Arrays.toString(blockLocations));

}

}

//判断是文件还是文件夹

@Test

public void testFile() throws IOException {

FileStatus[] listStatus = fileSystem.listStatus(new Path("/"));

for (FileStatus status : listStatus) {

if (status.isFile()) {

System.out.println("文件" + status.getPath().getName());

} else {

System.out.println("目录" + status.getPath().getName());

}

}

}

}在这个示例中,首先创建了一个`Configuration`对象,并设置了HDFS的地址。然后,通过调用`FileSystem.get(conf)`方法获取了HDFS文件系统对象。

接下来,指定了本地文件的路径和HDFS目标文件的路径。请将`localFilePath`替换为要上传的本地文件的路径,将`hdfsFilePath`替换为要上传到的HDFS目标文件的路径。

最后,使用`fs.copyFromLocalFile()`方法将本地文件上传到HDFS。上传完成后,输出一条成功的消息,并关闭`FileSystem`对象。

四、总结

HDFS(Hadoop Distributed File System)是Hadoop生态系统中的分布式文件系统,是Hadoop的核心组件之一。HDFS提供了高容错性、高吞吐量和可扩展性的存储解决方案,适用于大规模数据的存储和处理。

HDFS Java API是Hadoop提供的用于与HDFS进行交互的Java编程接口。通过使用HDFS Java API,我们可以在Java程序中实现对HDFS的文件操作,包括创建文件、写入数据、读取数据、删除文件等。

以下是对HDFS Java API的详细总结:

1. 配置和初始化

在使用HDFS Java API之前,需要创建一个Configuration对象,并设置相关的Hadoop配置信息,如HDFS的地址、副本数量等。可以通过Configuration类的构造函数或set()方法来设置这些配置信息。然后通过FileSystem类的静态方法get()来获取一个FileSystem对象,用于后续的文件操作。

2. 文件路径

在HDFS中,文件路径采用URI格式,以"hdfs://"开头。可以使用Path类来表示文件路径,通过构造函数传入一个字符串形式的路径。

3. 文件操作

HDFS Java API提供了一系列用于文件操作的方法,包括创建文件、写入数据、读取数据、删除文件等。可以使用FSDataOutputStream类来创建文件并获取输出流,通过write()方法将数据写入文件;使用FSDataInputStream类来获取输入流,通过read()方法从文件中读取数据。

4. 异常处理

在使用HDFS Java API时,需要注意异常处理。例如,在创建文件或读写数据时,可能会出现网络故障、权限问题等异常情况,需要使用try-catch语句来捕获并处理这些异常。

5. 关闭资源

在完成文件操作后,需要及时关闭相关的资源,包括输入流、输出流和FileSystem对象。可以使用close()方法来关闭这些资源,以释放系统资源。

总之,HDFS Java API提供了一种方便的方式来与HDFS进行交互,并实现对分布式文件系统的管理和操作。通过使用HDFS Java API,我们可以在Java程序中轻松地实现对HDFS的读写操作,从而构建出强大的分布式数据处理应用程序。

五、参考文献

[1] Garry Turkington. Hadoop基础教程[M]. 张治起译. 人民邮电出版社 第1版, 2014.

[2] 董西成. Hadoop技术内幕:深入解析MapReduce架构设计与实现原理[M]. 机械工业出版社, 2013.