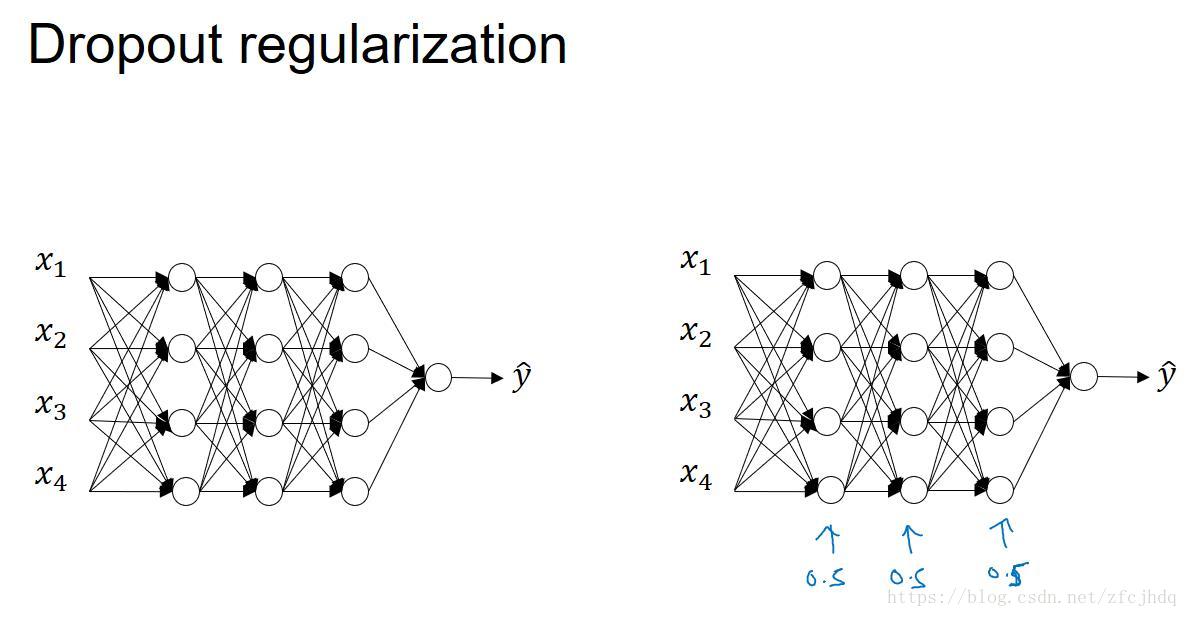

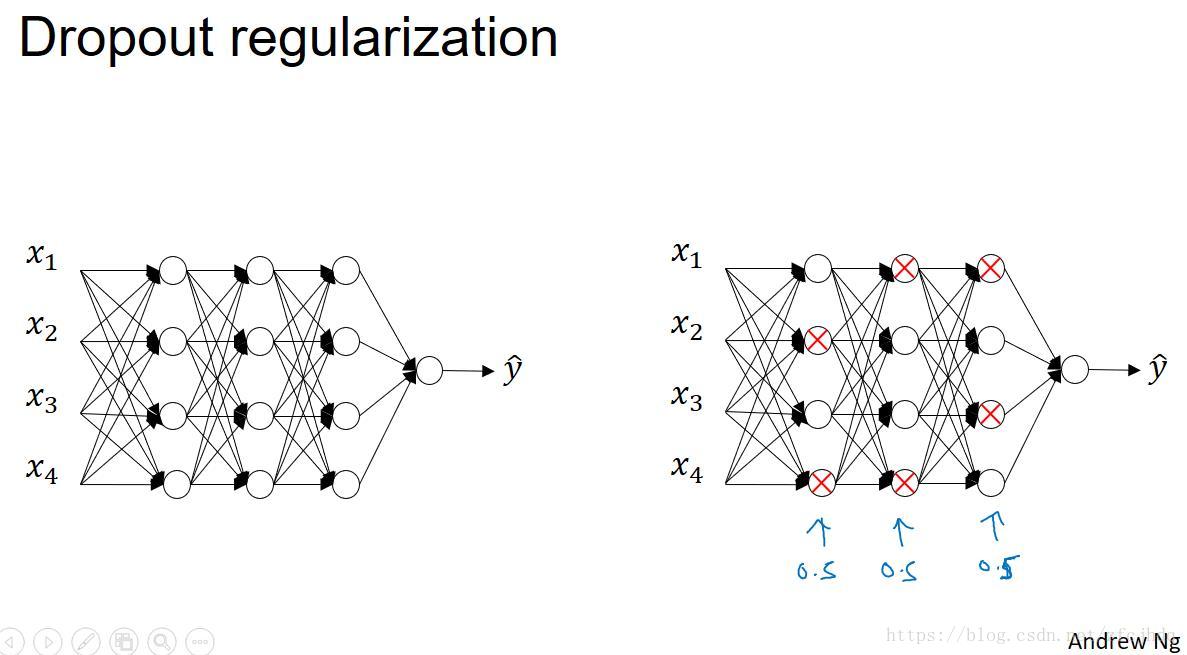

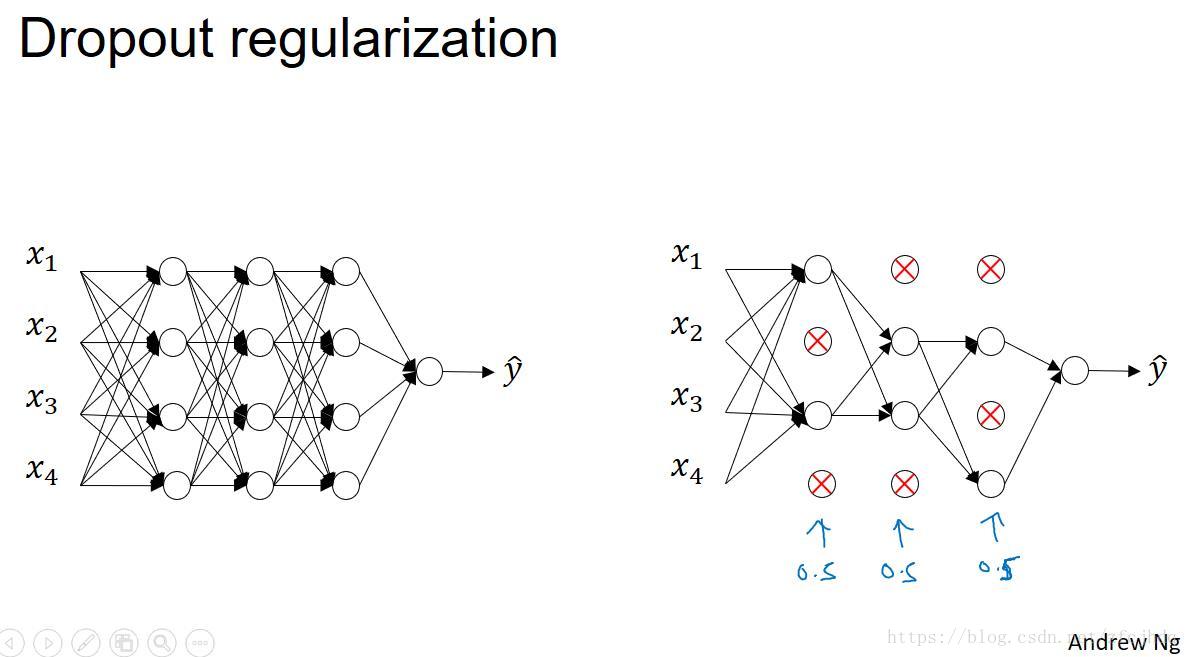

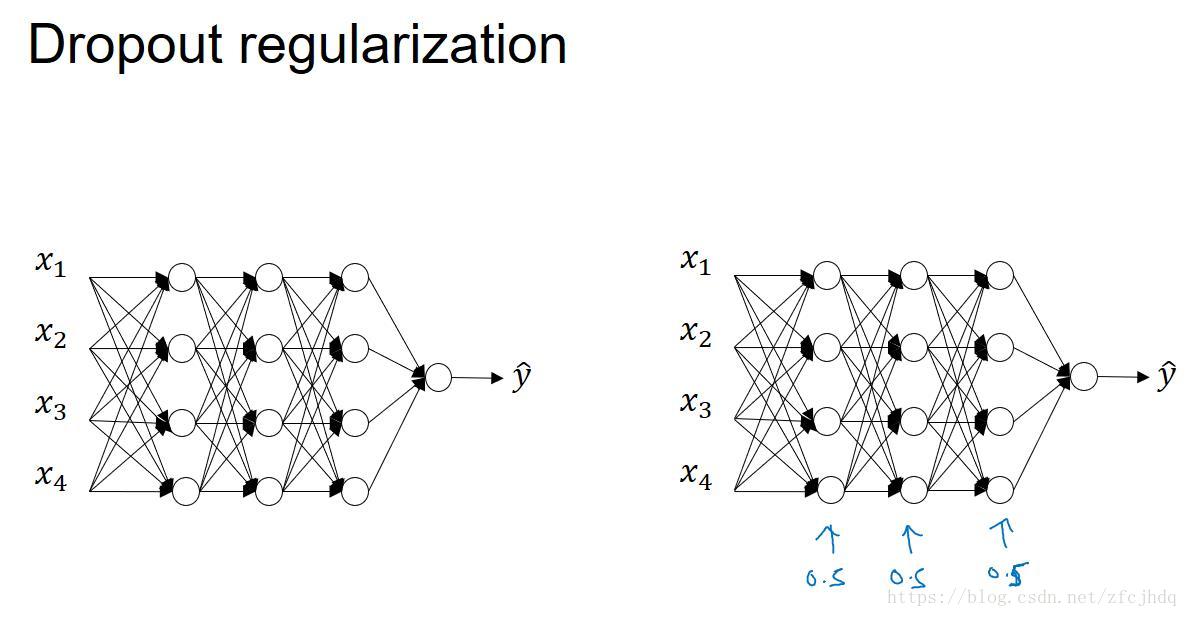

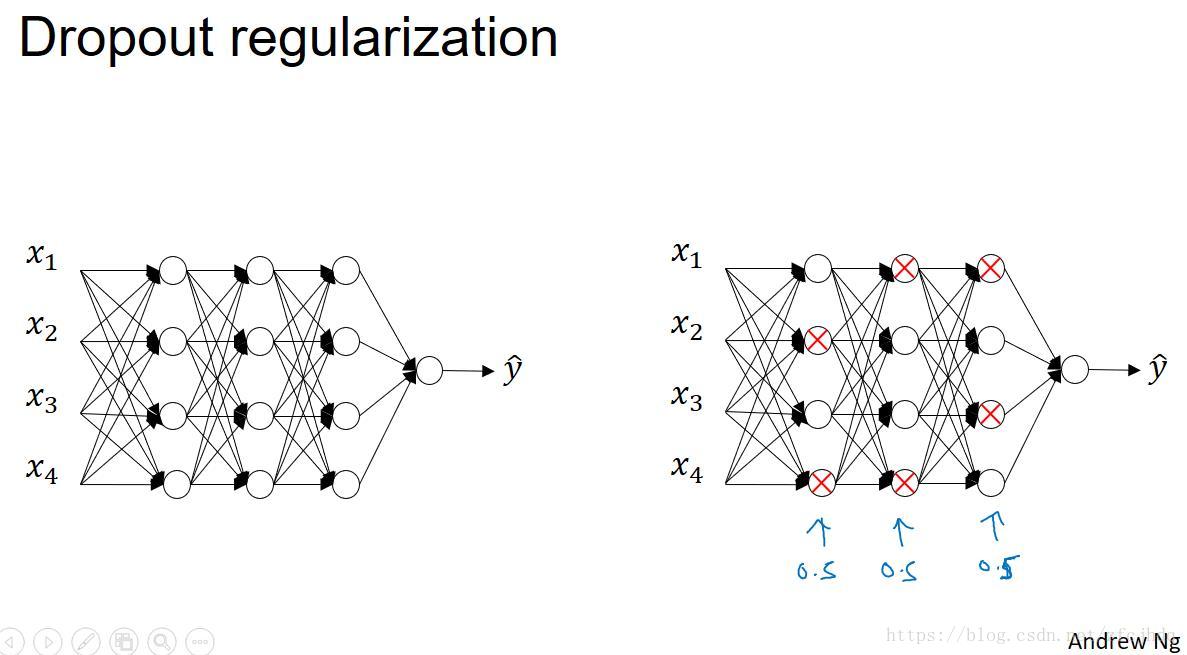

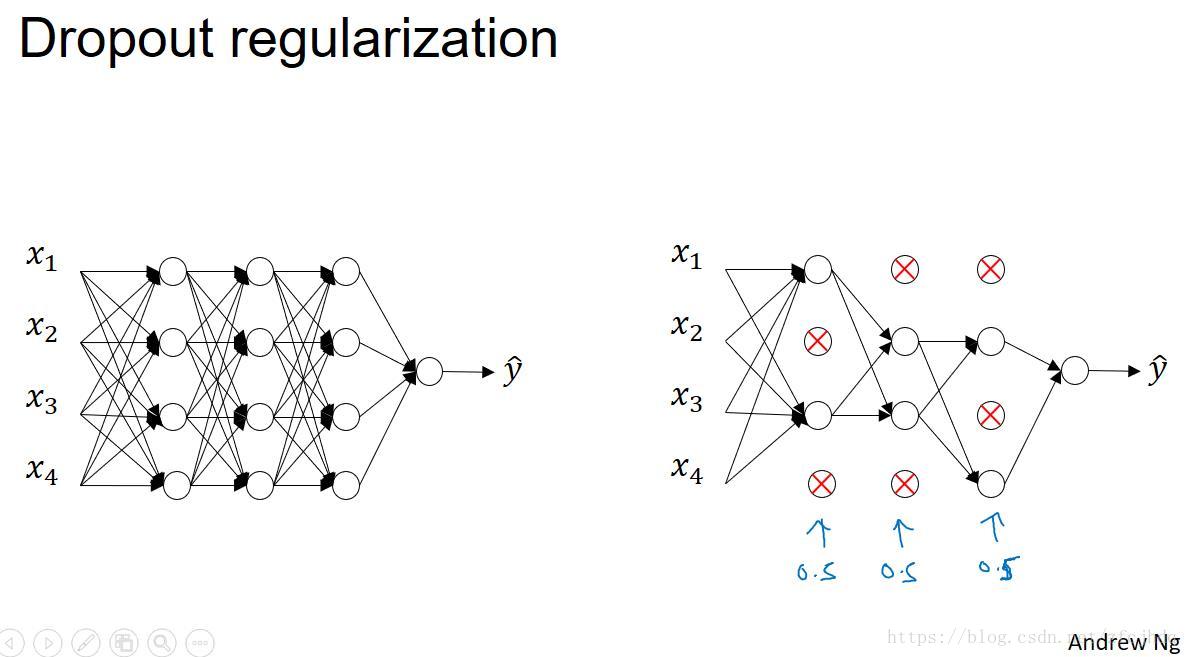

Dropout regularization 随机失活正则化

在训练神经网络时,随机在每层选择一定数量的neuron关闭,从而达到减小过拟合的目的。看起来很疯狂,但是很有效。

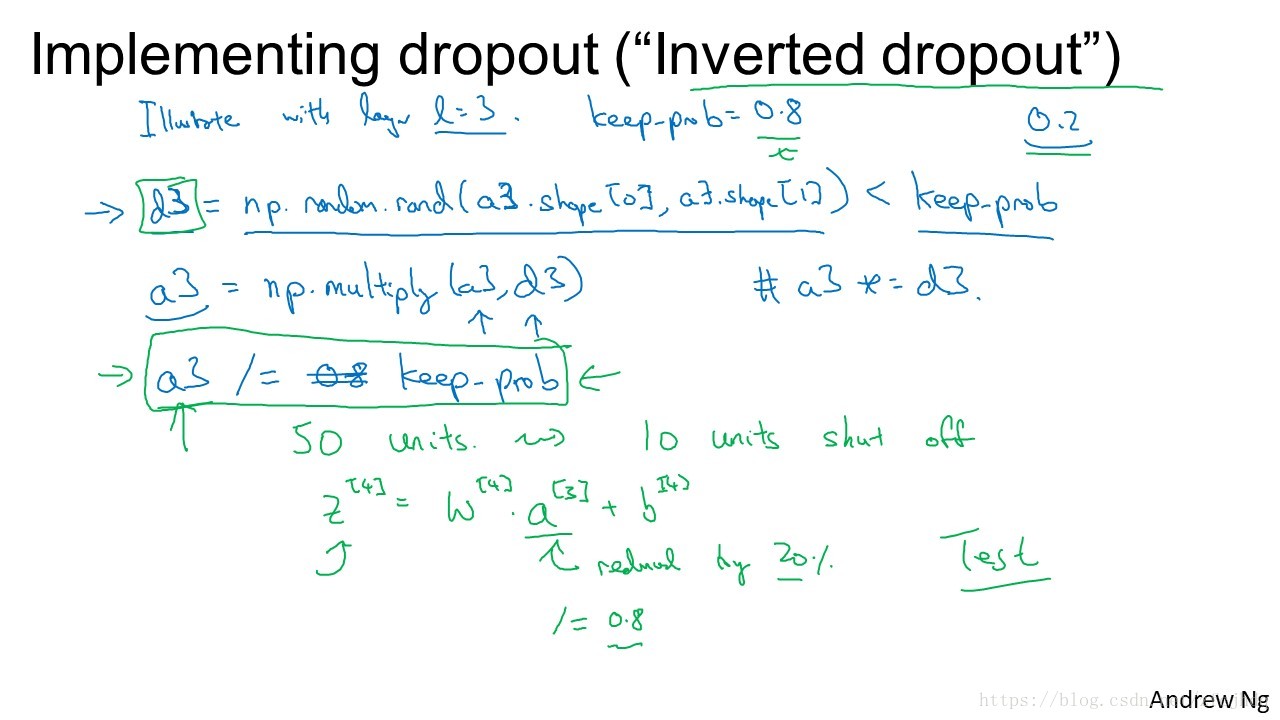

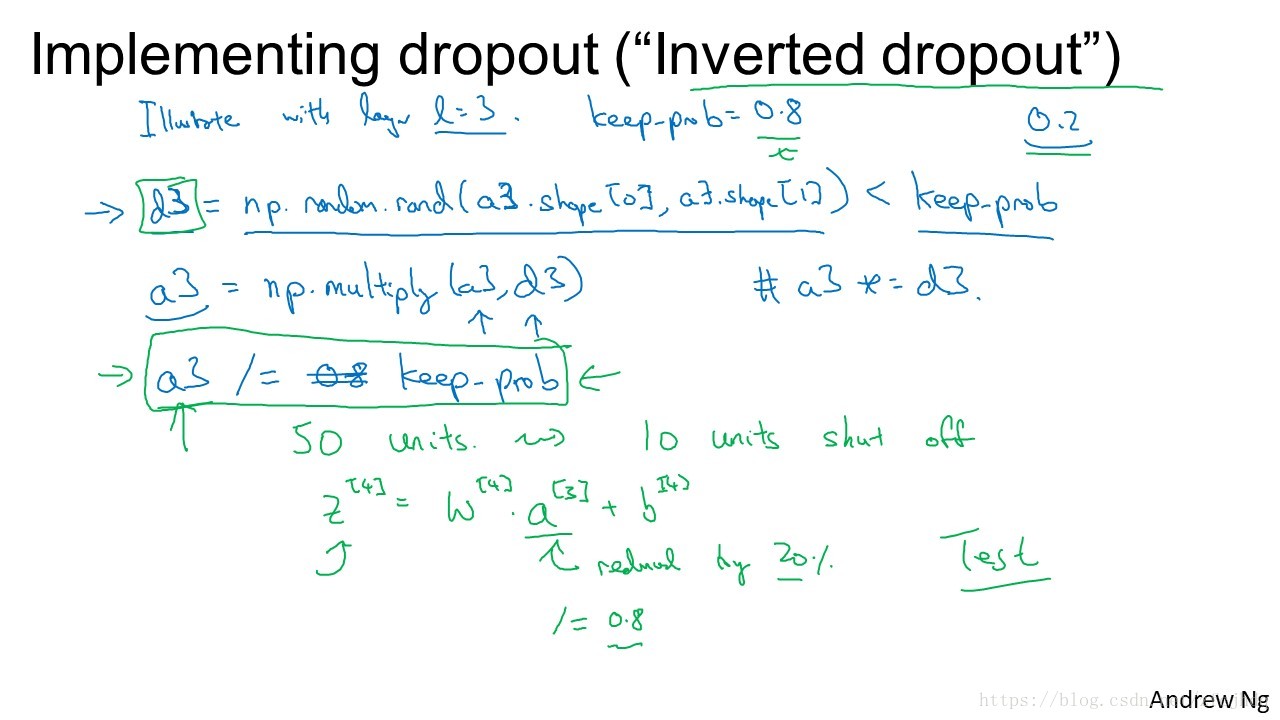

1. 对应每一层生成以个mask

2. 用mask与该层的neurons

覆盖,dropout一些neuron

3. 剩余的neurons除以keep-prob,从而保持该层输出

的期望值不变,避免在测试的时候出现的缩放问题

在训练神经网络时,随机在每层选择一定数量的neuron关闭,从而达到减小过拟合的目的。看起来很疯狂,但是很有效。

1. 对应每一层生成以个mask

2. 用mask与该层的neurons

覆盖,dropout一些neuron

3. 剩余的neurons除以keep-prob,从而保持该层输出

的期望值不变,避免在测试的时候出现的缩放问题