迅易科技微软产品经理Wendy.Ling强力推荐:此次新功能帮用户打造专属ChatGPT,是实现降本增效的利器,特此分享。迅易科技作为微软12年金牌合作伙伴,专注于Power BI、Azure等产品发展和应用落地实践,致力于为企业实现数字化革新。如您需更多微软产品应用及方案案例探讨,欢迎私聊小编。

微软很高兴宣布,Azure OpenAI 服务(公共预览版)推出支持 GPT-3.5-Turbo、Babbage-002 和 Davinci-002 模型的 Fine-tuning(微调)功能。

这将允许开发人员使用自己的数据自定义喜爱的 OpenAI 模型,并轻松部署。所有这些都在一个非常易用的托管服务中实现。自今年1月微软推出了 Azure OpenAI 服务以来,开发人员持续将 AI 的力量引入应用程序,此次更新揭开了 AI 之旅的新篇章——让利用您的数据自定义模型来解决您的问题,成为可能。

Azure OpenAI 服务推出了两款新的基本推理模型(Babbage-002 和 Davinci-002),以及三款模型的 Fine-tuning 功能(Babbage-002、Davinci-002 和 GPT-3.5-Turbo)。

新模型:Babbage-002 和 Davinci-002 是 GPT-3 基础模型,用于完成类应用案例。它们能够生成自然语言或代码。Babbage-002 取代了已弃用的 Ada 和 Babbage 模型,而 Davinci-002 取代了 Curie 和 Davinci 模型。这些模型支持调用 completion API。

Fine-tuning 功能:现在,用户可以使用 Azure OpenAI 服务或 Azure 机器学习对 Babbage/Davinci-002 和 GPT-3.5-Turbo 进行 Fine-tuning。Babbage-002 和 Davinci-002 支持 completion,Turbo 支持对话式交互。通过几个简单的命令,您就可以指定基本模型、提供数据、进行训练和部署。

Fine-tuning 是开发人员和数据科学家用来定制大型语言模型,以满足特定任务需求的方法之一。与“检索增强生成”(Retrieval Augmented Generation,RAG)和“提示工程”等方法通过在提示中注入正确的信息和指令不同,Fine-tuning 则是通过对大型语言模型本身进行个性化定制来实现的。

Azure OpenAI 服务和 Azure 机器学习提供了监督式 Fine-tuning,允许您提供自定义数据(提示/补全或对话式聊天,具体取决于选择的模型),以教授基本模型新的技能。

您可以将 Fine-tuning 视为“专家模式”,它功能强大,但需要建立在坚实的基础知识之上。Fine-tuning 可以让模型精益求精,但这需要适当的用例、高质量的数据以及正确的模型和提示才能成功。

在开始使用 Fine-tuning 之前,我们建议您首先尝试提示工程或 RAG (检索增强生成)——这是最快的入手方式。微软提供了如 Prompt Flow 或 On Your Data 工具来使此过程变得更简单。您可以在需要 Fine-tuning 模型的场景下进行比较,以选择从提示工程还是 RAG 开始入手。大多数模型都会结合提示工程和 Fine-tuning,从而避免浪费精力。

想要了解何时/是否应该进行 Fine-tuning?一些基本规则可以为您提供指导:

以下场景不适合使用 Fine-tuning:

- 如果您希望简单而快速地获取结果,请不要立即开始使用 Fine-tuning:因为这需要大量的数据和时间来训练和评估新模型。如果时间有限,通常只需通过提示工程即可取得相当大的进展。

- 如果您需要最新或域外数据,这是使用 RAG 和提示工程的完美用例。

- 如果您希望确保您的模型具有良好的基础,避免产生幻觉(hallucinations),那么 RAG 在这方面表现出色。

可以考虑使用 Fine-tuning 的场景包括:

1.教会模型一项新技能,以便它在特定任务上表现出色,如分类、摘要或始终以特定格式或语调进行回应。有时,通过 Fine-tuning 较小的模型,也能使其在特定任务上与较大的模型一样出色。

2.通过示例向模型演示如何执行某些操作,但在提示中很难解释清楚,或者示例太多,上下文窗口中无法容纳。这些场景有很多边缘情况,比如自然语言查询,或者教模型用特定的声音或语调说话。

3.减少延迟。较长的提示可能需要更长的处理时间,而 Fine-tuning 允许您将这些较长的提示集成到模型本身中。

使用 Azure Open AI 服务进行 Fine-tuning 将为您带来双重优势:您可以自定义先进的 OpenAI 大语言模型(LLMs),同时部署在 Azure 的安全、企业级云服务上。Azure 的内容审查功能让您使用所需的数据进行 Fine-tuning 时,可以过滤掉任何有合规风险的数据及响应。

如果您是 Azure OpenAI 服务和 LLMs 的新用户,欢迎您使用微软提供的简单易用的 API 来训练和部署模型。如果您更愿意使用 GUI,可以尝试 Azure OpenAI Studio。如果您正在从 OpenAI 迁移到 Azure,API 可两者兼容。

Fine-tuning 分为两个部分:训练 Fine-tuning 模型以及使用新定制的模型进行推理。

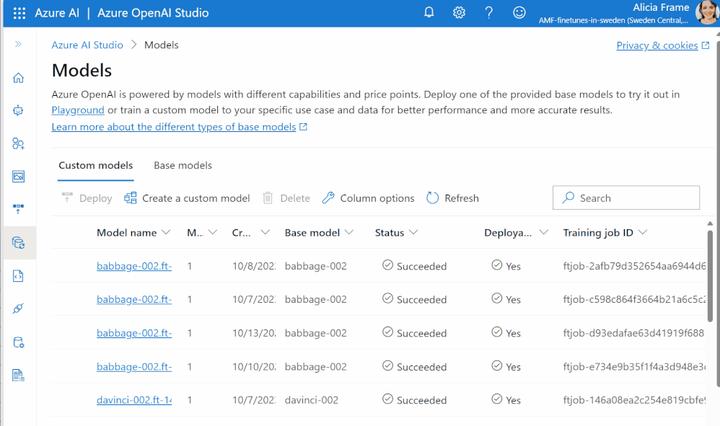

训练:指定您的基本模型、训练和验证数据,并设置超参数,就可以开始了!您可以使用 Azure OpenAI Studio 进行简单的 GUI 操作,或者对于更高级的用户,我们还提供了 REST API 或 OpenAI Python SDK。

完成 Fine-tuning 后,将返回评估指标,例如训练和验证损失。

Fine-tuning 作为一项托管服务,用户无需担心管理计算资源或容量。用户在提交任务时,将以 15 分钟为区间进行计费,且只按照成功进行 Fine-tuning 的有效训练时间计费。价格取决于您选择的基本模型:Babbage-002 为34 美元/小时,Davinci-002 为 68 美元/小时,Turbo 为102 美元/小时。

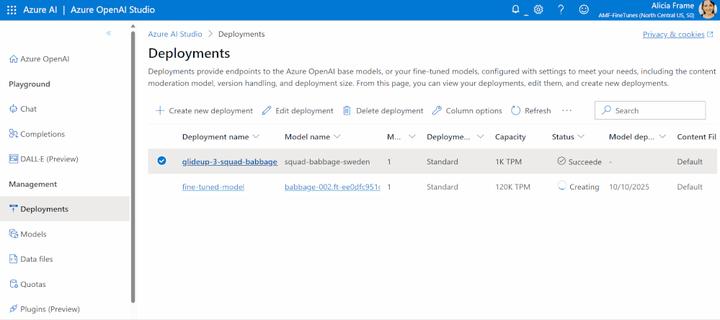

在 Azure OpenAI 服务中进行推理:训练完成后,新模型将在您的资源中可用。当使用您的模型用于推理时,该定制模型可像任何其他 OpenAI LLM 一样进行部署!

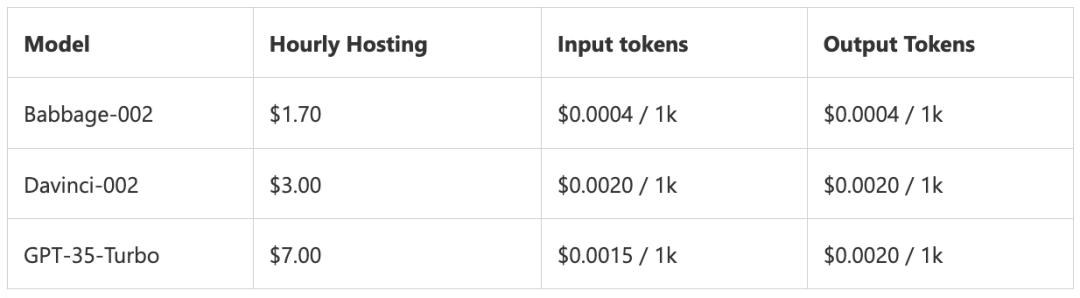

经过 Fine-tuning 的模型部署后将按小时收取托管费用,基于输入和输出 token 计价:

如果您不需要立即使用模型,存储已训练的模型是免费的。

如果您熟悉使用 Azure Machine Learning Studio 来开发、监控和部署模型,您可以将 Fine-tuning 集成至 AML 工作流程中的现有模型。除了 OpenAI 模型,Azure 机器学习还支持对开源模型进行 Fine-tuning,例如 LLaMa。

想要了解更多Power BI、Azure等产品功能,欢迎前往迅易科技官网,或私聊小编~