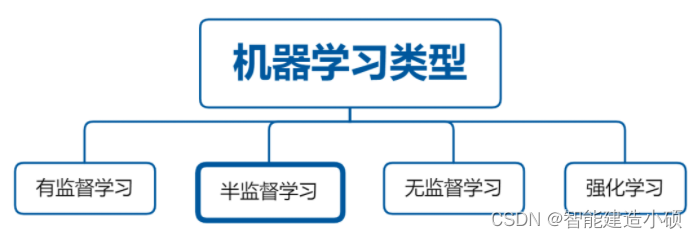

半监督学习是一种利用标记和未标记数据的机器学习方法。半监督学习的目标是结合监督学习和无监督学习的优点;利用标记数据的准确性以及未标记数据的丰富性和较低成本。半监督学习可以被认为是

监督学习(利用标记数据进行训练)和

无监督学习(不需要标签)之间的桥梁。监督学习要求所有数据都被标记,而无监督学习根本不需要标签,而半监督学习结合了标记和未标记数据来训练模型,然后可以进行预测。与单独使用其他两种方法相比,这会带来更好的性能。

半监督学习的好处

使用半监督学习有几个主要好处:

节省成本:标记数据可能是一个乏味且昂贵的过程,并且在许多情况下,标记项目所需的所有数据根本不切实际。半监督学习可以通过使用标记和未标记数据来帮助降低收集数据的成本。准确性:如上所述,同时使用标记数据和未标记数据有助于提高模型的准确性。这是因为使用标记数据可以阻止模型学习虚假相关性,而使用未标记数据可以添加有关数据中潜在模式的有价值的信息。节省时间:标记数据可能需要大量时间,因此半监督学习可以加快模型训练速度,因为不必全部标记数据。

本文将对半监督学习进行友好的介绍并解释其核心概念。

半监督学习原理

半监督学习的实际应用。粗线表示监督学习得到的决策边界。虚线显示了半监督情况的边界。点是未标记的数据点,三角形/加号是标记的数据点。图取自 van Engelen 等人。(2018)

上图显示了所有三种学习方案的实际效果。圆圈代表两个类的未标记数据点。圆圈和三角形对应于标记的样本。为了使未标记的样本有用,我们必须假设它们仍然包含对我们有用的信息。更数学地说:

基础边际分布p(x)应提供有关后验p(y|x) 的有用信息。

为了使半监督训练发挥作用,我们必须依赖三个主要假设:

平滑度假设

它指出,如果两个样本x1和x2在输入空间中接近,则它们应该共享相同的标签。例如,假设有一个描述汽车的数据集,其中包含重量和油耗。两个特征值较小的样本可能代表紧凑型汽车,而值较高的样本往往对应于 SUV。当我们还考虑未标记的数据时,这种假设会派上用场,因为我们希望它们共享最接近的标记邻居的标签。

低密度假设

从平滑假设,我们可以直接推导出另一个前提。类之间的决策边界应位于输入空间的低密度区域。这意味着,它应该位于很少有标记和未标记样本的区域。如果它位于高密度区域,则将违反平滑度假设,因为输入空间中接近的样本将不再共享相同的标签。

流形假设

机器学习任务的数据通常是高维的。尽管如此,并非所有特征都显示出相同水平的方差,这使得它们对模型的用处不大。因此,高维数据通常位于低维流形上(空间中的结构)。该信息可用于推断未标记样本的类别。

这三个假设构建了几乎所有半监督学习算法的基础。

半监督范式

最近的半监督学习算法的一件事是,它们都基于两种范式之一(有时甚至是两者)。

第一个范式称为 伪标记 ,它使用网络本身为未标记的数据生成真实标签。为此,模型通常使用需要获得的完全标记的子集进行预训练。然后将未标记的样本输入网络并记录它们的类别预测。如果样本的最大类别概率超过设定的阈值,则将相应的类别用作基本事实。然后可以使用这些样本以监督方式训练模型。随着模型的性能变得越来越好,可以使用相同的技术迭代地细化人工获得的标签。

第二种范式称为一致性正则化,它训练模型在输入同一图像的两个略有不同的版本时输出相似的预测。在许多情况下,原始图像的这些扰动版本通常是使用数据增强方法获得的,例如旋转、移位、对比度改变或许多其他技术。这样的训练使模型能够更好地泛化并且更加鲁棒。由于我们只是强制执行类似的预测,因此在这种情况下不需要类标签。因此,可以按原样使用未标记的数据。

总结

半监督学习是一种强大的机器学习方法,可以结合监督学习和无监督学习的优点。通过使用标记和未标记数据,半监督学习可以提高许多机器学习项目的准确性、成本和时间节省。它利用标记和未标记数据来生成一个模型,该模型通常比以标准监督方式训练的模型更强大。这些算法通常基于伪标签和/或一致性正则化。

半监督学习将监督学习和非监督学习的过拟合和“不拟合”倾向(分别)结合起来的能力,创建了一个模型,在给出最小数量的标记数据和大量的未标记数据的情况下,可以出色地执行分类任务。除了分类任务,半监督算法还有许多其他用途,如增强聚类和异常检测。尽管这一领域本身相对较新,但由于在当今的数字领域中发现了巨大的需求,算法一直在不断地被创造和完善。

不过,即使半监督训练通常比标准监督训练有所改进,也不能保证您自己的应用程序就是这种情况。研究表明,在某些有限的情况下,它甚至可能导致性能下降。

半监督学习确实是机器学习的未来。

参考:

https://www.elecfans.com/d/1411567.html

https://towardsdatascience.com/a-friendly-intro-to-semi-supervised-learning-3783c0146744

https://towardsdatascience.com/improve-your-models-performance-with-unlabeled-data-d6e78a57fadb