13.1 未标记样本

让学习器不依赖外界交互、自动地利用未标记样本来提升学习性能,就是半监督学习

要利用未标记样本,必然要做一些将未标记样本所揭示的数据分布信息与类别标记相联系的假设,最常见的是“聚类假设”,即假设数据存在簇结构,同一个簇的样本属于同一类别。另一种常见假设是“流形假设”,即假设数据分布在一个流形结构上,邻近的样本具有相似的输出值。“邻近”程度常用“相似”程度来刻画,因此流形假设可看作聚类假设的推广,但流行假设对输出值没有限制,因此比聚类假设适用范围更广。无论是聚类假设还是流形假设,本质都是“相似的样本拥有相似的输出”。

半监督学习可分为纯半监督学习和直推学习,前者假定训练数据中的未标记样本并非待预测数据,而后者则假定学习过程中所考虑的未标记样本恰是待预测数据,学习的目的就是在这些未标记样本上获得最优泛化性能。也就是,纯半监督学习希望学得的模型能适用于训练过程中未观察到的数据,而直推学习仅试图对学习过程中观察到的未标记数据进行预测。

13.2 生成式方法

半监督学习中通常假设未标记样本数远大于有标记样本数,此假设实际并非必须

有标记样本集![]()

未标记样本集![]()

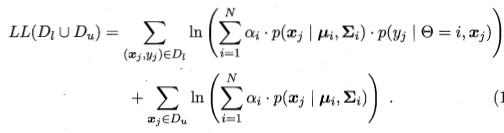

所有样本独立同分布,且都由一个高斯混合模型生成,用极大似然法估计高斯混合模型参数的对数似然函数为:

有两项组成,基于有标记数据 ![]() 的有监督项和基于未标记数据

的有监督项和基于未标记数据![]() 的无监督项,EM算法求解。

的无监督项,EM算法求解。

13.3 半监督SVM

半监督支持向量机,简称S3VM。

不考虑未标记样本时,SVM试图找到最大间隔划分超平面,在考虑未标记样本后,S3VM试图找到能将两类有标记样本分开,且穿过数据低密度区域的划分超平面,基本假设是“低密度分隔”,这是聚类假设在考虑了线性超平面划分后的推广。

TSVM:

有标记样本集![]()

未标记样本集![]()

yi∈{-1,+1}

l+u=m

学习目标是给出预测标记 ![]() ,

, ![]() ,使

,使

求解:采用局部搜索来迭代地寻找近似解

TSVM算法如下:

13.4 图半监督学习

给定一个数据集,可将其映射为一个图,数据集中每个样本对应于图中一个结点,若两个样本之间的相似度很高(或相关性很强),则对应的结点之间存在一条边,边的“强度”正比于样本之间的相似度。

G=(V,E),![]() ,E是一个亲和矩阵:

,E是一个亲和矩阵:

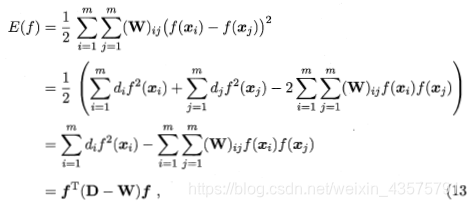

定义能量函数:

具有最小能量的函数f在有标记样本上满足f(Xi)=yi(i = 1,2,…l),在未标记样本上满足△f=0,其中△=D-W为拉普拉斯矩阵

13.5 基于分歧的方法

使用多学习器,而学习器之间的分歧对未标记数据的利用至关重要

多视图数据:一个数据对象往往同时拥有多个属性集,每个属性集就构成了一个视图。

协同训练:首先在每个视图上基于有标记样本分别训练出一个分类器,然后让每个分类器分别取挑选自己“最有把握的”未标记样本赋予伪标记,并将伪标记样本提供给另一个分类器作为新增的有标记样本用于训练更新……不断迭代,直到两个分类器都不发生变化。

协同训练过程简单,若两个视图充分且条件独立,则可利用未标记样本通过协同训练将弱分类器的泛化性能提升到任意高即使在更弱的条件下,协同训练扔可有效地提升弱分类器的性能

后理论研究发现,此类算法无需数据具有多视图,仅需弱学习器之间有显著的分歧(差异),即可通过相互提供伪标记样本的方式来提升泛化性能。

基于分歧的方法只需采用合适的基学习器,就能 较少受到模型假设、损失函数非凸性和数据规模的影响,学习方法简单高效、理论基础相对坚实、适用范围较为广泛。当有标记数据较少时,不易生成具有显著分歧、性能尚可的多个学习器

13.6 半监督聚类

现实的聚类任务中能获得一些额外的监督信息,于是可通过半监督聚类来利用监督信息以获得更好的聚类效果

聚类任务中获得监督信息大致有两种类型,第一种类型的监督信息是“必连”与“勿连”,“必连”指样本必属于同一个簇,“勿连”指样本必不属于同一个簇;第二种类型的监督信息是少量的标记样本。

K-means聚类为例:

第一种类型监督信息:

第二种类型监督信息: