篇章二:CUDA编程介绍(简易版)

目录

一、CUDA编程简介

CUDA是由NVIDIA推出的并行计算架构,可充分利用GPU的并行计算引擎,以更高效地解决复杂计算问题。

CUDA编程模型是一种异构计算模型,涉及CPU(主机)和GPU(设备)的协同工作。在CUDA中,主机代表了CPU及其内存,而设备代表了GPU及其内存。CUDA程序包含主机程序和设备程序,分别在CPU和GPU上执行。主机和设备之间可以进行数据通信,以便在它们之间传输数据。典型的CUDA程序执行流程如下:

- 分配主机内存并进行数据初始化。

- 分配设备内存并将数据从主机复制到设备。

- 调用CUDA核函数在设备上执行特定的计算。

- 将设备上的计算结果复制回主机。

- 释放设备和主机上分配的内存。

强烈建议先看完这两篇文献(强烈推荐):

(264条消息) CUDA 编程入门cuda编程入门A-Egoist的博客-CSDN博客

二、CUDA中的线程与线束

在CUDA编程中,线程(Threads)和线束(Warps)是两个重要的概念,用于管理和执行并行计算任务。

线程(Thread): 线程是CUDA编程中最基本的并行执行单位。在CUDA中,每个线程独立地执行一个计算任务,并且可以访问自己的寄存器和局部内存。GPU上的线程数量非常庞大,通常可以有成千上万个线程同时执行,从而实现高度的并行计算。线程在CUDA中通常由线程索引(Thread Index)来标识,使用三维的线程索引(x, y, z)来表示线程在块(Block)中的位置。

线束(Warp): 线束是CUDA中的一个重要概念,它是一组连续的线程,通常包含32个线程。线束是GPU硬件层面的概念,在一个时钟周期内,线束内的所有线程同时执行相同的指令。这意味着线束内的线程必须保持一致性,即它们执行的代码路径和分支条件必须相同,否则会导致线束内的线程出现分支发散(Thread Divergence),从而降低执行效率。因此,在CUDA编程中,尽量保证线束内的线程执行相同的代码路径,以获得最佳的性能。

线程和线束之间的关系: 在GPU上,线程组织成线束。当GPU执行一个指令时,线束内的所有线程同时执行相同的指令,这就是线束级的并行。然后,GPU会同时执行多个线束,这就是线程级的并行。多个线程块在GPU上同时执行,每个线程块内又包含多个线程,这样就实现了GPU的高度并行计算。

CUDA编程充分利用了线程和线束的并行能力,通过合理的线程组织和并行计算,实现高性能的GPU计算。编写高效的CUDA程序需要充分理解线程和线束的概念,并注意避免线束内的分支发散,以保证最佳的性能。

三、CUDA编程示例代码

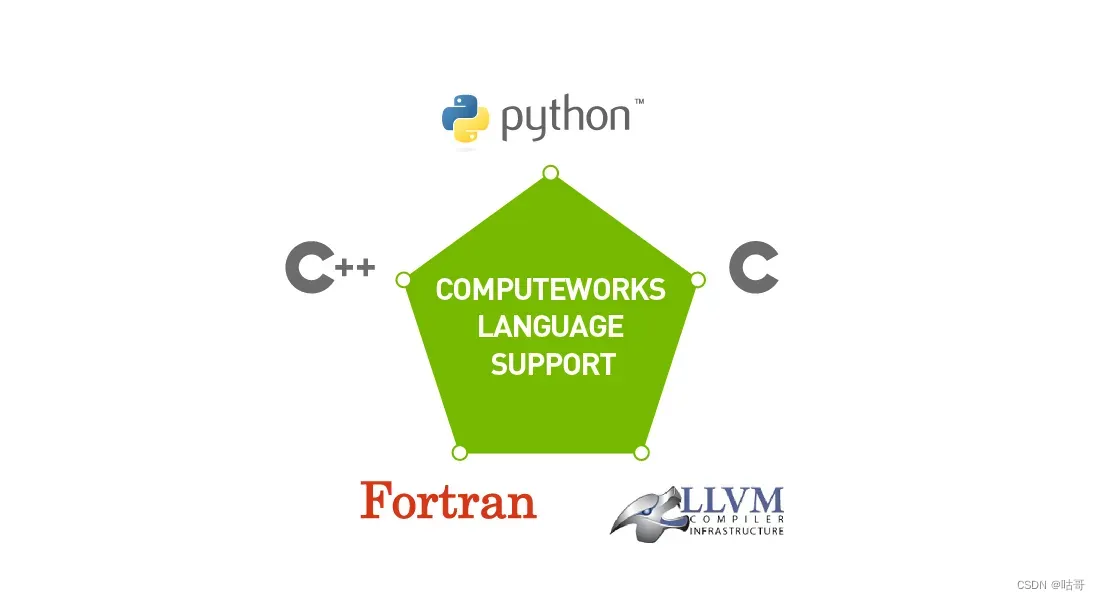

NVIDIA提供了CUDA C/C++编程模型。CUDA C/C++是一种扩展了标准C/C++语法的编程语言,它提供了用于在GPU上执行并行计算的特殊语法和库函数。在Python中利用CUDA进行并行计算,其中最常见的是Numba和PyCUDA。

CUDA程序的一般步骤包括:

- 使用C/C++编写主机(CPU)上的代码,用于控制和协调GPU的操作。

- 使用CUDA C/C++编写GPU上的核函数,这些核函数包含要在GPU上并行执行的计算任务。

- 使用CUDA API调用来管理GPU内存和执行核函数。

- 编译和链接CUDA代码以生成可执行文件。

简单演示如何使用CUDA来进行向量相加的操作。(这将涉及到线程和线束的使用!!!)

以下是一个简单的CUDA代码示例,实现了两个向量的元素相加操作:

#include <stdio.h>

// CUDA核函数,将两个向量相加

__global__ void addVectors(float *a, float *b, float *c, int n) {

int tid = blockIdx.x * blockDim.x + threadIdx.x;

if (tid < n) {

c[tid] = a[tid] + b[tid];

}

}

int main() {

int n = 1000;

float *a, *b, *c; // 输入和输出向量的指针

float *d_a, *d_b, *d_c; // GPU上的输入和输出向量的指针

int size = n * sizeof(float);

// 为输入和输出向量分配内存

a = (float*)malloc(size);

b = (float*)malloc(size);

c = (float*)malloc(size);

// 为GPU上的输入和输出向量分配内存

cudaMalloc(&d_a, size);

cudaMalloc(&d_b, size);

cudaMalloc(&d_c, size);

// 初始化输入向量

for (int i = 0; i < n; i++) {

a[i] = i;

b[i] = i * 2;

}

// 将输入向量从主机内存复制到GPU内存

cudaMemcpy(d_a, a, size, cudaMemcpyHostToDevice);

cudaMemcpy(d_b, b, size, cudaMemcpyHostToDevice);

// 启动核函数,进行向量相加操作

int blockSize = 256;

int numBlocks = (n + blockSize - 1) / blockSize;

addVectors<<<numBlocks, blockSize>>>(d_a, d_b, d_c, n);

// 将输出向量从GPU内存复制到主机内存

cudaMemcpy(c, d_c, size, cudaMemcpyDeviceToHost);

// 打印输出向量的前10个元素

for (int i = 0; i < 10; i++) {

printf("%f + %f = %f\n", a[i], b[i], c[i]);

}

// 释放内存

free(a);

free(b);

free(c);

cudaFree(d_a);

cudaFree(d_b);

cudaFree(d_c);

return 0;

}

CUDA编程优化涵盖算法设计、内存访问、线程管理和硬件细节等多个方面,以最大程度地发挥GPU并行计算能力,提高性能。

总结

CUDA入门容易深入难!学习CUDA编程可以从掌握并行计算基础开始,并逐步深入了解CUDA的核心概念、API和编程模型,在GPU上充分发挥并行计算能力。

参考资料:

(264条消息) CUDA 编程入门cuda编程入门A-Egoist的博客-CSDN博客